在为电子游戏创作音乐时,我经常思考如何才能给玩家带来更有意义的体验。通常,作曲家会跟创意总监和音频总监探讨剧情、情感、主题、色彩以及与手头项目相关的其他创作元素。除此之外,我个人还会想了解音乐与玩家的互动方式。

我本身是一个受过正规训练的作曲家,同时又热爱电子音乐。我喜欢采用独特的方式将实录音乐和数字处理相结合。我之前就因为在《Remember Me》原声音乐中采用“开创性的作曲方式”而获得了很多奖项。不过,有一点对我来说同作曲本身一样重要,那就是互动方式。

这么说吧,在为《Remember Me》录音的时候,我们请了伦敦一个 70 人的管弦乐队,然后让音乐家们在140 bpm 的曲速下,对照玩家动作进行每一拍的演奏。假如你是作曲家或音频总监或者但凡有点游戏音乐方面的经验,都应该知道这可没那么容易。虽然最终做出来的效果非常不错,但是当时我发誓以后再也不接这么麻烦的差事了……直到有人介绍我做《Get Even》。

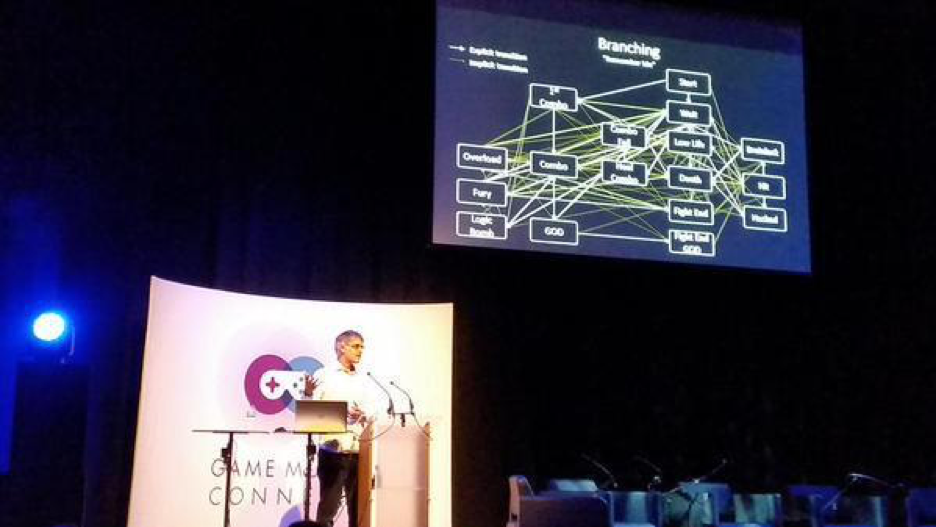

Audiokinetic 产品副总裁西蒙·阿什比 (Simon Ashby) 在 Game Music Connect 峰会上分享《Remember Me》互动音乐分支技巧(伦敦)

Get Even

《Get Even》由波兰开发商 The Farm 51 开发,并由 Bandai Namco 发行。在他们跟我介绍这款游戏的概念时,我就被震撼到了。他们想制作一款取材于现实世界的 VR 游戏,在其中融合射击、步行模拟、侦探、剧情等多种元素。他们希望玩家在结束游戏后忍不住为之慨叹。这听起来简直太神奇了,于是我欣然接受并全情投入了这份工作。

《Get Even》:“实时生成的互动音乐”简介

什么是互动音乐?

这些年来,我满世界地跟作曲家、开发商、发行商宣扬互动音乐,与他们分享我的构想并在汲取业界专业人士经验的基础上不断地进行完善。在很多次交流中,我发现只要音乐能随着玩家动作变换就会产生互动。没错,我们是可以创作或制作一些好听的音乐,然后直接导出分轨并创建分层就完了。这样做看起来的确很有效率,但是我们真的应该就此止步吗?!我对此表示怀疑。技术手段在不断革新。我们也做出了很多改进,比如 AI、灯光、物理、着色等等。然而,音乐方面却没有多大进展。目前,互动音乐还在发展初期。我希望在接下来的 10 年中,我们能进一步拓宽音乐的应用范围。

电子游戏都能实时渲染,为什么音乐就不可以呢?

我对电子游戏一直都很着迷,因为屏幕上移动的像素会在观看时同步渲染。画面会随着我的动作不断变化,就像有了生命一样。在音乐领域,与之最为相似的就是电子音乐。在使用合成器(模拟)或计算机(数字)作曲时,可以通过电流、CPU 或 DSP 实时生成声音。这跟移动的像素一样让我感到着迷。在最初玩游戏的时候,我们都习惯了实时生成的音乐。借助主机系统中集成的芯片组,音乐可以在需要时随着动作不断变换。当市场上推出配有光驱的 PlayStation 时,我们失去了某些东西。音乐变成了被动播放的背景乐曲,只不过换成由音乐家演奏实录,而且听起来还不错。多年以后,我们才开始创作可以随着玩家动作实时变换的多层音乐(一般通过音量实现)。现在,我很高兴我们能同时融合互动实录音乐和实时生成的音乐了。我称之为 Hybrid 互动音乐 (Hybrid Interactive Music,即 HIM。译注:Hybrid 强调“来源或者成分不一”;此处表示“离线录制”和“实时生成”音乐共存)。

Jerobeam Fenderson - Reconstruct -《Oscilloscope Music》视听专辑

什么是 Hybrid 互动音乐 (HIM)?

如今,我们把音乐数字化了。现场演奏、合成器和采样库都变成了文件中的波形(如 MP3 或 WAV)。这些年来,我们拥有了更大的控制余地,开始尝试编辑这些文件并创建多个横向分段和纵向分层(如前奏、循环、尾声循环),以便提升游戏的灵活性和音乐性。这种横向和/或纵向处理目前仍是制作互动音乐的主要方法。如果你还是不明白,那我这么说吧:Wwise 可以帮助你获得像《Remember Me》、《Get Even》还有市面上很多游戏大作一样绝妙的配乐效果。

Wwise 几年前在其引擎中整合了 MIDI。多亏了它强大的多用性,我们才有了两种不同的使用选择。第一种,是利用 MIDI 播放 Wwise 生成的声音。Audiokinetic 提供了一些基本的合成器,方便实时生成音乐(无需录制,直接由处理器生成)。第二种,将 Wwise 用作由 MIDI 触发的采样器,实现各种控制功能(ADSR、力度变化、键位映射)。这简直太棒了!

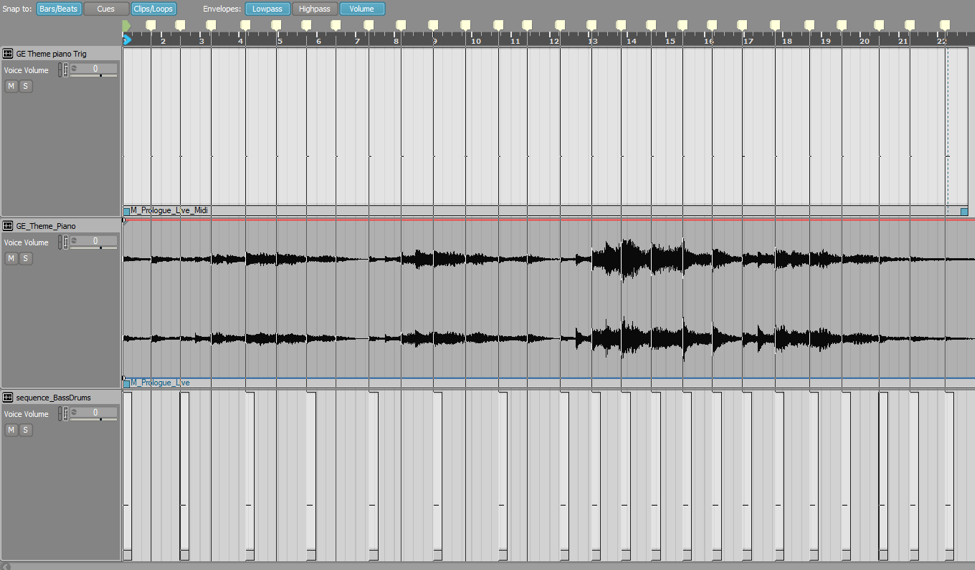

不过,Wwise 真正的突破之处在于预录文件和 MIDI 之间的相互关联。你可以在 Music Editor(音乐编辑器)中将两者自由地进行结合。也就是说,你可以为管弦乐器录制音轨,同时创建一个合成器,用MIDI 播放贝斯旋律,再加上由 MIDI 随管弦乐器一起触发的架子鼓采样器。这就是我所说的 Hybrid 互动音乐,即随着预录音乐段落一起播放实时生成的音乐。

《Get Even》:“Hybrid 互动音乐”示例

为何 HIM 如此有趣?

首先,来聊一聊曲速。我们都知道数字音频轨道无法在不改变音高的情况下改变曲速(娱乐系统目前还不支持实时音高校正)。所以,根本就没法调整曲速。比方说,如果你想在游戏中为玩家提供反馈,可是最好的创作方式就是根据与物体的距离或玩家生命值逐渐加快音乐的曲速,怎么办呢?这时,假如能结合使用 MIDI、采样器和 RTPC,就可以轻而易举地实现。

接着,再来说说乐器的力度变化。你可以创建一个乐器(如钢琴),并让其以弱奏或强奏的方式播放每个音符。也就是说,你可以根据游戏参数创建实时力度变化,实现精确而自然的控制。

以上两个例子让我们对 Wwise 多少有了些了解,但其在 Hybrid 互动音乐创作中发挥的作用远不止如此。它可以令工作变得非常有创意,让你感觉总有无穷无尽的可能。

《Get Even》:MIDI 底鼓(根据 RTPC 调整曲速并改变节奏型和力度)

HIM 还不足以成就《Get Even》

前面聊了 Wwise 所提供的技术功能,下面我们再说回《Get Even》。正如之前所说,《Get Even》是一款取材于现实世界的 VR 游戏。你控制的角色在游戏期间全程穿戴 VR 设备。所以,我想到的第一个问题就是“如何在 VR 中制作音乐”?这让我感到十分困扰,似乎音乐没法满足这种全新体验的需要。《Get Even》游戏本身给人一种源自现实世界的真切感受,而音乐却可能是抽象而游离于现实的。

在经过一番琢磨之后,我总结出了一条规则:“所有音乐都必须以剧情元素为起点,然后再慢慢地从现实中抽离出来”。这样会让玩家觉得音乐是跟游戏世界相连的,而不仅仅只是背景衬托。

作为一名作曲家,我一直希望能创作出让人意想不到而又富有意义的音乐。所有的音轨都是从特殊的声音效果“扭曲”衍变而来。我喜欢用一种出人意料的方式来满足游戏独特的需求,在使用 Wwise 的时候就是这样。我不喜欢墨守成规,而是想创造从来没有过的东西,让游戏变得更有意义。在这里,我要插一句说说 Audiokinetic 多么让人不可思议。他们在为软件增添一项功能的时候,并不只是单单地满足某种特定需要,而是将其和 Wwise 中的其他功能有机地进行结合。比方说,所有互动音乐设计都可以与游戏中的发声体紧密地关联起来。这真是太神奇了!我可以利用 HIM 播放音乐序列并将其融合到 3D 游戏世界中,同时与 2D 预录轨道同步。这为我提供了各种各样的可能性,让我有机会把《Get Even》做得更有意义。

最终成果

于是,我决定在每一个游戏情境中都采用这种独特的音乐创作方式。最终,我在整个游戏中设计了 17 种不同的互动音乐使用方式。比如让剧情声音与预录音乐同步、由平台实时生成持续低音(drone)、将鼓声编成 MIDI 序列、从 3D 分层过渡到 2D、加强画面与音乐之间的关联性等等。下面是 The Sixth Axis 对这款游戏原声音乐的评论:“奥利维尔·德里维耶创作的原声音乐无疑是今年最好的作品之一,其在恐惧、疑惑和悲痛情感之间的过渡非常完美。仔细听的话甚至能听到各种环境噪声,像 Cole 的呼吸声、地板嘎吱声、煤气管滋滋声,整个与音乐交织在一起。它的作曲方式非常巧妙,感觉像是与游戏本身融为了一体,而不是像大多原声音乐那样浮于表面。”

Hybrid 互动音乐能否引领未来发展:第 II 部分 - 技术演示

评论