《Blade Runner: Revelations》是 Seismic Games 和 Alcon Media Group 最近发布的一款以《Blade Runner》系列经典影片为蓝本的 VR 互动手游。我们在 Hexany Audio 的朋友参与了幕后的音频设计工作,与 Google Daydream 团队联手打造了这一备受期待的项目。下面来听听 Hexany Audio 音频总监兼创始人理查德·勒德洛 (Richard Ludlow)、技术声音设计师尼克·托马塞蒂 (Nick Tomassetti) 和作曲家兼声音设计师杰森·沃尔什 (Jason Walsh) 的经验之谈。

在为如此别具一格的听觉世界创作和设计音频时,融入了怎样的创新理念?对于前后拍摄的《Blade Runner》系列电影,有何深入思索?从中汲取了哪些灵感?从声音设计的整体美学来看,模拟元素好像要多于数字元素。是不是依据原版电影的音频分轨做出了这样的选择?

杰森:考虑到这款游戏发生的时间线位置,我们很早就决定要尽量贴合原版《Blade Runner》电影的声音和美学风格。关键是要在游戏世界的音景设计中融合《Blade Runner》影迷熟悉的声音元素。不过,我们仍有很大余地尝试不同的声音设计方案,以期在原版电影和《Blade Runner 2049》之间找到契合点。

理查德:我们当时就跟 Seismic 开发团队深入探讨过这个问题,反复琢磨如何在这款游戏中巧妙地融合《Blade Runner》电影世界的声音元素。在这个过程中,我们认真思考了怎么做才能让《Blade Runner: Revelations》与电影的时间线贴合,同时把创意总监的理念融入游戏世界。最终证明,选择在《Blade Runner: Revelations》中大量运用模拟元素确实没错。不过,正如杰森所说,我们还有幸收到了《Blade Runner 2049》的分轨,同时参考这些分轨把两个世界融为了一体。

在游戏中,最终选用了多少原版分轨的内容?创作了哪些新的内容?

杰森:你在游戏里听到的所有声音都是原创内容!我们收到的分轨为此提供了很好的参考。对于这样的系列电影,我觉得非常有必要深入地研究原始素材。这会为合理构建声音调色板带来很大帮助。

在游戏中,玩家会通过跳到不同的节点(比如游戏环境中的固定位置)进行导航。从技术层面说说你们是如何利用这种基于节点的机制来设计混音的?

尼克:在《Blade Runner: Revelations》基于节点的导航系统中,玩家所处的高度和位置都是固定的,这让混音稍稍容易了些,因为真正起作用的变量只有朝向。在有些情况下,我们可以针对每个节点,利用 RTPC、State(状态)和特定于节点的 Wwise Event(事件)来进行混音。

在第一关,玩家走进一个繁华喧闹、阴雨绵延的唐人街小巷。在这儿,我们使用了 RTPC 来控制雨声的音量,并且把关注点从一个主要声音焦点转移到另一个焦点。在玩家往巷子中间走的时候,会到达一个节点。在那儿,能听到克利须那 (Hare Krishna) 僧众诵经声、厨师炒菜声和隐隐约约的俱乐部音乐声;但是,一旦玩家选择转向某个关注点,我们就会以所选关卡地段为中心调整混音,进而留出空间给较为细微的环境声。

能不能详细说说在基于对象的声音和 Ambisonics 录音之间是怎么取舍的?在设计空间混音时是如何实现融合的?

理查德:这款游戏里其实并没有使用 Ambisonics 录音。虽然 Wwise 有一些非常巧妙的 Ambisonics 混音功能,但是出于种种原因,我们在 VR 游戏中一般还是只用单声道、立体声和四声道文件。尤其是对于 Daydream 这样的移动平台,必须考虑各种技术限制。

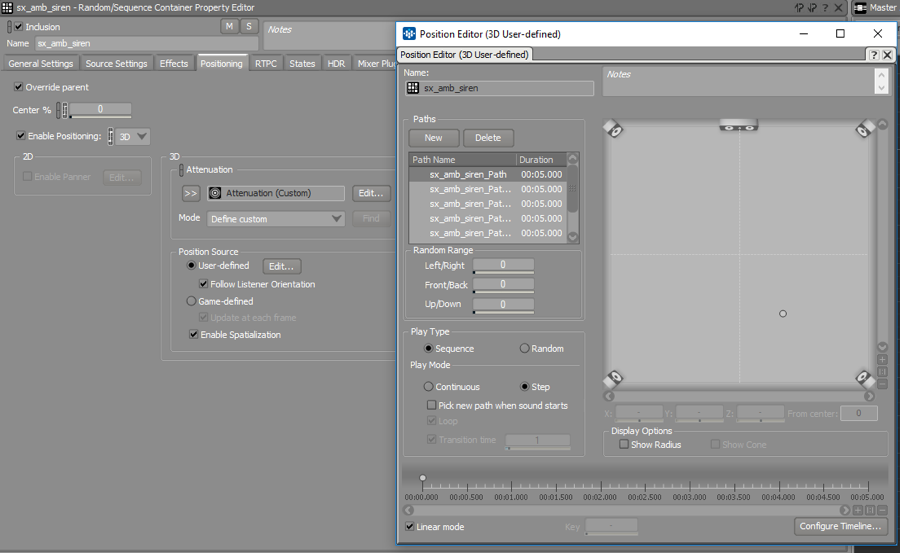

不过,我们可以在游戏环境中整合各种空间化音频源,藉此得到绝妙的混音。除了将单声道源和立体声源绑定至游戏世界中的环境声发声体外,我们常常还会使用 Wwise 的 User-defined(用户定义)定位功能。如此一来,在构建空间化环境声的时候,便不用再把每个元素都绑定到 Unity 场景中的对象上了。

这样混音自然就会包含大量空间化元素,根本不需要使用 Ambisonics 录音。

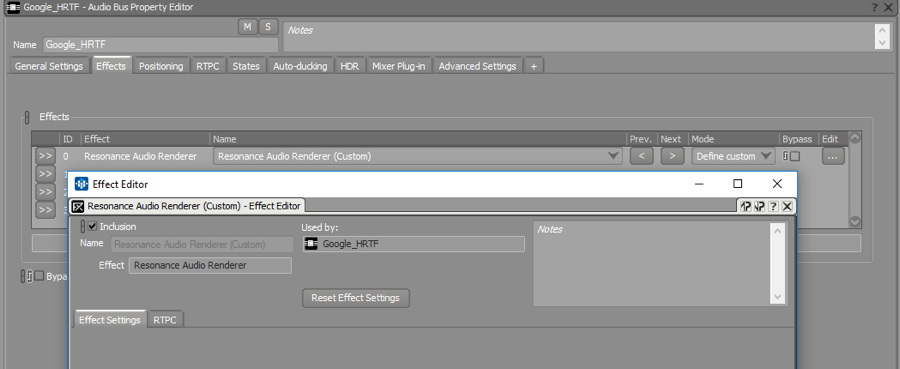

这个项目运用了 Google Daydream 和 Google Resonance。请问,结合 Wwise 开发 VR 手游是什么感觉?在开发过程中都有哪些顾虑?有没有因为技术限制而做出让步?

理查德:Wwise 在移动体验方面的表现确实很棒。它可以轻松完成针对平台的优化,帮你实现跨平台设计。不过,这并不是 Daydream 游戏重点考虑的问题,因为它支持的设备比较有限。当然,移动平台的技术限制肯定还是有的。

就空间 HRTF 插件而言,Google Resonance 在性能和 CPU 效率方面绝对没的说,但在功能和音质方面的表现较为有限。所以,我们在使用的时候就比较慎重,一般只用在需要玩家敏锐地觉察其在游戏世界中所处位置的游戏元素上。比如,在《Blade Runner: Revelations》中经常会听到敌人的脚步声或枪声,它们可以帮助玩家快速确定敌人的枪声来自哪里,进而作出反应。

总的来说,空间 HRTF 插件可以使声音素材的定位更明确,让游戏的维度更有层次。不过,为了增强空间感往往需要进行滤波,而这会对实际音质多少产生一些负面影响。比如,有时声音会不够清脆响亮。所以,我们在设计声音时对此就特别注意。在 VR 游戏中,为了消除这种影响,我们经常会采用一种自称为“多维空间化”的方法。

为此,我们会把多层声音绑定到游戏世界中的同一对象上,而只对其中一层使用 HRTF 插件。这样不用对整套声音进行滤波,就可以把玩家注意力吸引到空间中的恰当位置,也无需担心空间化插件会产生负面影响。

假设有个非玩家角色 (NPC) 在左侧使用武器向玩家射击,我们就会把枪声分为 3 层:HRTF 分层、常规单声道 3D 空间化层(不使用 HRTF 插件)、2D 立体声或四声道分层(主要是无方向特性的低频能量,起增强作用)。这样就可以利用 HRTF 插件制作出绝妙的空间化声音,而又不会影响到音质。

在实现创新理念的过程中,感觉哪些 Wwise 功能特别有用?

尼克:对这个项目来说,最有用的当然是 User-defined 定位功能。由于采用基于节点的导航,所以基本上利用 Wwise 中的 User-defined 定位功能就足以设计整套环境声。这样我们就可以多花些时间在 Wwise 中设计,少花些时间在 Unity 编辑器中调整。

有没有遇到什么特别的技术难题?

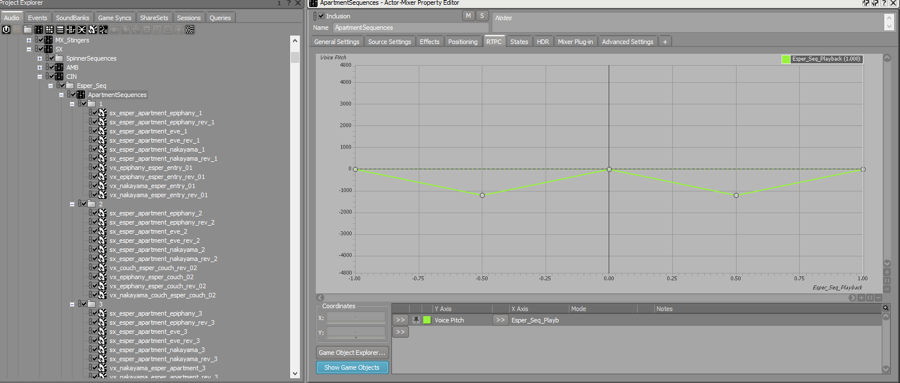

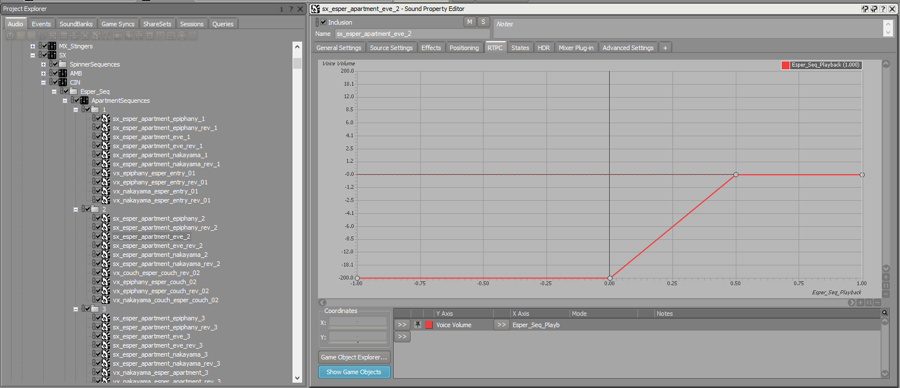

尼克:在声音方面技术难度最高的是 Esper 片段。在这些片段中,玩家必须使用 Esper 工具窥视过去,以此来调查犯罪现场。在玩家单击片段时,会直接以全息形式再现过去发生的事件。在片段播放完毕后,玩家可以使用控制器随意地倒带、慢放片段。当然,所有这些都需要配上空间音效。

我们是这样解决这个难题的:设置正放和倒放两种音效,它们会同时播放,但在 RTPC 的控制下,只有一种音效可以被听到。假如玩家改变播放方向,Unity 中的脚本就会检查播放位置,经过运算跳转至倒放文件的正确位置。最终形成一个无缝播放系统。

对于这个项目,最自豪的事情是什么?

杰森:无论是在声音还是音乐方面,《Blade Runner》系列影片做得都非常出色。《Blade Runner: Revelations》也丝毫不差。我很高兴自己设计的声音能在游戏叙事中发挥重要作用。

理查德:考虑到移动平台对 VR 的限制,我觉得能取得这样的成果很不容易。有时的确需要做出一些牺牲。但是,我们也在游戏中融入很多了创意,最终效果还是相当不错的。尤其是尼克设计的 Esper 音频工具播放系统,真的太棒了。利用它,不仅可以实时拖动播放一些片段中的音频,还能产生一些奇妙的特效。

在这个项目中,最有意思的部分是什么?

杰森:塞博朋克 (Cyberpunk) 是我最喜欢的一种体裁,能有机会浸入《Blade Runner》构筑的电影世界,那感觉真是其乐无穷。

理查德:对我来说,肯定是参与打造这样标志性的 IP,从头开始重新构想,再现大家熟悉的声音世界。这些年来,我们也参与创作过其他一些比较老的系列作品。能够深度解读原版内容和素材,了解其中的制作手法,经过重新构想再应用到项目中,总是充满了乐趣。

能不能说说跟这款游戏的开发商之间的关系?相互之间是怎么协作的?

理查德:当初是 Seismic Games 最先找到我们做这个项目,跟他们一起合作是件非常愉快的事情。当然,Alcon 也有参与,不过我们平时主要是跟开发团队打交道。我们大部分时间都在分布式开发模型下工作,通过版本控制系统访问游戏引擎/项目,从而作为团队的一部分参与到协作中。就这个项目而言,还有一个巨大的好处,就是我们离 Seismic 办公室很近。有什么需要,我们随时都可以过去。必要的时候,他们也可以到我们工作室来进行混音。

另外,我们还为 Daydream 搭建了一套完善的混音设施,方便开发团队过来检验混音效果。我们会在 VR 开发室安排一个人戴上 Daydream 头盔。然后,通过 Chromecast 电视棒把游戏画面推送到电视上。这样工作室里的所有人就可以一起观看。然后,采用无线方式将 Wwise 与运行游戏版本的设备相连,以便实时修改混音。最后,把 Pixel 的 1/8 英寸音频输出电缆连接到耳机放大器/分流器,方便四到五个人一起试听游戏音效,同时在电视上观看游戏画面。如此一来,多人实时混音会议就会变得非常简单!

Richard Ludlow

音频总监兼所有者

作曲家兼声音设计师

评论