‘Dirty Laundry by Blake Ruby (더러운 빨래 - 블레이크 루비)’ 모바일 VR 앱: 오디오 소개.

안녕하세요, 저는 줄리안 메시나(Julian Messina)라는 오디오 엔지니어입니다. 저는 제 사업 파트너인 로버트 쿰버(Robert Coomber)와 음악가 블레이크 루비(Blake Ruby)와 협업하여 360 몰입형 음악 경험을 제작했습니다. 이 글은 저희가 이 프로젝트에 Wwise를 사용하기로 선택한 이유를 설명합니다. 저희가 사용한 장비 구성을 살펴보고, 작업하는 동안 마주쳤던 문제들을 어떻게 해결하여 블레이크의 팬 분들에게 최고의 경험을 드릴 수 있게 되었는지 알려 드리겠습니다.

소개

로버트와 저는 모두 최근에 미국 벨몬트 대학교(Belmont University)를 졸업한 오디오 엔지니어입니다. 대부분의 오디오 엔지니어처럼 저희도 음악과 시각 예술을 굉장히 사랑하죠. 이 두 예술이 함께 작동하는 방식을 보면서 저희는 이 예술의 사용자 경험을 높여주는 혁신적인 방법을 찾는 데에 힘을 쏟고 있습니다. 오늘날 음악과 시각 예술을 위한 아름다운 표현을 만들어내는 데에 있어 차세대 혁신은 바로 공간 음향과 게임 엔진이라고 생각합니다. 그래서 저희는 ‘Dirty Laundry by Blake Ruby(블레이크 루비의 더러운 빨래)’라는 몰입형 프로젝트를 제작했죠.

배경 스토리: 왜 3D Audio를 선택했을까요?

로버트와 제가 이 몰입형 프로젝트를 작업하기 전에 저는 블레이크 루비의 'A Lesser Light to Rule The Night(밤을 정복하기 위해선 빛을 조금 잃어야 한다)'라는 레코드 작업에 참여했었습니다. 이 레코드를 작업하면서 블레이크가 거의 모든 부분을 직접 녹음한다는 것을 알게 되었죠. 그래서 몰입형 360 환경을 통해 블레이크가 얼마나 재능있는 사람인지를 팬 분들에게 공유하면 좋을 것 같다는 생각이 들었습니다. 저희 모두 결코 쉬운 작업이 아닐 거라는 건 알았지만, 블레이크가 프로젝트에 대해 기대하고 인내심있게 기다려준 덕분에 프로젝트를 훨씬 더 원활하게 진행할 수 있었습니다.

‘Dirty Laundry’ 프로젝트를 시작하기 전에 저희는 수많은 360 콘텐츠를 봤습니다. 대부분의 콘텐츠에서 특히 오디오 부분이 좀 실망스럽더군요. 저희가 본 360 프로젝트의 오디오는 모노나 스테레오가 대부분이었고, 공간화되었더라도 사운드가 필터링되고 균형이 맞지 않거나 너무 역동적으로 느껴졌습니다. 음악 작업에서만큼은 그냥 듣는 것만도 못한 결과물은 절대 허용할 수 없다고 생각했죠.

저희는 이번 프로젝트를 통해 몰입형 360 오디오 경험을 제대로 전달해보기로 마음 먹었습니다. 그런 의미에서 블레이크와의 작업은 올바른 음향적 표현을 제작하는 데 깊은 고민을 해볼 수 있었던 좋은 시간이 되었죠. 맨 처음 풀어야 했던 과제는 바로 이 프로젝트를 가장 제대로 느낄 수 있는 최적의 방법을 찾는 것이었습니다. 저희는 콘텐츠를 직접 다운로드할 수 있는 애플리케이션으로 제공하는 것이 브랜드와 오디오 경험 측면에서 가장 적합하다고 판단했습니다. Facebook이나 YouTube에서 360 경험을 주최할 수도 있지만 저희 목표는 가장 높은 품질의 경험을 선사하는 것이었습니다. 뿐만 아니라 대부분의 소비자들은 VR 헤드셋이 없다는 부분을 해결해야 했습니다. 모바일 VR이 Oculus Quest와 같은 시스템에서 인기를 얻기 시작했지만 블레이크의 모든 팬들이 이런 장비를 갖고 있지는 않으니까요. 그리고 '게이머'들에게만 제공할 것이 아니었기 때문에 iOS에서 배포하기로 했습니다.

Wwise를 선택한 이유

프로젝트에 Unity를 사용하면 어떨지 살펴보기 시작했지만 저희가 원하는 부분에서 제약이 있다는 것을 점차 알아가게 되었습니다. 그래서 보다 높은 차순의 채널 개수로 고음질 음향을 제공하기 위해 대안을 찾아보기 시작했죠. Wwise를 사용할 경우 최종 믹스를 16채널 앰비소닉 오디오로 제공할 수 있었습니다. 이보다 낮은 설정의 경우 음질과 믹스 표현이 현저히 떨어지더군요. 얼마 후, Wwise 시스템을 이용하면 몰입형 음악을 제작할 때 훨씬 유연하게 작업할 수 있을 뿐만 아니라 사운드 품질을 희생시키지 않아도 된다는 것을 생각해냈습니다. 이 부분은 애플리케이션의 프로그래밍 부분이 슬슬 속도를 내기 시작하면서 더욱 분명해졌죠.

이 프로젝트는 제작에서부터 사전 제작, 구성, 설계, 구현까지 변수가 정말 많은 복잡한 프로젝트였습니다. 그렇기 때문에 프론트/백 엔드에서 정말 많은 시간을 쏟아야 했죠. 특히 iOS에서 배포해야 했기 때문에 더 그랬습니다. 이 복잡함 속에서 저희가 걱정하지 않아도 됐던 한 가지가 바로 '어떻게 들릴 것인가'였습니다. 아티스트와 작업할 때 원본 사운드와 거의 동일하거나 아주 근접한 사운드를 만들어내는 것은 오디오 엔지니어인 저희가 하는 일 중에서 아주 큰 부분이었습니다. 이 부분을 Wwise로 해결할 수 있어서 정말 다행이었죠. 특히 블레이크의 팬 분들에게 고음질의 몰입형 음악을 처음으로 소개할 때 강력하고 기억에 남는 경험을 선사할 수 있어서 정말 만족스러웠습니다.

본격적인 제작: 난관을 마주치다

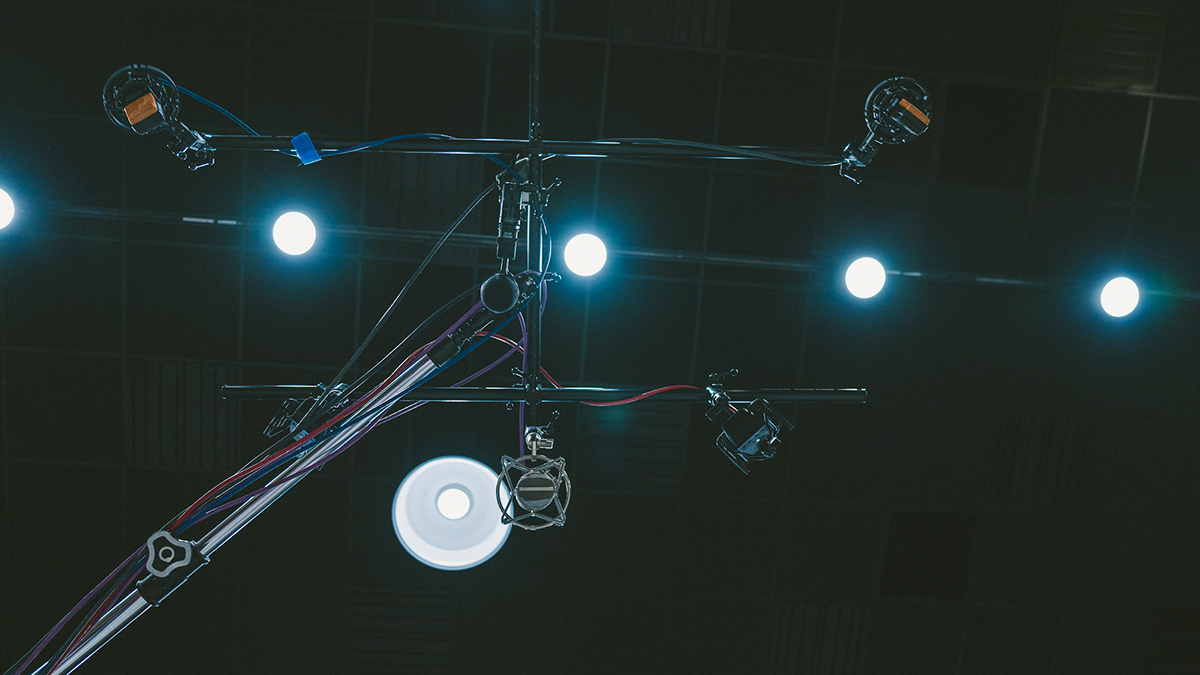

실제 제작은 Columbia Studios A(콜롬비아 스튜디오 A)에서 진행되었습니다. 이 공간에서는 저희가 필요한 방식으로 세트를 구성할 수 있었으며 Starbird SB-1 스탠드, Pro Tools HD와 같이 꼭 필요한 장비가 구비돼 있었죠. 저희는 스팟 마이크와 5.0 서라운드 마이크 배열(OCT 5:Optimized Cardioid Triangle)뿐만 아니라 1차 앰비소닉 마이크(Sennheiser AMBEO)를 트래킹했습니다. 모니터링의 경우 다섯 개의 Yamaha HS5 활성 스피커와 KLH 활성 서브 우퍼를 사용하여 중앙 채널 스피커를 북쪽으로 +90˚, 좌우 채널을 북쪽으로부터 ±30˚로 설치하고, 왼쪽 서라운드 후면 스피커와 오른쪽 서라운드 후면 스피커는 북쪽으로부터 ±110˚로 설치했습니다. 추가적으로 헤드폰 출력이 dearVR Ambi Micro 플러그인을 사용해서 바이노럴로 디코딩된 앰비소닉을 모니터링하도록 설정했습니다. 서라운드/앰비소닉 오디오를 캡처할 때 가장 걱정되었던 것은 스텝 게인 팟과 낮은 왜곡을 사용하며 서로 대응하는 프리 앰프를 사용하는 것이었습니다. 그래서 저희는 8 채널 Millenia HV-3D를 사용했습니다.

작업 결과를 들어보니 예상한대로였습니다. 연주마다 녹음된 서라운드/앰비소닉 트랙이 쌓이면서 노이즈 플로어가 높아졌을 뿐만 아니라 스팟 마이크와 앰비소닉 마이크 사이에서 자연적으로 코러스가 발생했죠. 이 때문에 보컬의 일부가 썩 만족스럽지 않았습니다. 일반적인 경우라면 쉽게 해결할 수 있는 문제지만, 3D 오디오 프로젝트인지라 문제가 빠르게 복잡해지기 시작했습니다. 노이즈 플로어를 해결하기 위해서는 서라운드/앰비소닉 마이크를 필터링해야 했습니다. 이 작업은 현실 존재감뿐만 아니라 후반의 공간화 과정을 위한 이미징에도 영향을 끼치게 되거든요. 코러스 문제를 해결하기 위해서는 서라운드/앰비소닉 녹음이나 스팟 마이크에서의 특정 녹음을 골라야 하는데, 이럴 경우 정보가 많이 손실되죠.

노이즈 플로어와 코러스 문제 해결하기

노이즈 플로어와 코러스 문제를 해결하기 위해서 저희는 Columbia Studios로 다시 돌아가 공간의 앰비소닉 임펄스 반응을 녹음했습니다. 이 임펄스 반응은 나중에 AmbiVerb라는 앰비소닉 3D 중첩 잔향에서 사용됩니다. 공간의 임펄스 반응을 수집하기 위해 최대한 비슷한 반사음을 수집할 수 있도록 녹음 때 설치했던 것과 최대한 비슷하게 공간을 구성해야 했습니다. 그리고 임펄스 반응을 녹음할 때에도 동일한 Sennheiser AMBEO 마이크와 Millenia HV-3D 마이크 프리 앰프를 사용했습니다. 처음에는 공간의 각 연주 위치에 배치된 Yamaha HS8 활성 스피커로 정현파 스윕을 출력하여 Pro Tools로 녹음했습니다. 다음으로는 각 연주 위치에 배치된 풍선으로부터 임펄스 반응을 녹음했습니다. 그리고 이 두 임펄스 반응을 서로 비교했습니다. 정현파 스윕을 중첩/역중첩한 후에 계획한대로 작동할 거라고 미리 단정짓고 싶진 않았어요.

임펄스 반응을 제작하고 새로 동기화한 보컬 추가 녹음과 합치고 After Pro Tools에서 스템을 제작한 후에 드디어 오디오 믹스를 시작할 준비를 마쳤습니다. 저희는 Reaper라는 DAW를 사용하여 믹싱 작업을 했습니다. Reaper는 유연성이 굉장히 높을 뿐만 아니라 무엇보다도 dearVR 제품의 통합을 제공한다는 점에서 가장 적합했습니다. 3D 오디오 믹싱 작업은 여러 방면에서 중요한 단계를 걸쳐야 하는 입체적인 작업입니다. 먼저 어떤 사운드가 공간화될 것이며 어떤 사운드가 '머리에 고정된' 방향으로 감쇠되지 않은 채로 유지될 것인지를 정해야 하죠. 저희의 경우 '머리에 고정된' 방향이 두 가지 상황에서 특히 유용할 것 같았습니다. 첫 번째로 LFE 채널과 모노로 유지되는 채널처럼 저대역 정보를 전송하는 버스와, 두 번째로 시청자의 머리 회전에 상관 없이 패닝 오토메이션을 유지하는 잔향과 지연 같은 기존의 스테레오 보조 효과를 위한 버스의 역할로 사용하는 것이었죠. 지연과 잔향이 공간화될 경우 한 뱡향으로 보라고 '지시하는 듯한' 느낌을 줘서 시청자를 둘러싸는 이러한 효과가 의도치않게 잘못 지각되도록 할 수 있습니다.

dearVR의 플러그인과 Spatial Connect 소프트웨어를 사용하면 믹서가 헤드폰을 통해 바이노럴을 모니터링한 다음 헤드셋을 통해 헤드 트래킹과 동영상 피드를 실행할 수 있습니다. 그런 다음 동영상에서 해당 동작이 일어나는 곳에 대해 3D 공간 안에서 음원을 배치하기 시작할 수 있죠. 스테레오 악기 버스를 조합해보며 실험해봤는데, 이러한 버스는 피아노나 스테레오 신시사이저처럼 직접 입력 음원과 같이 스테레오로 녹음된 정보에 강하게 의존하는 악기에만 효과적이이었습니다. 스팟 마이크가 많은 드럼 같은 악기의 경우 스테레오 버스를 사용하고 동영상에서부터 악기의 각 부분이 배치된 모노 음원을 사용했습니다. 아까 제가 3D 중첩 잔향에 임펄스 반응이 필요하다는 것을 말씀드린 것 기억하시나요? 중첩 잔향 없이 직접 신호를 들으면 무향실에서 소리를 출력하는 스피커에 둘러싸여있는 것처럼 들립니다. 스팟 마이크는 필요한 직접 사운드를 추가해주지만 음향적 공간의 정확한 반사음을 제공하지 못할 뿐만 아니라 코러스와 거친 느낌을 줬던 녹음 정보를 사용하죠. 3D 중첩 잔향을 풍선으로부터 얻은 임펄스 반응과 함께 활용하면 녹음했던 공간과 비슷하게 모델링된 잔향을 인공적으로 만들어낼 수 있습니다. 이 잔향은 반사음의 부재를 없애 부자연스러움을 없애고 사이를 메꿔주는 역할에만 충실하도록 고안되었습니다. 모든 위치에 있는 각 악기는 프론트 엔드에서 패러메트릭 EQ가 있으며 잔향의 주파수 반응을 알맞게 조정할 수 있도록 해주는 3D 중첩 잔향 버스가 자체적으로 있습니다.

최종적으로 생성된 오디오 파일은 16채널 앰비소닉 파일 하나(3차순)와 머리로 고정된 스테레오 파일 하나였습니다. 3차 앰비소닉 파일은 구형 배음을 더 제공해서 오디오 필터링이 거의 느껴지지 않고 디코딩되었을 때 음원 간 각도 해상도가 높습니다. 하지만 사용되는 채널의 개수가 더 많기 때문에 이에 맞는 미들웨어 솔루션이 필요했죠. Wwise는 이를 지원할 뿐만 아니라 Auro3D 라이선스가 있어서 바이노럴로 디코딩할 수 있기 때문에 당연한 선택이었습니다.

Wwise를 사용하게 되면 몇 가지 단계가 추가되긴 하지만 저희가 원하는 음질을 얻기 위한 가장 효율적인 방법이었습니다. 저희가 볼 때 1차나 2차순은 음향적 공간에서 녹음된 악기를 사용하기에는 부족했습니다. 착색이 심할 뿐만 아니라 다른 형태의 왜곡이 심해서 경험에 방해가 되더군요. 저희가 사용한 대부분의 기술은 프로젝트의 필요에 의한 것이었지만, 머리로 고정된 스테레오를 '베드(bed)', 즉 기본음으로 사용하는 것과 같이 비슷한 기술을 적용하면 큰 도움이 될 때가 있습니다. 저는 현재 동영상과 관계가 없는 3D 음악을 믹싱할 때에도 이러한 기술을 사용하고 있죠.

이 앱은 애플의 앱스토어에서 제공되며 이 링크를 통해 확인할 수 있습니다. 여러분의 작업에 대해 궁금한 내용이 있다면 웹사이트를 통해 저희에게 연락해주세요.

댓글