이 시리즈에서는 과거, 현재, 그리고 새로운 잔향 기술을 집중적으로 살펴보고 몰입적 공간적 관점에서 이 기술을 검토해봅니다. 이전 글에서는 가상 현실에서 몰입적인 잔향을 제작하는 것이 왜 어려운지를 살펴보고 기존의 잔향 알고리즘 몇 가지를 알아보았습니다. 이 글에서는 공간적 잔향 효과를 생성하는 데에 사용할 수 있는 음향 시뮬레이션의 현재 경향 몇 가지를 살펴봅시다.

철판에서의 소리 전달 음향 시뮬레이션

이전 글에서 본 것처럼 기존의 고전적 잔향 기술이 오늘날에도 여전히 관련성이 크지만, 잔향을 더욱 몰입적으로 만들기 위한 방법을 찾아보기 시작해야 합니다. 새로운 제작 필요에 따라 잔향 기술이 발전해 왔듯이, 가상 현실은 지금 잔향적인 가상 공간을 듣는 방식의 한계를 넘어가고자 하고 있죠.

이제 우리는 바이노럴 알고리즘 덕분에 헤드폰에서 들려오는 소리의 방향을 어느 때보다 더욱 잘 인식할 수 있게 되었습니다. 바이노럴 알고리즘도 근접 효과를 개선하고 개인화된 머리 전달 함수(Head Related Transfer Function, HRTF) 필터를 제공하도록 앞으로도 계속해서 개선되겠지만, 마찬가지로 잔향도 초기 직접 사운드 후에 이러한 공간적인 신호를 잘 전달할 수 있도록 해주어야 합니다. 기존의 고전적 잔향 알고리즘은 처리 과정 중에서 시간에 따른 반향의 밀도를 효율적으로 증가시킬 수 있게 해주지만, 공간적인 신호를 전달하는 데에 중요한 상호작용성을 잃어버리게 됩니다. 특히 중요한 인지적 정보를 전달하는 초기 반사음의 경우 더욱 그러하죠. 이 목표를 성취하기 위해서는 가상 공간에서의 지오메트리 정보를 사용하기 시작하여 시뮬레이션 알고리즘에게 정보를 전달해 주어야 합니다.

헤드폰을 사용하면 리스너가 항상 스피커의 중앙에 있기 때문에 공간적 음향 효과를 더욱 쉽게 렌더링할 수 있습니다 [1]

이렇게 기존의 잔향 효과를 넘어서서 가상 소리풍경을 청각화할 수 있는 다양한 방법을 살펴봅시다. 가상 소리풍경을 청각화한다는 것은 다시 말해 잔향적 가상 공간을 듣는 것이죠. 가상 음향의 가청화는 물리학과 그래픽의 개념을 차용하여 소리 전달을 시뮬레이션하는 것을 목표로 하는 연구 분야입니다. 실제로 공간적 정보를 전달할 수 있는 더욱 현실적인 시뮬레이션을 얻으려면, 밀폐된 공간에서 소리가 어떻게 전달되며 이를 어떻게 시뮬레이션할 수 있는지를 살펴봐야 합니다.

![Spatial sound is also needed for multi-channel setups, such as the SATosphere in Montreal which has 157 speakers [2]. Spatial sound is also needed for multi-channel setups, such as the SATosphere in Montreal which has 157 speakers [2].](http://info.audiokinetic.com/hubfs/Blog_Images/Benoit%20blog%202/Picture2.png)

또한 몬트리올에 있는 SATosphere와 같은 157개의 스피커를 가진 다채널 구성에도 공간적인 사운드가 필요하죠 [2]

소리 전달은 놀라울 정도로 복잡한 현상입니다. 시뮬레이션의 정확도를 증가시키려면 그만큼 계산의 양도 증가되어야 하죠. 그렇기 때문에 이러한 방법이 어떤 면에서 뛰어나고, 어떤 면에서 부족하며, 각 접근 방식에서 어떤 인지적 결과를 얻어낼 수 있는지를 고려하는 것이 중요합니다.

소리의 전달

우리가 소리라고 인지하는 빠른 진동으로 인해 방출되는 에너지는, 다른 물질을 통해 기계적인 파동으로서 이동합니다. 원래의 진동 변위(예: 성대)에서 비롯되는 이 운동 에너지는 공기와 같은 주변 매체의 다른 입자로 전달됩니다. 소리 자체는 사실 거의 움직이지 않기 때문에 입자에서 입자로 운동 에너지가 거의 전달되지 않으며, 에너지를 전달하는 물질의 점도에 따라 점차 소멸됩니다.

물질의 밀도가 더욱 높을수록 입자가 서로 가깝기 때문에 전달이 더욱 빠르게 이루어지며, 입자가 더욱 무거울수록 입자를 움직이는 데에 필요한 에너지가 더 많기 때문에 에너지 소비량이 더 커집니다. 음향 임피던스(acoustic impedence)라고 하는 또 다른 속성은 특정 물질로 서로 다른 주파수가 얼마나 잘 전달되는지 설명해 줍니다. 공기에서 벽 물질로 전달되지 않는 에너지는 다시 반사되며 공간의 잔향에 기여하게 됩니다. 바로 이러한 이유로 섬유 물질과 같이 밀도가 낮은 물질이 녹음 스튜디오에서 잔향을 감소시키는 데에 어느 정도 도움을 줄 수 있죠. 표면의 외부 텍스처도 반사음의 방향을 안내해 줍니다. 이러한 모든 현상은 소리의 파장에 따라 달라지기 때문에 주파수에 따라 변동적입니다. 파장이 길수록 저주파음으로 인지되며 파장이 짧을수록 고주파수로 인지됩니다.

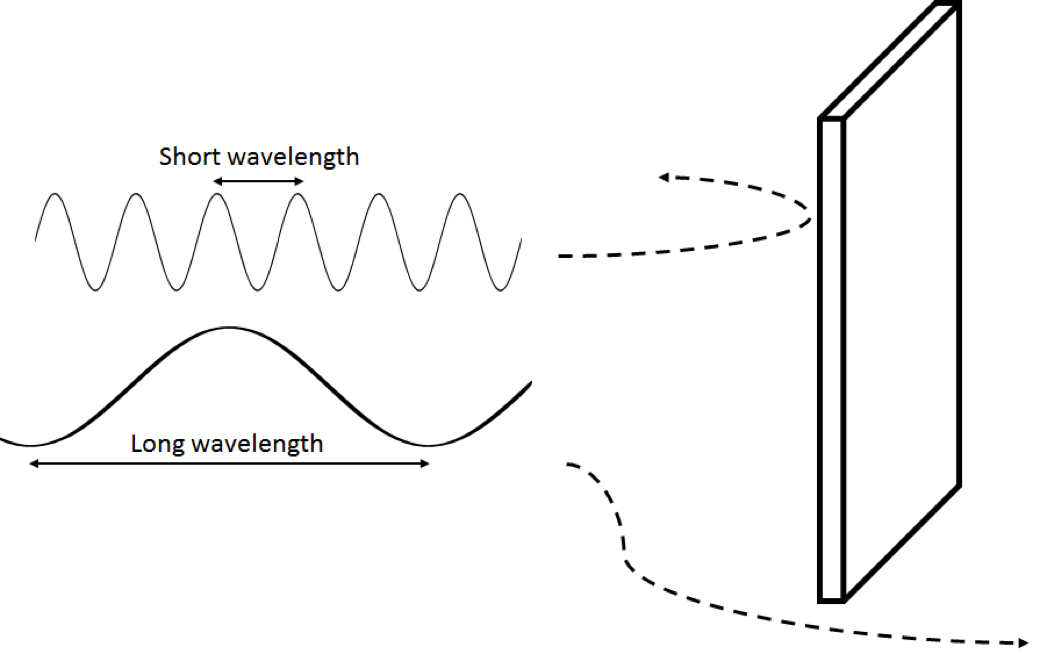

주파수에 따른 소리의 본질을 설명할 수 있는 가장 쉬운 방법은 소리 전달의 또 다른 주요 구성 요소인 회절을 고려해 보는 것입니다. 게임 오디오에서는 방해라고도 알려진 회절을 통해 음파는 장애물과 열린 공간 주변에서 구부러져서 방사음에 대한 직접적인 가시선 없이 리스너에게 도달할 수 있습니다. 이러한 방해를 시뮬레이션하기 위해 저대역 통과 필터가 사용되는 이유는 현실에서 회절이 작동하는 방식 때문입니다. 장애물보다 작은 파장이 장애물과 맞닥뜨리게 되면 사운드가 반사됩니다. 하지만 파장이 장애물보다 더 길 경우 이를 피해서 가게 되죠. 그렇기 때문에 한 신호로 조합된 두 개의 주파수가 동일한 장애물을 향해 이동한다면, 이 벽 뒤에 있는 리스너는 저주파수(더 긴 파장)만 듣게 됩니다. 이 효과는 모양이 더 복잡해질수록 더욱 까다로워집니다. 예를 들어 머리 주변의 소리 회절은 아주 복잡해서 인이어 마이크와 임펄스 사운드를 사용해서 이를 녹음해야 합니다. 바로 이 방식으로 HRTF 필터를 캡처하여 바이노럴 효과를 만들어내죠. 그렇기 때문에 크기, 모양, 밀도, 음향 임피던스, 텍스처 모두 서로 다른 주파수에서 공간을 통해 소리가 전달되는 방식에 영향을 주는 물질적 속성이 됩니다.

짧은 파장은 장애물로부터 반사될 가능성이 높으며 긴 파장은 회절하게 됩니다.

반대로 빛은 완전히 다른 과정으로 전달되죠. 전자기파의 일종인 빛은 진공을 통해 이동할 수 있습니다. 사실 빛이 전달되기 위해서는 진공이 필요하죠. 다시 말해 빛은 물질의 입자 사이를 통과해 지나갑니다. 그렇기 때문에 물질의 밀도가 더 높을수록 전달이 느려지며 심지어 차단되기도 하죠. 게다가 우리가 볼 수 있는 빛의 파장은 우리가 들을 수 있는 소리의 파장보다 훨씬 작습니다. 우리 눈은 400~700 나노미터 길이의 빛의 파동을 감지할 수 있지만, 소리가 우리 귀에 들리기 위해서는 음파가 17 밀리미터에서 17미터가 되어야 합니다. 게다가 소리는 공기 중에서 초당 343미터로 훨씬 더 느리게 이동하지만, 빛은 초당 거의 3억 미터로 이동할 수 있죠. 바로 이러한 이유 때문에 우리는 잔향적인 소리의 지연에 대해 매우 우려해야 할 필요가 있습니다. 이러한 모든 차이점은 특히 회절 방면에서 빛의 파동과 소리 파동(음파)가 여러 가지 물질과 장애물에서 서로 다르게 상호작용하는 이유를 설명해 줍니다. 하지만 회절은 밀폐된 공간에서 많이 두드러지지 않기 때문에, 빛의 전달이 소리 파동 예측을 시작하기에 굉장히 좋은 곳입니다.

레이 기반 방법

레이 기반 음향은 빛이 이동하는 신호를 사용하여 소리 전달을 시뮬레이션하는 기술입니다. 이 방법에서는 소리가 직선으로 이동하며, 약간의 선형 대수를 통해 다양한 벽의 위치에 따라 소리 반사의 방향을 쉽게 계산할 수 있습니다. 이러한 모델에 지연을 추가하여 소리가 느리게 이동하는 본성을 고려하고, 필터를 추가하여 벽이 서로 다른 주파수를 어떻게 흡수하는지를 시뮬레이션할 수 있습니다. 일반적으로 단순화된 지오메트리를 사용하여 실행되는 레이 기반 방법은 보다 높은 주파수에서 초기 반사음의 소리 전달을 빠르고 정확하게 시뮬레이션할 수 있는 방법을 제공합니다. 현실에서는 보통 공간이 더 복잡하기 때문에 더욱 많은 표면에서 반사되어 반향의 밀도가 더욱 풍부해집니다. 그렇기 때문에 이러한 기술로는 후기 반사음을 잘 재현해낼 수 없는 것이죠. 또한 공간 지오메트리가 더욱 복잡해지면 저주파수 파동의 회절이 훨씬 더 두드러집니다. 이 경우 들어오는 회절 반사 레이의 방향을 알고 있다면 이를 독립적으로 시뮬레이션할 수 있습니다.

레이 기반 방법의 두 가지 주요 변형법은 허음원 방법과 레이 트레이싱 방법입니다. 허음원은 각 벽으로부터 소리의 반사 경로를 계산합니다. 반사 자체가 또 다른 벽으로 반사되면서 이 과정은 계속해서 높은 차순의 반사를 포함할 수 있죠. 레이 트레이싱의 경우 다양한 방향으로 레이가 전송되며 장애물에 도달하였을 때 반사됩니다. 서로 다른 방향으로 가는 여러 개의 새로운 레이가 표면으로부터 각 반사를 따라 생성되죠. 랜덤 방향을 선택하면 예를 들어 사운드가 벽의 텍스처나 모서리에 의해 흩어지는 것을 시뮬레이션할 수 있습니다 [4]. 이 방법은 더 복잡한 지오메트리가 사용될 경우 유용하지만 계산 비용이 더 듭니다. 두 방법 모두 알고리즘의 깊이를 제한하여 초기 반사음에 더욱 집중하도록 할 수 있습니다. 각 레이의 정확한 방향을 알기 때문에 레이 기반 방법을 사용하면 음원과 리스너의 방향에 따라 공간과 시간 안에서 소리를 상호작용적으로 배치할 수 있습니다. 소리가 이동한 거리를 시뮬레이션하기 위해서 공기 중 소리의 속도에 따라 지연이 생깁니다.

다음은 에딘버그 대학교의 음향 및 오디오 그룹의 구성원인 브라이언 해밀턴(Brian Hamilton)님이 제공하신 동영상입니다 [4]. 레이 기반 방법을 사용한 시간에 따른 음원의 전달을 볼 수 있습니다.

레이 기반 소리 전달 시뮬레이션

|

|

|

|

|

파동 기반 모델링

앞서 보았듯이 소리는 빛의 파동과는 다르게 이동합니다. 그렇기 때문에 음파 전달을 더욱 정확하게 시뮬레이션하기 위한 또 다른 방법들이 있습니다. 예를 들어 유한 시간 차분법(Finite Difference Time Method, FDTD)이라는 수치적인 방법을 사용하면, 사운드 에너지가 한 입자에서 다른 입자로 전달되는 방식에 더욱 가까운 방식으로 시뮬레이션할 수 있습니다. 실제 입자 대신 3차원의 공간을 고정된 크기의 격자선으로 분할하죠.

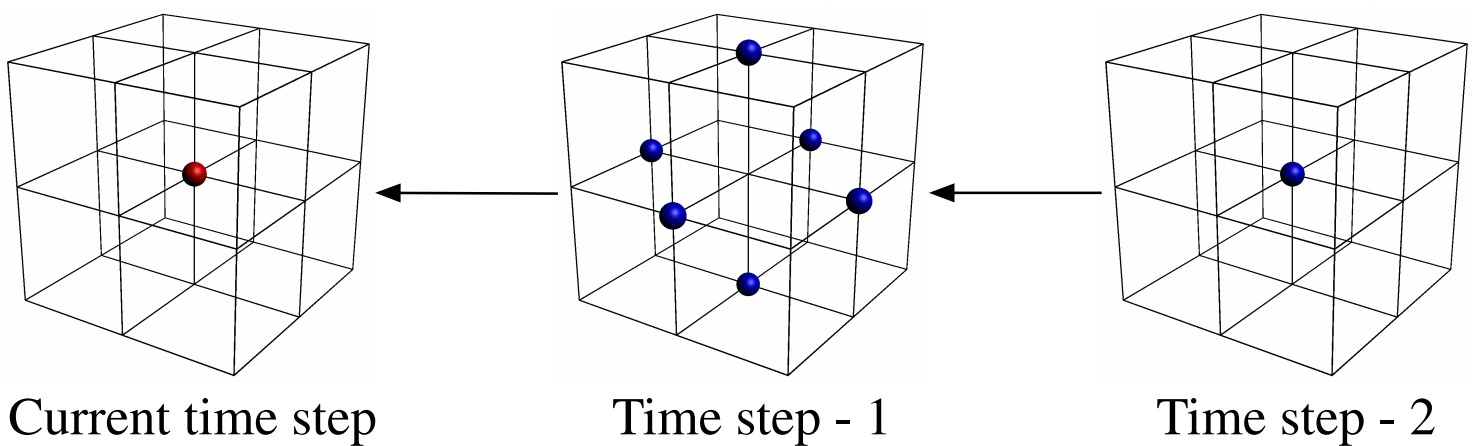

이 방법의 핵심 개념은 특정 시점에서의 음압이 장래에 주변 지점에 영향을 준다는 것입니다. 이 단순한 원리와 함께 전달 물질에 대한 일부 정보와 수많은 계산을 기반으로, 이전 시간으로부터 주변 지점에서의 값을 사용하여 모든 지점에서의 음압 값을 계산할 수 있습니다. 다시 말해 소리의 이전 위치를 알 경우 어디에 있게 될지를 예측할 수 있다는 것이죠. 이는 또한 격자선에서 모든 지점의 값이 매 프레임에서 다시 계산되어야 한다는 것을 의미합니다. 완전히 가청적인 대역폭의 경우 초당 44,100 프레임이 되죠. 격자선의 간격은 원하는 샘플 레이트에 따라 선택됩니다. 고주파수를 시뮬레이션하려면 짧은 파동의 작동 방식을 정확하게 시뮬레이션하기 위해 보다 작은 격자선 크기가 필요합니다.

FDTD 방법을 사용하여 단일 지점의 음압을 계산하는 데에 사용되는 시간과 공간에서의 인접 지점 [5]

FDTD에서는 필요한 시간 프레임에 따라 특정 지점에서 단순히 신호를 모델링 안으로 설정해서 음원을 재생할 수 있습니다. 이 신호의 시간에 따른 진폭은 매 프레임에서 음압으로 변환됩니다. 마찬가지로 특정 지점에서 계산된 시간에 따른 음압을 읽음으로써 리스너를 배치하여 오디오 신호를 형성합니다. FDTD에서는 리스너의 위치에 상관없이 소리 변형이 각 지점에서 동시다발적으로 시뮬레이션됩니다.

공간의 크기와 필요한 최소 파장에 따라, 결과적인 계산은 몇 분에서 몇 시간까지 걸릴 수 있습니다. 그렇다면 이 방법을 어떻게 실시간으로 사용할 수 있을까요? 이 시뮬레이션은 임펄스를 음원으로 사용하여 임펄스 반응(IR)을 생성해서 오프라인으로 실행될 수 있습니다 (이전 글에서 중첩 잔향 참고). 이 과정은 나중에 중첩을 통해 실시간으로 사용될 수 있는 일련의 IR을 만들어냅니다. 공간 음향 목적을 위해 높은 차순의 앰비소닉 IR을 생성할 수 있지만, 미리 녹음된 공간 임펄스 반응과 마찬가지로 다양한 이미터-리스너 위치를 표현하는 데에 필요한 저장 공간이 엄청날 수 있습니다.

보다 높은 주파수에서 정확한 결과를 얻기 위해서는 작은 격자선 간격이 필요하기 때문에(모든 가청 주파수를 시뮬레이션하려면 크기가 몇 밀리미터여야 함), 격자선 크기를 낮추면 계산 비용을 절약할 수 있습니다. 그렇기 때문에 이 방법은 보다 낮은 주파수의 소리 전달 시뮬레이션에 더욱 적합합니다. 샘플 레이트를 낮추면 계산 비용과 저장 공간을 절약할 수 있습니다. 고주파수는 어차피 보통 멀리 이동하지 않기 때문에, 공기와 벽의 흡수가 중요한 역할을 합니다.

또한 파동 기반 시뮬레이션도 복잡한 지오메트리의 모양에 따라 레이 기반 방법이 잘 해낼 수 없는 주파수에 따른 소리 회절을 잘 시뮬레이션해 줍니다. 일반적으로 말해 파동 기반 방법에서는 반향의 밀도가 더욱 정확하게 시뮬레이션되기 때문에 후기 잔향을 생성하는 데에 더욱 적합합니다. 하지만 현실에서 모든 공간이 바람직한 잔향을 가지는 것은 아니듯이, 일부 시뮬레이션은 미디어 제작 관점에서 좋은 음향이 아닐 수 있습니다. 필요한 렌더링 시간은 긴 시간을 요구하므로 조정 과정을 더 복잡하게 만들 수 있습니다.

FDTD 방법은 거의 이름 그대로의 방식으로 파동 전달을 시뮬레이션하지만, 일부 물리학의 근사치로 더욱 빠르게 시뮬레이션할 수 있는 다른 파동 기반 방법들이 있습니다. 그렇기 때문에 실제 장점과 제한은 방법마다 다를 수 있습니다.

직접 IR 중첩 외에, 생성된 데이터도 다른 방법으로 사용할 수 있습니다. 예를 들어 500Hz 이하의 저주파수 소리 전달 시뮬레이션을 렌더링하고 결과적 데이터를 사용하여 시간에 따른 잔향의 진폭 쇠퇴를 분석할 수 있습니다. 그런 다음 이 정보를 활용하여 기존의 전통적 잔향 알고리즘 매개 변수에 정보를 전달할 수 있습니다 [6]. 이 방법은 잔향의 매개 변수화를 오토메이션(자동화) 할 수 있는 좋은 방법인데, 이 방법은 수많은 공간이 있는 대규모 가상 세계에서 유용합니다. 이 방법은 최근 Microsoft에서 기어스 오브 워 4(Gears of War 4)를 위해 Wwise 플러그인 안으로 구현되었습니다. 이 프로젝트에 관한 발표는 곧 개최되는 GDC 컨퍼런스에서 제공됩니다 [7].

마찬가지로 브라이언 해밀턴님이 제공해 주신 다음 동영상은 [4] 파형 기반 방법이 소리 전달을 렌더링할 수 있는 방법을 설명해 줍니다. 내부 모서리가 몇 개의 새로운 파동 전선을 생성하는 것을 보세요.

파형 기반 소리 전달 모델링

|

|

|

|

|

다음은 레이 기반과 파동 기반 음향 시뮬레이션의 차이점을 설명해 주는 두 가지 시뮬레이션입니다 [4].

레이 기반 음향 모델링

파동 기반 음향 모델링

그렇다면 어떤 방법이 가장 최고일까요? 정답은 둘 다입니다! 파동 기반 방법은 복잡한 시뮬레이션에서 더욱 적합하지만, 레이 기반 방법도 알맞게 사용하면 아주 훌륭한 사운드를 제공할 수 있습니다. 소리 전달에 관한 물리학이 꽤나 복잡할 수 있지만, 처리 과정을 아주 간소화하더라도 여전히 훌륭한 사운드를 얻을 수 있습니다. 그렇기 때문에 전체 시뮬레이션을 위한 추가 계산이 인지적 관점에서 큰 가치가 있는지를 확인해야 합니다. 흥미롭게도 레이 기반과 파동 기반 방법은 서로의 장점으로 완벽하게 만들어줍니다. 레이 기반 방법은 고주파수와 초기 반사음을 시뮬레이션하는 데에 훌륭한 반면 파동 기반 모델링은 저주파수, 후기 잔향, 복잡한 지오메트리에서의 회절 효과를 실행하는 데에 더욱 적합하죠.

다음 글에서는 기존의 전통적인 잔향 기법, 레이 기반, 파동 기반 방법을 함께 조합하여 상호작용 공간 효과에 적합한 유연성과 효율성을 가진 다양한 새로운 하이브리드 잔향기를 형성하는 방법을 소개해드리겠습니다.

가상 음향에 대한 더 많은 정보를 얻으시려면, 위에서 설명해드린 기술을 상호작용적인 애니메이션을 통해 설명해 주는 다음의 훌륭한 상호작용적 서적을 추천해드립니다 [8].

상호작용적 서적 [8]

또한 에딘버그 대학교(University of Edinburgh)의 음향 및 오디오 그룹(Acoustics and Audio group)은 파동 기반 시뮬레이션에 관한 값진 정보와, 공간뿐만 아닌 악기를 모델링하는 법에 관한 정보가 담긴 흥미로운 웹사이트를 운영하고 있습니다 [9].

Footnotes:

[1] http://sat.qc.ca/en/albums/symposium-ix-2016#lg=1&slide=14

[2] http://sat.qc.ca/en/albums/symposium-ix-2016#lg=1&slide=17

[3] http://interactiveacoustics.info/html/GA_RT.html

[4] http://www.acoustics.ed.ac.uk/group-members/brian-hamilton/

[5] C. Webb, "Computing virtual acoustics using the 3D finite difference time domain method and Kepler architecture GPUs", In Proceedings of the Stockholm Music Acoustics Conference, pages 648-653, Stockholm, Sweden, July 2013.

[6] Nikunj Raghuvanshi and John Snyder. 2014. Parametric wave field coding for precomputed sound propagation. ACM Trans. Graph. 33, 4, Article 38 (July 2014), 11 pages. http://dx.doi.org/10.1145/2601097.2601184

[7] http://schedule.gdconf.com/session/gears-of-war-4-project-triton-pre-computed-environmental-wave-acoustics

[8] http://interactiveacoustics.info/

[9] http://www.ness.music.ed.ac.uk/

댓글