私がビデオゲーム向けに作曲するときに常に心がけるのが、プレイヤーにとって心に響く音楽をつくることです。コンポーザーとして、そのプロジェクトのストーリーや感動、テーマやカラーなどのクリエイティブな要素について、クリエイティブディレクターやオーディオディレクターと共に検討していきます。また、音楽とプレイヤー動作の関係性について、よく質問をします。

私はクラシック音楽の作曲を学び、エレクトロニックミュージックが大好きなコンポーザーです。ライブミュージシャンの演奏やデジタル処理技術を、ユニークな方法でブレンドするのが好きで、私の過去作品のサントラRemember Meは「音楽の画期的なアプローチ」と評価され、数々の賞をいただきました。そのような中で私が作曲構成そのものと同じくらい重視していることの1つが、インタラクティブなアプローチです。

単純に言うと、この作品ではロンドンで70人編成オーケストラレコーディングを行いましたが、ミュージシャンに「次のビートでプレイヤーアクションに合うよう140bpmで演奏してほしい」とお願いしたのです。コンポーザーやオーディオディレクター、またはゲームミュージックの経験がある方は分かると思いますが、これは簡単なことではありません。見事な結果に仕上がりましたが、こんな複雑なことは二度とやるものか、と心に誓ったところ、Get Evenに出会ったのです。

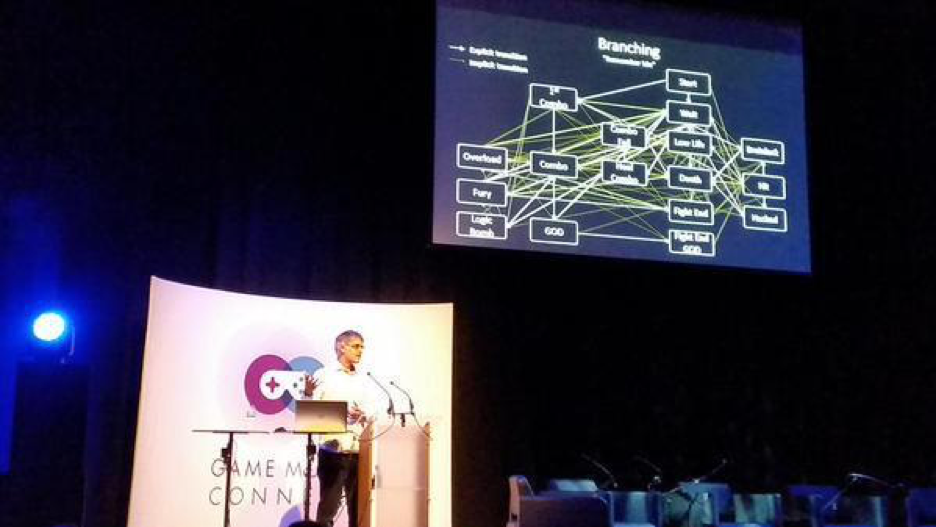

ロンドンのGame Music Connectで、Remember Meのインタラクティブミュージックのブランチを説明する、AudiokineticのProductsバイスプレジデントのサイモン・アシュビー(Simon Ashby)

Get Even

Get Evenの開発はポーランドのデベロッパThe Farm 51、パブリッシャーはBandai Namcoです。最初にゲームのコンセプトを説明されたときは、とても驚きました。VRでは無いVRゲームをつくろうとしていたのです。依頼されたのは、シューター系でありながら、ウォーキングシミュレーターであり、探偵物でもあり、ストーリー性のあるゲームでした。そして、終わる時にはプレイヤーが泣くようなゲームを求められていました。非常に魅惑的な要件だったので、達成させようと一心に取り組んだのです。

Get Even : インタラクティブミュージックのリアルタイム生成の紹介

インタラクティブミュージックとは?

これまで、インタラクティブミュージック推進のために世界中のコンポーザー、デベロッパー、そしてパブリッシャー達とビジョンを共有しながら、出会った業界のプロたちの経験をもとに、自分なりにさらに進化させてきました。様々なやり取りをする中で、プレイヤーのアクションに合わせて変化さえすれば、その音楽が「インタラクティブである」とされることが分かってきました。確かに、一定の(感動的な)音楽を作曲してプロデュースして、様々なレイヤを作成するためのステムを納品すれば充分かもしれず、それはそれで、非常に効率的ですが、果たしてこれだけで、いつまでも満足していいのでしょうか?そうは思いません。なぜなら、媒体自体が常に進化しているからです。媒体は多岐にわたって改善されていて、AI、ライティング、物理演算、シェーダーなどはその好例です。それなのに、音楽面ではあまり展開がありませんでした。まだインタラクティブミュージックは初期の段階にあり、今後10年間で利用範囲がさらに拡大するだろう、と期待しています。

ビデオゲームはリアルタイムで展開、だから音楽もリアルタイムで

私は以前からビデオゲームの虜になっていて、それは、画面上を動くピクセルが、みるみるうちにレンダリングされていくからです。この瞬間、画面が生きているのは、私が動かしているからです。音楽で言えば、一番近いのがエレクトロニックミュージックだと思います。シンセ(アナログの場合)やコンピュータ(デジタルの場合)を使って作曲すると、音がリアルタイムに、電気やCPUやDSPで生成されます。私にとって、その魅力はピクセルの動きと同じです。初期のゲームの時代から、私たちはリアルタイムに生成される音楽に慣れています。コンソールシステム内蔵のチップセットを使うと、必要に応じてアクションをビットごとにフォローできます。PlayStationがCDドライブ付きで発売されたことで、ミュージシャンによる生演奏で感動的な音楽がバックグランドで再生できるようになったものの、受動的な音楽となった代償として何かが失われた気がします。それから数年後には音楽をレイヤとして作成できるようになり、プレイヤーのアクションに従って音楽もリアルタイムに変化するようになりましたが、主にボリュームの変化による表現でした。そして今日、インタラクティブな生のレコーディングと、リアルタイムで生成される音楽の、両方が提供できるようになったといえます。私は、これをHybrid Interactive Music (HIM)と呼びます。

Jerobeam Fenderson - Reconstruct - オーディオビジュアルアルバム「Oscilloscope Music」

Hybrid Interactive Music (HIM) とは?

現在もなお音楽のデジタル化が進んでいます。ライブ演奏もシンセもサンプルライブラリも、波形としてファイルにおさめられます(MP3やWAVなど)。数年の間に、これらのファイルをコントロールするのが容易になり、複数のセクション(水平方向)やレイヤ(垂直方向)に編成して、「イントロ」「ループ」「エンドループ」などを作成しては、ゲーム向けの柔軟性と音楽性を深めてきました。今でも、水平方向や垂直方向に音楽を編成するこのアプローチがインタラクティブミュージックの主流です。もし興味があれば、Remember MeやGet Evenなど、Wwiseを使って作成されたインタラクティブミュージックを多数のゲームで聞くことができます。

数年前にMIDIがWwiseエンジンに導入されましたが、柔軟性に優れ、2種類の違った使い方ができます。まず、Wwiseで生成した音を再生する方法です。Audiokineticが提供する基本的なシンセを使って、リアルタイムで音楽を作成できます(レコーディングは一切されず、プロセッサで生成されます)。もう1つの方法も工夫されていて、WwiseをMIDIがトリガーするサンプラーとして使え、コントロールできる範囲も、ADSR、ベロシティ、キーマッピングなど多様です。これが、すごい!

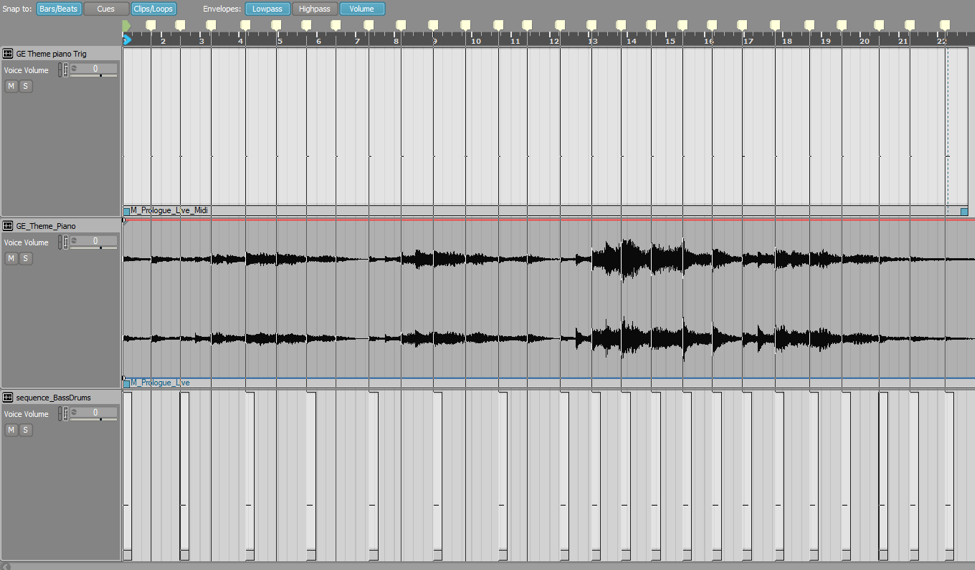

Wwiseで特に斬新なのは、レコーディング済みのファイルとMIDIの関係です。Music Editor画面で、自由にブレンドできるのです。オーケストラをレコーディングして、シンセを使った楽器を作成してMIDIでベースラインを再生させ、サンプラーとしてドラムキットを作成してMIDIでトリガーさせ、それらをオーケストラと一緒に演奏できるのです。これこそ、私がHybrid Interactive Musicと呼ぶもので、リアルタイムに生成する音楽を収録済みのミュージックセグメントと一緒に再生するのです。

Get Even - Hybrid Interactive Musicの事例として

そもそも、HIMの魅力とは?

テンポについて考えます。ご存知の通り、デジタルトラックのテンポを変えると、ピッチも変わってしまいます(エンターテイメントシステム側が、まだリアルタイムのピッチ修正機能を備えていません)。つまり、テンポを全く変えられません。しかし、クリエイティブな観点から、どうしても音楽のテンポを徐々に上げて、ある対象までの距離や、プレイヤーの健康ステータスなどをプレイヤーフィードバックとして表現したいとしたら?MIDIと、サンプラーと、RTPC機能を使えば、実に簡単に表現できます。

次は、楽器のダイナミックスについてです。例えばピアノなど、楽器を作成して、再生する音符ごとに、再生する音の大小を変えられます。ゲームのパラメータに合わせて、リアルタイムでダイナミックに変化させることができ、その変化の仕方を細かく、そしてシームレスにコントロールできるのです。

これらは、Wwiseを使ってHybrid Interactive Musicを作成する様々な可能性のほんの一例です。自分で次から次へと工夫できるので、可能性が無限大に思えてきます。

Get Even - MIDI Kick DrumのTempoの変数、パターンの変化、RTPCに依存するベロシティ

Get Evenでは、HIMだけでは足りず…

Wwiseが提供するテクニカルな可能性を説明したところで、話をGet Evenに戻します。前述のとおり、Get Evenは、VRでプレイしないVRゲームです。ゲームでは、自分のキャラクターが終始、VRデバイスを装着しているのです。そこで最初に気になったのが、VRの中で音楽はどうなるのか、ということです。この新たなエクスペリエンスで音楽の入り込む余地がないように思え、とても気がかりでした。Get Evenでは、現実世界の地に足が着いたリアルな感覚があるので、音楽がどこからともなく聞こると抽象的になってしまいます。

しばらく考えた末、音楽は必ずダイエジェティックな要素としてスタートさせて、それから抽象的にする、というルールを自分で決めました。こうすることで、音楽が現実世界の要素であり、単なるBGM的な表現ではないことをプレイヤーに印象付けます。

コンポーザーとして、私は常に、意表をつくような意味の深い「カラー」をつくりたいと思っています。私のサントラは、全て個性的な捻りをいれたサウンドとなっています。ゲームが必要とするものを、意外な音楽で表現することが大好きです。Wwiseを使うときも、同じです。予期せぬ使い方を考えて、そのゲーム独自の、意味のある作品をつくるのが好きです。ここで、Audiokineticの素晴らしさに言及すべきでしょう。ソフトに新しい機能を追加するときに、Audiokineticは、その機能独自の目的を果たすだけでなく、必ずWwiseのほかの機能と連携させます。例えば、インタラクティブミュージック機能を使う場合、その設定を自分のゲームのサウンドエミッターに接続できます。これが、非常に便利なのです!ゲームの3Dワールドに対してHIMを使ったミュージックシーケンスを再生しながら、2Dの収録済みトラックと同期させることができます。これで可能性が格段と広がり、Get Evenで意義あるアプローチをとることができました。

成果

最終的に、ゲームのシチュエーション別に、それぞれ違った音楽で対応することが決まりました。これに合わせて、私はゲーム全体でインタラクティブミュージックを17の方法で作成することになり、例えばダイエジェティック音を収録済み音楽と同期させたり、コンソールにリアルタイムでドローンを処理させたり、ドラムをMIDIでシーケンシングしたり、3Dから2Dへレイヤを移したり、音楽とビジュアルのリンクをさらに改善したりしました。このゲームに関して、The Sixth Axisは次のように評価してくれました:「オリビエ・ドリヴィエールのサントラは、間違いなく今年最高のサントラの1つで、恐怖の瞬間から、驚き、そして生々しい感情へと見事な変化を表現しています。注意して聞くと、Coleの息づかいや、床板のきしみや、ガス管の音など、環境音が音楽と絡み合って聞こえるのが分かります。巧妙に作曲されていて、サントラでよくあるように上に重ねただけではなく、ゲーム自体にベークされているような印象を受けます」 (The Sixth Axisより)

ハイブリッドインタラクティブミュージックの時代が到来?PART II - テクニカルデモ

コメント