オブジェクトベースのサウンドシステムについて

没入感あふれるオーディオエクスペリエンスを求める市場に応えるために、スピーカーコンフィギュレーションも7.1Chから更に広がりを見せ、平面的な拡張だけでなく高低差の表現も取り入れられるようになりました。このため、Dolby AtmosやDTS:Xなどのサラウンドサウンドシステムや、MPEG-H といった新たな配信規格では、空間配置されるオーディオコンテンツを適切なスピーカーコンフィギュレーションに分配するための「オーディオオブジェクト」というコンセプトが、半ば強制的に生み出されました。

チャンネルベースとオブジェクトベースの2種類のオーディオの非常に重要な違いが、チャンネルベースでは制作段階から再生に至るまで決まったチャンネル数を対象としていることで、オーディオミックスは厳密なスピーカーコンフィギュレーション用にデザインされ、それをダウンミックスすることで、より簡単なスピーカーのセットアップにも応用できます。一方オブジェクトベースのオーディオでは、オーディオオブジェクト(つまり「モノソース」+「リスナーに対する相対的な3D 座標」)を必ず維持してレンダリング機能に送り、ユーザーのセットアップに合わせて空間配置させます。つまり、オブジェクトベースのオーディオではオーディオの要素である様々な「オブジェクト」をそれぞれ独立したストリームとして扱い、スピーカーのセットアップに関わらず、3次元スペースのどこで再生されるのかを示すメタデータが、ストリーム自体に含まれます。1つ1つのオーディオオブジェクトを制作段階で疑似空間に正確に配置した上で、Adaptive rendering (適応レンダリング)というスピーカーレイアウト補完プロセスを使い、それぞれをリアルタイムで複数のスピーカーに正しく分配します。Adaptive rendering を使うと、受け取る側でミックスを調整することも可能です。

オブジェクトを意識したこのパラダイムは、VRでよく見られるバイノーラルバーチャライゼーションへの変換を得意とします。手法として、個々のオーディオオブジェクトをフィルター(HRTF)に通す実装が一般的です。オブジェクトのフリーケンシー(周波数)レスポンスは、リスナーとソースの3D位置関係で決まります。

オブジェクト維持の難点

オブジェクトベースのオーディオは空間配置の観点からレンダリング品質の最適化に着目している一方、オブジェクトを維持しようとすると重要なオーディオ制作手段が阻害されることもあり、オーディオデザインプロセスが制約されてしまいます。

例えば、いくつかのサウンドをまとめたグループのダイナミックレンジを、サウンドデザイナーがコントロールしたいとします。通常は、それらのインプットをまとめたバスにコンプレッサをかける、つまりサブミックスを作り出すことで、コントロールできます。以下は、サブミックスを活用するその他の理由です:

- パフォーマンス

- サイドチェイン

- マスタリング

- メーターやラウンドネスメーターの利用

- グループ分け

I

Wwiseでは、これらを行うためにMaster-Mixer Hierarchyにあるオブジェクトを使います。バスは、必要に応じてミキシングバスとなるのです。

さて、2つの3Dソースをミキシングバスにルーティングすると、バスのアウトプットとして出されるオーディオデータは複数のソース(オブジェクト)を重ね合わせたものなので、方向性を示していたそれぞれの要素は失われてしまいます。

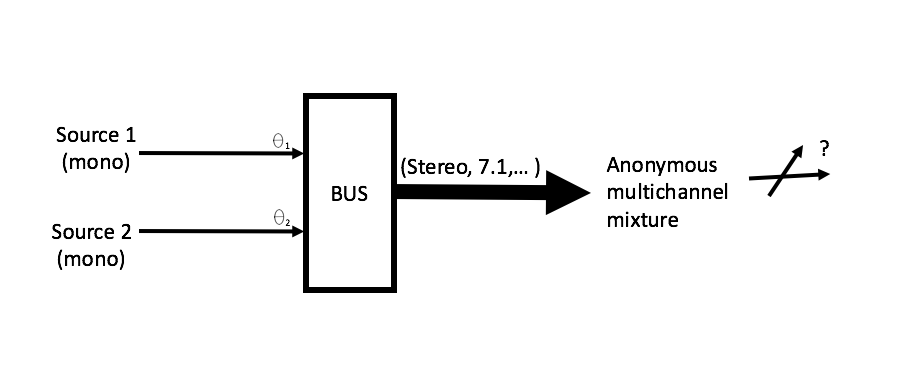

図1 – 入射角の異なる2つのソースをパンニングして、マルチチャンネルバスでミキシングします。パンニングという動作は、インプット(上図では、入射角が Ɵi)の空間的表現を、アウトプットに変換することを意味します(例えば、信号を7.1Chのスピーカーセットアップの2Ch以上に配分すること)。アウトプットはパンニングした複数のオブジェクトが混在して、アウトプットの入射角は特定できません(前述した意味でのオブジェクトではなくなります)。

このように、オブジェクトベースのオーディオでは、ミキシングの上流でしかオブジェクトが存在しないため、サブミックスとの互換性がなく、サウンドデザイナーがサブミックスに対して習慣的に活用している制作手法が阻害されてしまいます。

ケーススタディ

Wwise のミキサーブラグインのインターフェースはオブジェクトベースのプラグインアーキテクチャですが、これはミキサープラグインがバイノーラルオーディオを作り出すために、個々のサウンドソース、つまりオブジェクトを通して、各インプットの3Dポジションをアクセスする必要があるためです。一見このフレームワークはバイノーラルのバーチャライザー実装に最適のようですが、実際に使う際は以下の通り、オブジェクトベースオーディオ特有の制約によって、デザインプロセスがやや制限されてしまいます:

- バイノーラルシグナルにEffectを追加すると、バイノーラル処理で達成したいオーディオの空間的なイメージを崩してしまうことがあるので、Effect(少なくともコンプレッサのような非線形Effect)は追加しないでください。

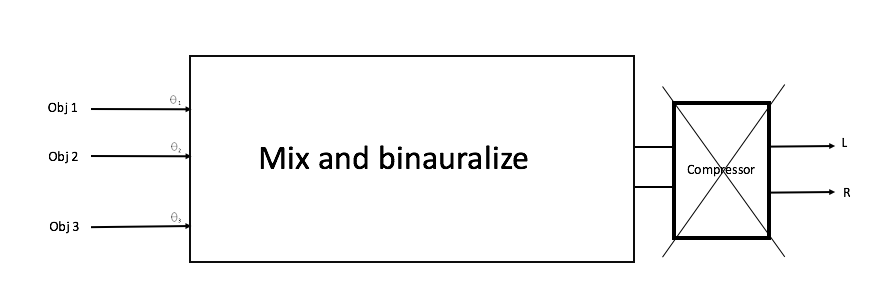

図2 – ミキサープラグインのアウトプット側で、バイノーラル信号の後に誤ってコンプレッサEffectを追加した場合。

- ミキサープラグインの前でミキシングバスを使うと、出てくるサブミックスからバイノーラル処理に必要な3D情報が失われてしまうので、避けてください。

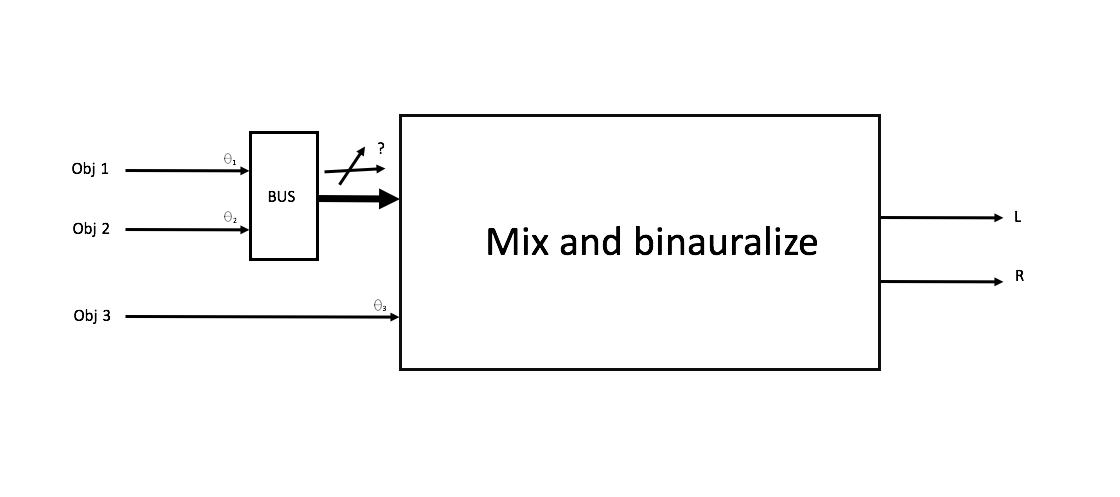

図3 – ミキサープラグインの前Sでオブジェクトをミキシングした場合。サブミックスされた信号からオブジェクトが全くなくなるので、プラグインでバイノーラル処理を行えません。

トレードオフ

この2つの世界の長所を合わせることができれば、最高です。つまり、ある程度の空間的な正確さを確保したオーディオを、オブジェクトベースのオーディオの短所なしで表現できればいいと思いませんか?この問題をアンビソニックスで克服する方法については、今後のブログをお楽しみに!

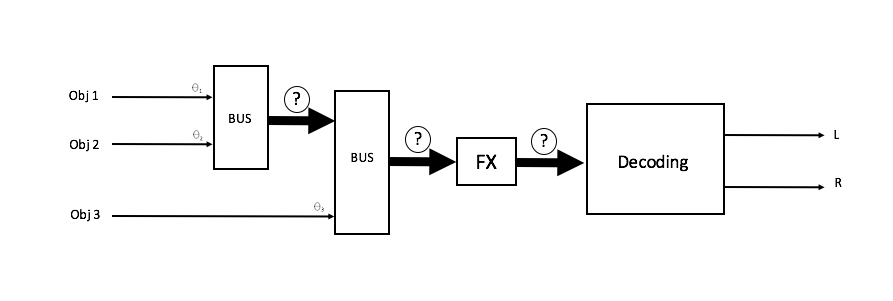

図4 – オブジェクトを自由にサブミックスしてから、マルチチャンネルの空間的オーディオ配置にパンニングするので、全ての要素のそれぞれの方向性で強弱を感じ取ることができ、Effectを追加するなどして、更に変化させることもできます。

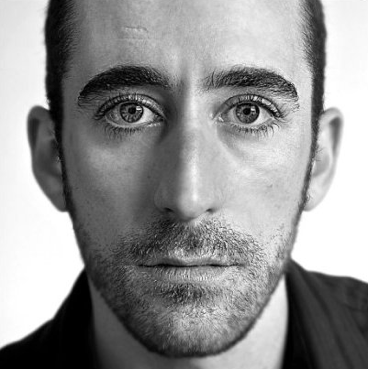

ルイス・ハビエル・ブッフォーニ (LOUIS-XAVIER BUFFONI)

Audiokinetic R&D部門ディレクター

ハビエル・ブッフォーニは、Audiokineticの空間オーディオの研究リーダーです。電気工学の修士号を有し、様々な記事や講演などで、インタラクティブミュージック、HDRを使ったダイナミックミキシング、また最近ではオブジェクトベースのパンニングやアンビソニックスについての情報を提供しています。また、AES for GamesやMIGSなどの業界イベントで、数々のプレゼンテーションを行ってきました。

コメント