アンビソニックス

Wwiseはバージョン2016.1から、バスがアンビソニックスのチャンネルフォーマットに対応しています。アンビソニックスのエンコード(アンビソニックスでない信号をアンビソニックスバスにミキシングすること)も、デコード(アンビソニックス信号を非アンビソニックスバスにミキシングすること)もサポートしています。ユーザーは環境内の複数の音をアンビソニックスバスにミキシングしてから、そのアンビソニックスバスを、Auro Headphoneのような3Dオーディオプラグインを使ってバイノーラルに変換できます。また、アンビソニックスバスにWwise Recorder Effectを利用すれば、アンビソニックスオーディオを直接エクスポートすることも可能です。

アンビソニックスの可視化

アンビソニックスでチャンネルフォーマットを使う大きな利点の1つが、スピーカーセットアップに左右されないことです。デコードプロセスを通じて各種スピーカーセットアップに合わせることができます。また、このおかげで、音場をリスナーと共に回転させるのも簡単です。一方、ユーザーインターフェースという面では、このオーディオ情報をどのように提示するかが難問です。アンビソニックスのチャンネルフォーマットでは、各チャンネルが、音場に存在する具体的な「球面調和関数」に関係します。つまり、1つのチャンネルのMeterデータから、空間中の複数ポイントにおけるサウンドレベルが決まります。そうなると、チャンネルのMeterを観察するだけでは、アンビソニックスというチャンネルコンフィギュレーションによって表現される空間的な情報を理解することはほぼ不可能です。そうではなく、エンコードしたアンビソニックス信号(チャンネル情報として表されたもの)を、まず具体的なスピーカーセットアップに合わせてデコードし、対象のセットアップを構成するスピーカーごとに、レベルを確認できるようにする必要があります。このような技法は、これまでにも実践されています(Kronlachner and Zotter, 2014、Lecomte Gauthier, 2015)。

さて、目的のスピーカーセットアップに合わせてアンビソニックス信号をデコードするときに、再構築される音場の空間的な精度は、ラウドスピーカーの配置に影響されます(Trevino et al., 2010)。具体的には、スピーカーセットアップによって、各方向がどれだけ均等にサンプルされるかによって、デコード処理の複雑性が変わります。アンビソニックスチャンネルから出てくる空間配置を伴う情報を、意味のあるかたちで見せるには、まず具体的なバーチャルスピーカーセットアップ向けにデータをデコードし、次にそのバーチャルスピーカーセットアップを使い、スペーシャリゼーション後のデータを表示する必要があります。この手法を使い、空間にあるアンビソニックスデータを3D Meter上で表示させています。

3D Meter機能

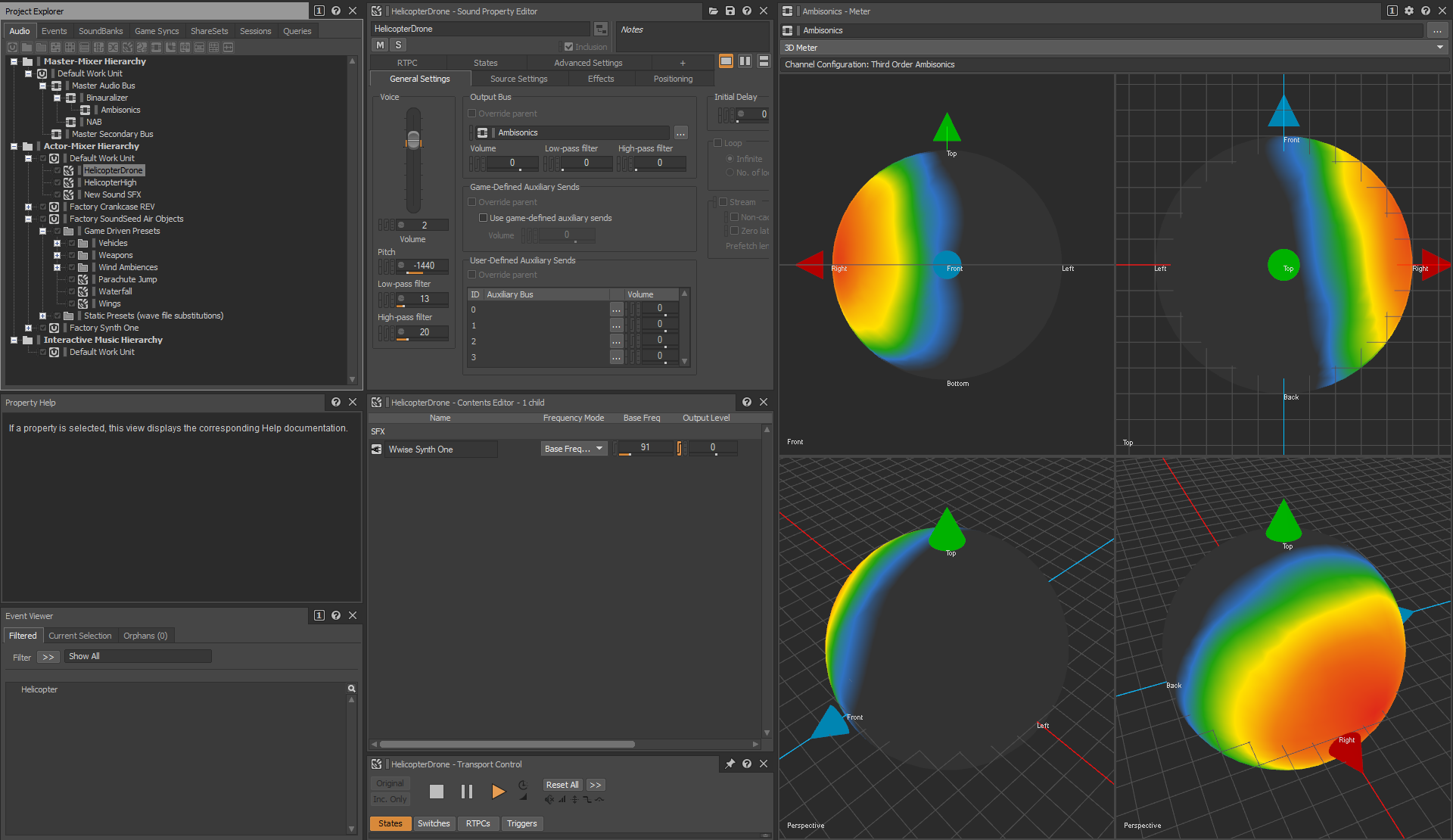

3D Meter画面は、アンビソニックスバスの中の方向性に関する情報を可視化する方法を提供してくれます。ローカルのバスの空間にある球体まわりにバーチャルスピーカーを配置し、それらに対してアンビソニックスのチャンネルデータをデコードすることによって(先ほど説明した方式)、オーディオデータが球体のヒートマップとなって提示されます。そして、バーチャルスピーカーを別々にMeterで測定し、各スピーカーのサウンドレベルをもとに、スムージングでならしたヒートマップが構築されます。各スピーカーのレベルが独自ピクセルシェーダに送られ、それをもとに球体をレンダリングします。球体の各ピクセルの色は、球体の表面まわりにあるバーチャルスピーカーへの距離や、そのポジションにおけるサウンドレベルによって決まります。ユーザーはアンビソニックスバスの中に入っている方向性の情報を3D Meterで確認し、リスナー周りにある音源の影響をどのように受けるのかも見ることができます。3D Meterは4つのパネルに分かれていて、違った角度から同時に音場を観察できます。正投影図法の6つの固定された投影の向き(平面・下面、正面・背面、左側面・右側面)があるほか、パースビューもあり、この視点は、クリック&ドラッグで音場内を回せます。どのビューポイントもマウスのホイールで拡大・縮小できます。

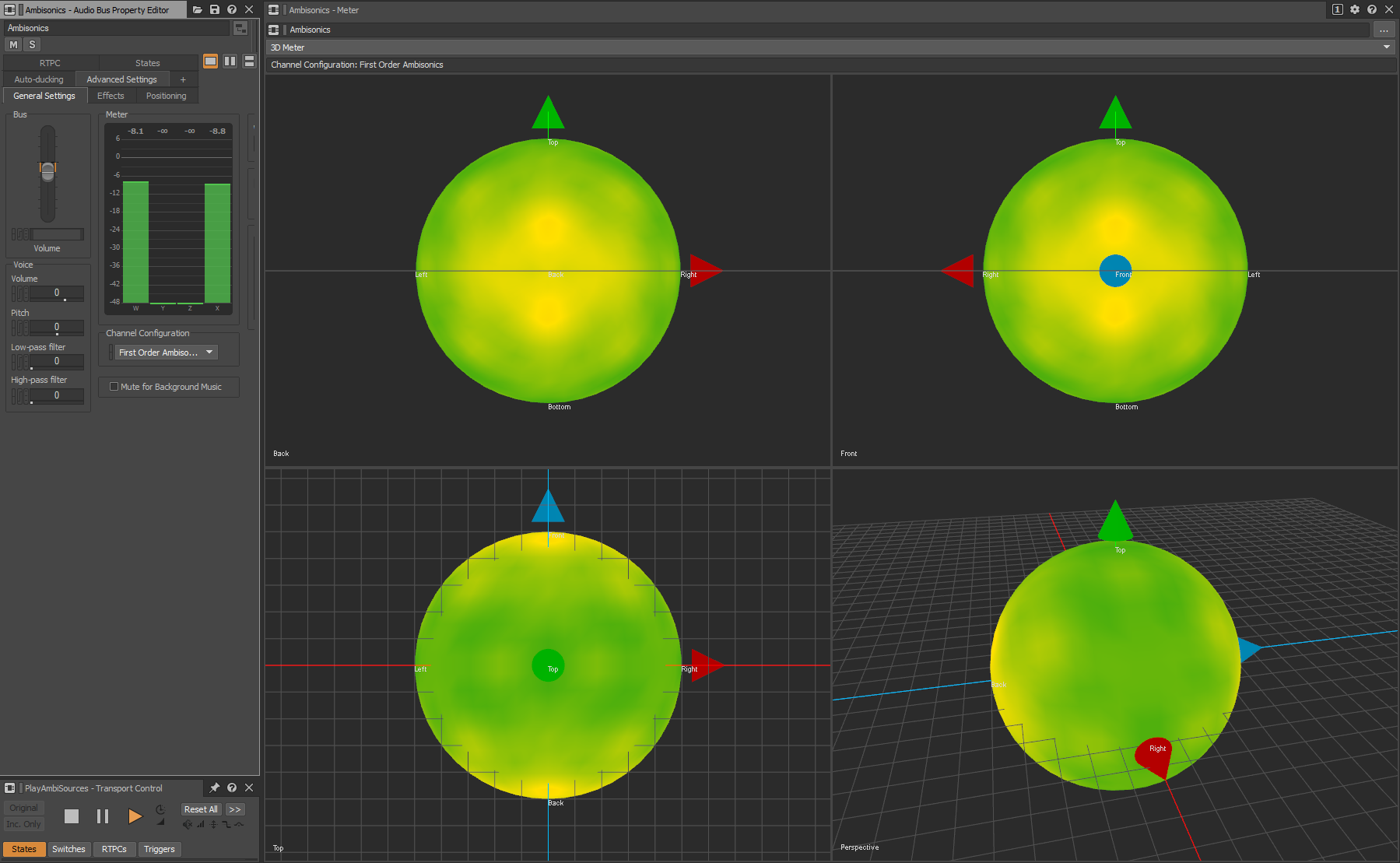

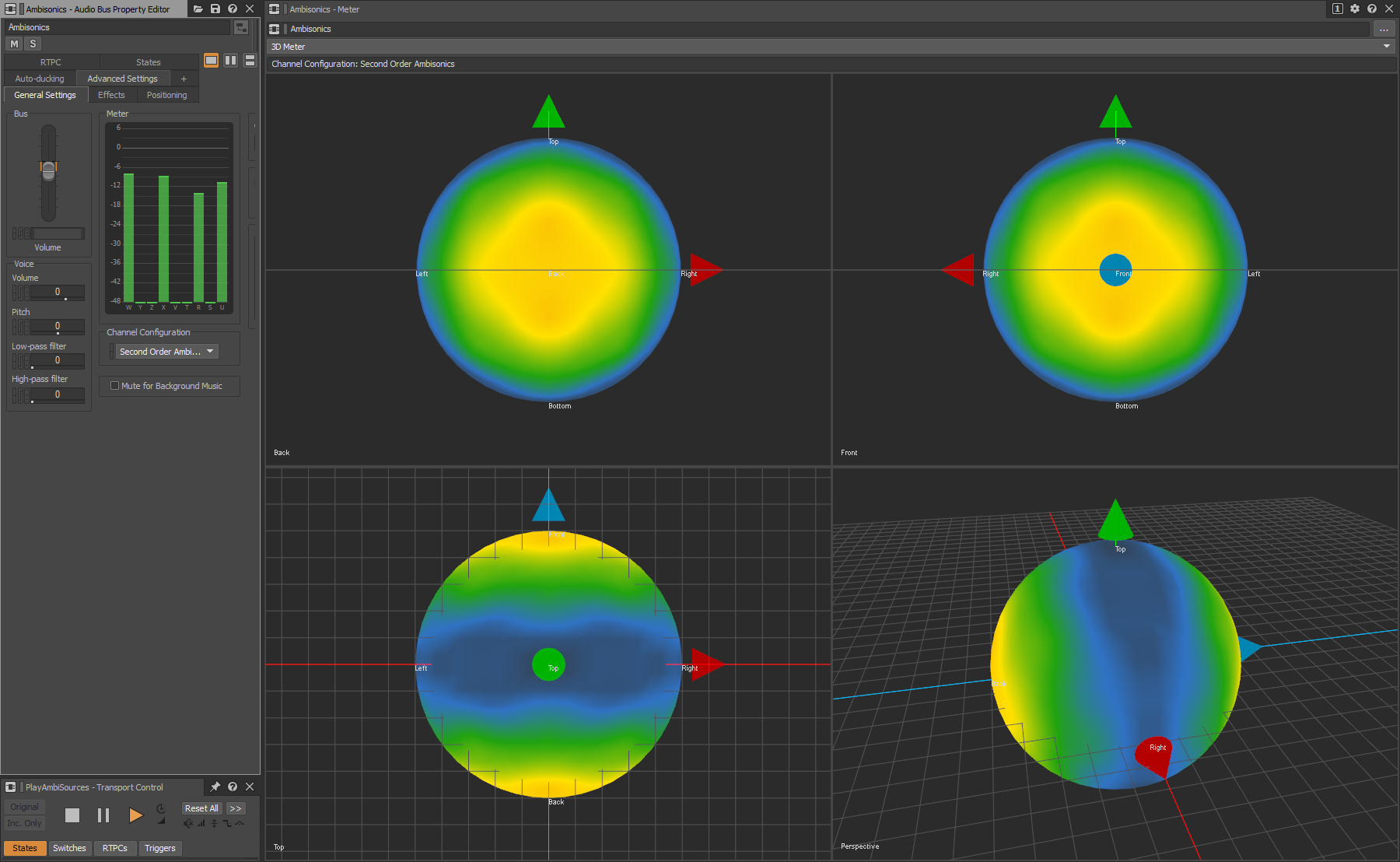

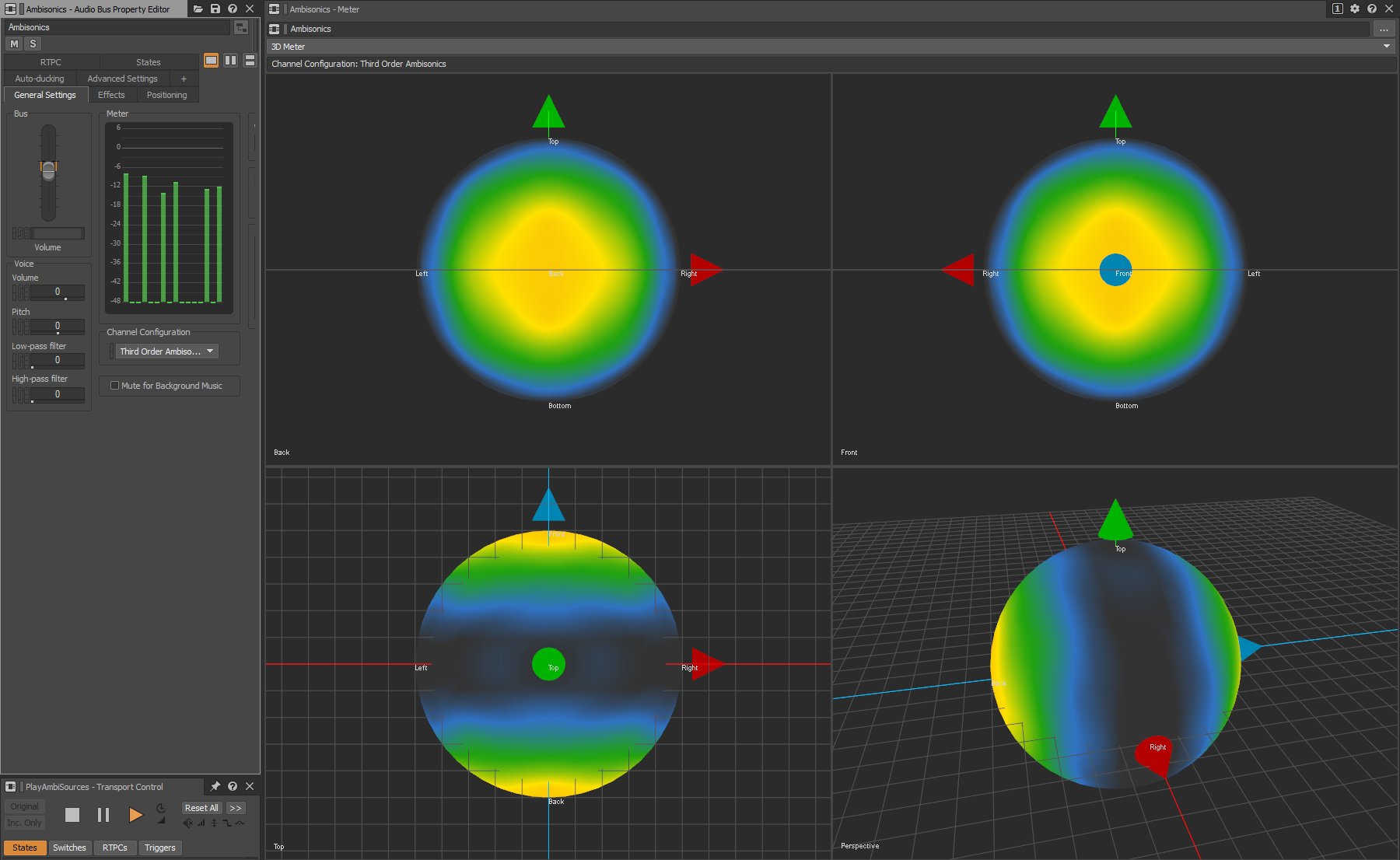

3D Meterを使えば、アンビソニックスの異なるチャンネルフォーマットの立体音響の解像度を比較することもできます。以下の例では、アンビソニックスバスの1次、2次、3次の立体音響の解像度を比較しています。ここでは2つのソースをバスにミキシングしていますが、1つのソースはフロントセンターにパンニングし、もう1つはリアセンターにパンニングしています。3次アンビソニックスバスの方が、両ソースの空間的ローカリゼーションの精度が高いのに対し、低次アンビソニックスのフォーマットでは2つが一緒にブレンドされるのが分かります。下図のビューポイントは、左上が背面、右上が正面、左下が平面、右下がパースの設定です。

FrontソースとBackソースを、1次アンビソニックスバスにミキシング

FrontソースとBackソースを、2次アンビソニックスバスにミキシング

FrontソースとBackソースを、3次アンビソニックスバスにミキシング

カラーマッピング

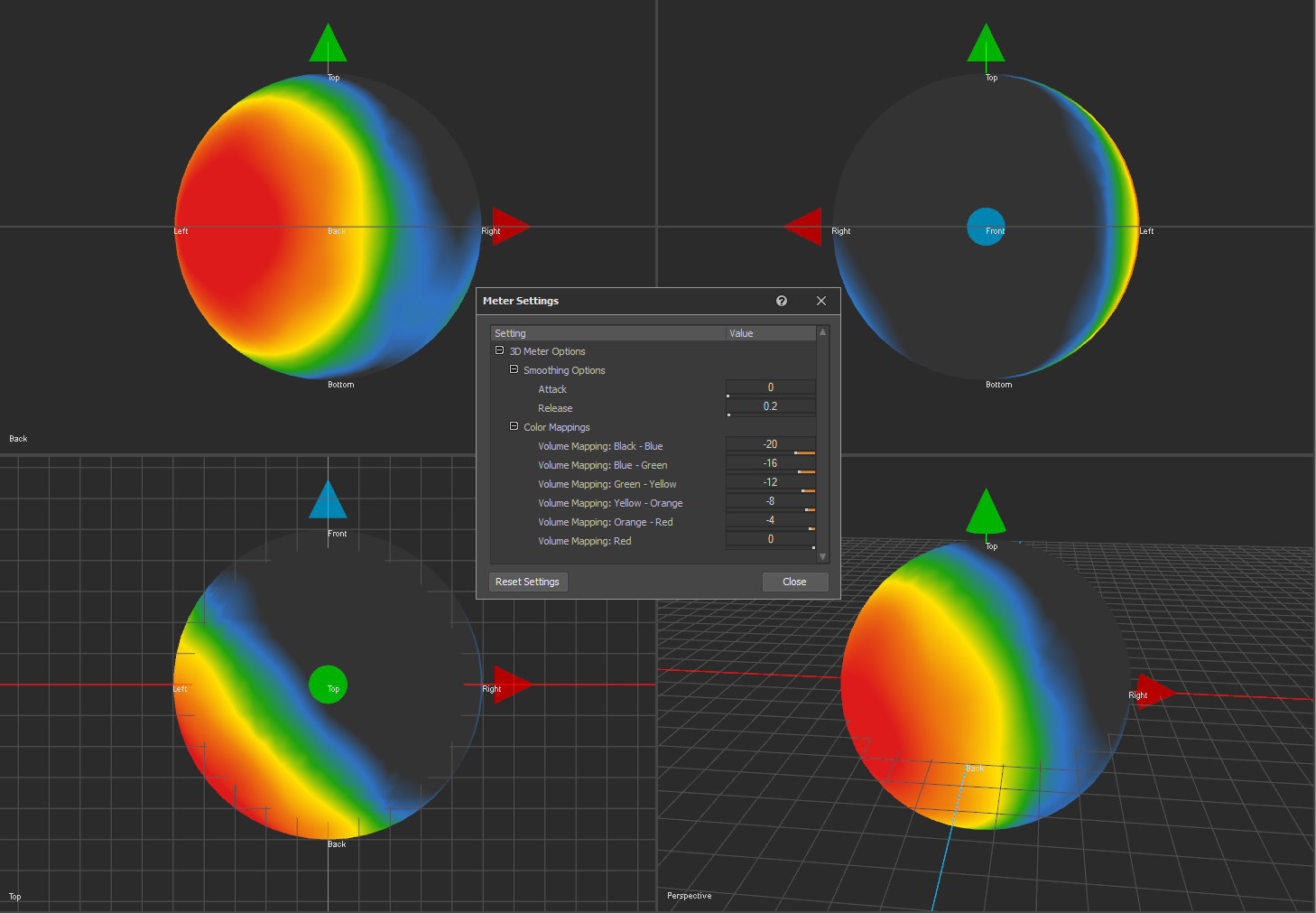

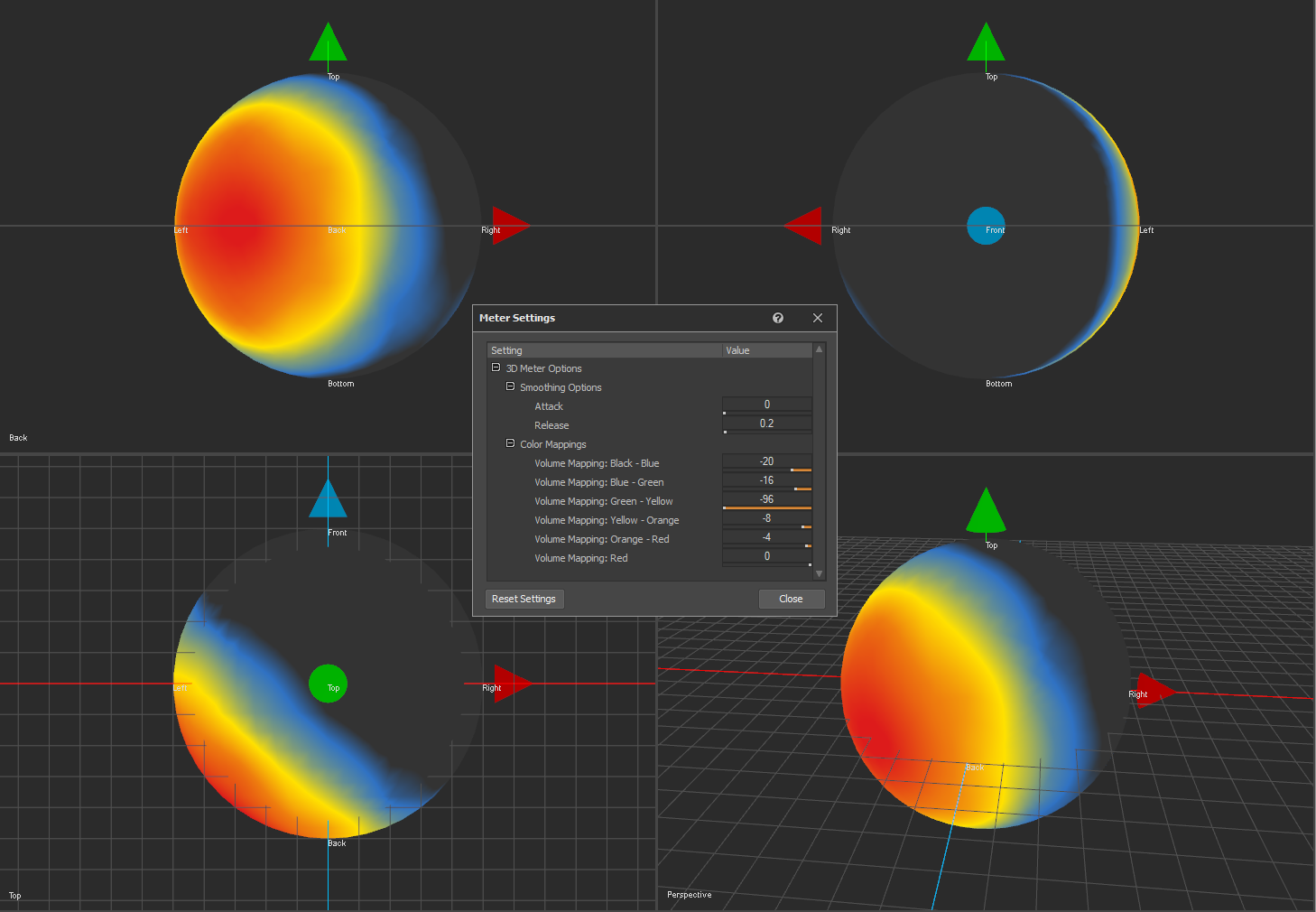

ヒートマップの色はそれぞれ事前に設定したデシベル範囲を表し、色のマッピングはMeter Settingsウィンドウで設定できます。Master Settingsで各色の閾値を単位dBで決めると、ちょうどその閾値から、次の色へのグラデーションが始まります。下図の場合、BlackからBlueへと切り替わるのが-20 dBから-16 dBの間です。次にBlueからGreenへと、-16 dBから-12 dBの間で切り替わっていきます。

メーター表示から特定の色を除外するには、そのdB範囲の上限を、それ以前のどの色よりも低く設定します。例えば下図のような設定にすれば、3D Meterに表示されるカラーマップからGreenが除外されます。

スムージング

3D Meterは、球体周りのバーチャルスピーカーのポジションを測定するときに、スムージングを実施します。スムージングは、MeterのEffectプラグインと同じように作用します。Attack値で表示値が10 dB上がるのにかかる時間が決まり、Release値で表示値が10 dB下がるのにかかる時間が決まります。なお、もしMeterのEffectプラグインを、アンビソニックスバスへのミキシング前の1つのソースに対して使うと、Meter Effectに表示されるソースのMeter値は、アンビソニックスバスの3D Meterに表示されるMeter値と一致しなくなります。理由はアンビソニックスのデコードプロセス中に適用されるゲインファクターにあります。オリジナルソースをMeterで測定するときは、スペーシャリゼーション処理をせず直接測定します。このソースをアンビソニックス信号にミキシングすると、ソースが空間内に配置され、リスナーから決まった距離だけ離れたポイントまで、移動します。アンビソニックス信号をデコードしてMeterで測定すると、オリジナルソースのレベルは、アンビソニックスの音場内のレベルの方が、単体で測定したときよりも小さくなるのです。下図は、ヘリコプターのプロペラ音がリスナーポジションの周りをぐるりと周る様子です。Release値を下げるにつれ、メーターがレベルの変化に素早く反応するようになり、Meterの表示内容もより迅速に変化します。Release値を上げると、Meter値は滑らかになります。

参考文献

-

Kronlachner, M. and Zotter, F., 2014, February. Spatial transformations for the enhancement of Ambisonic recordings. In Proceedings of the 2nd International Conference on Spatial Audio, Erlangen.(第2回 空間音響の国際カンファレンスの議事)

-

Lecomte, P. and Gauthier, P.A., 2015, November. Real-time 3D ambisonics using FAUST, processing, pure data, and OSC. In 15th International Conference on Digital Audio Effects (DAFx-15), Trondheim.(第15回 デジタルオーディオエフェクトの国際カンファレンス)

-

Trevino, J., Okamoto, T., Iwaya, Y. and Suzuki, Y., 2010, August. High order Ambisonic decoding method for irregular loudspeaker arrays. In Proceedings of 20th International Congress on Acoustics (pp. 23-27).(第20回 音響国際会議の議事)

.png)

コメント