ビデオゲームの制作品質はここ数十年のあいだで順調に進化し、オーディオ面も例外ではありません。ツールや技術の進歩によるところが、少なくありません。この記事で、ゲームオーディオは従来の媒体と何が違うのか、ワークフローの観点でいう最新技術は何か、そしてそれがインタラクティブその他の新しい「現実」のオーディオにどう影響するのかを考えます。

時間軸に沿ったリニアなオーディオプロダクションワークフロー

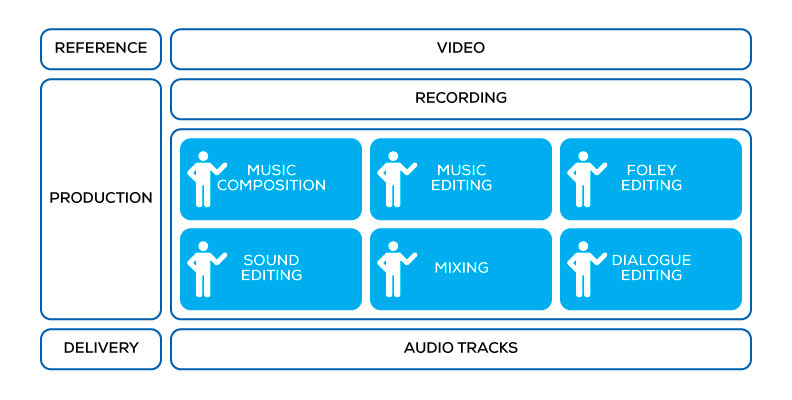

最初に、映画やテレビなどのリニア(直線)エクスペリエンスのオーディオコンテンツがどのように制作されるのかを考えます。アーティストは動画をレファレンス先としながら作業を進め、それに対応するオーディオトラックをつくります。作曲、編曲、フォーリー編集、音響編集、ダイアログ編集、ミキシングなどが該当します。それぞれの分野のエキスパートであるアーティストたちが、DAW(Digital Audio Workstation)というツールを使って作業する余裕が、あります。専門家たちによってつくられ、調整され、ミキシングされた最高級の材料だけを取り入れた複数のレイヤを次から次へと重ね、動画にぴったりと合うように設定して、観客のエクスペリエンス全体をサポートしながら向上させます。

リニアなオーディオ制作

リニアなオーディオ制作

理想的なのは、アーティストたちが完璧なレファレンス先、つまり視聴者のエクスペリエンスのうち、目にするビジュアルコンポーネントを正確に把握できて、それに基づいてオーディオコンテンツを作成して、最終的なエクスペリエンスを完全にコントロールできるケースで、DAWから出した音はそのままそっくり再生されます。

音のリニア再生。同期する音と画像の入った35mmフィルム。ロースト(Lauste)のシステム、1912年頃。

音のリニア再生。同期する音と画像の入った35mmフィルム。ロースト(Lauste)のシステム、1912年頃。

インタラクティブオーディオの制作ワークフロー

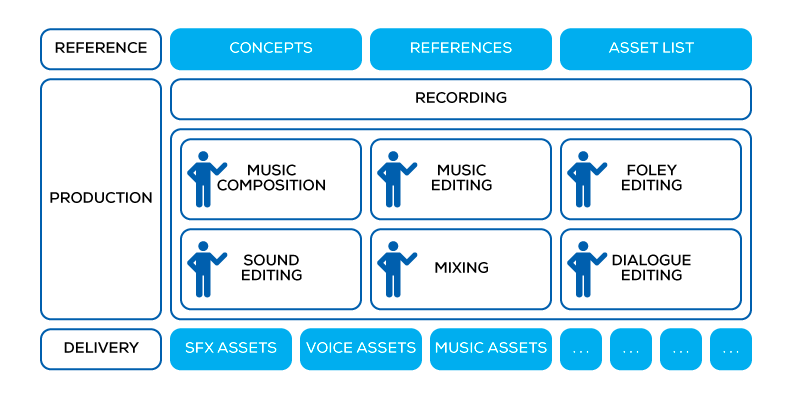

これがインタラクティブオーディオの制作となると、レファレンス先として使える完ぺきでリニアな動画がないので、根本的に違ってきます。ゲームはインタラクティブなので、発生する出来事が時間軸に沿って定まっているわけではなく、プレイヤーのアクションから導き出されます。そこでリニアなレファレンス先の代わりとなるのが、アイディア、コンセプト、そして部分的なアニメーションであり、このようなエクスペリエンスの破片がゲームプレイ中に一緒になります。

オーディオ部門が制作しなくてはならないのは個別のオーディオアセットで、DAWからエクスポートされる個々のWAVファイルです。

ゲームオーディオの制作

ゲームオーディオの制作

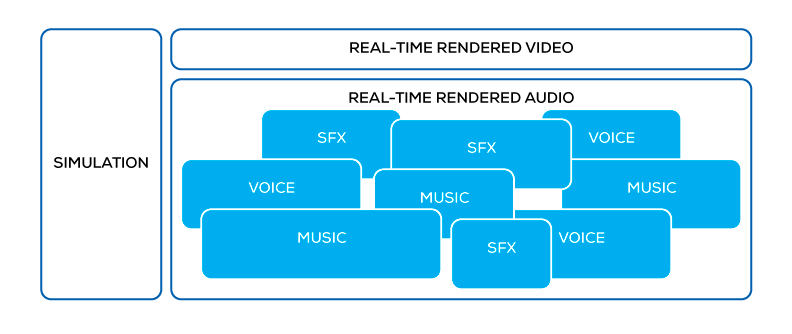

ゲームチームがオーディオアセットをゲームに組み込み、ゲームのエンジンが、コードやゲームエディタで設定したスペーシャルオーディオのルールやパラメータに従い、それらを再生します。

ゲームオーディオの再生

ゲームオーディオの再生

多くの場合はこの時点で、オーディオアーティストたちは、制作プロセスへの関与が減り、最終的なエクスペリエンスとは内容がずれたアセットを作成することになります。サウンドスケープのあらゆる面で弊害がおき、分かりやすい例としてミキシングが完全にバランスを失ったり、音楽がストーリーテリングの重要な要素ではなく単なるBGMに格下げされたりします。

専用ツールを活用した、ゲームオーディオの制作ワークフロー

“クリエイティブプロセスの半分は、インプリメンテーションだ。” – コール オブ デューティの、マーク・キルボーン(Mark Kilborn)

再生中の内容にオーディオがどう反応するのかをアーティストたちが定義するには、実装フェーズに参加する必要があり、このニーズはゲームオーディオから発生したもので、インタラクティブオーディオ専用のプロダクションツールの需要が生まれました。ゲームオーディオのパイオニアたちは、この目的のために採用できるソフトウェアツールが非常に少ないことを知りました。Max/MSPやSupercolliderなどのオーディオプログラミング環境は、必要とされるプログラム拡張性を備えていますが、DAWから出てくるものに対して非常に不慣れで、ゲームアセット制作という規模に見合った生産性を提供できません。

このような背景のもとで生まれたのが、ゲームオーディオ用ミドルウェアです。サウンドデザインにプログラマーが直接関与した初期の頃の慣習からベストプラクティスを抽出して、それらを元にアーティストフレンドリーなツールセットが構築されました。

ゲームオーディオのミドルウェアはオーディオ制作に追加された別のステップで、ちょうどDAWとゲームエディタの間に位置付けられます。考え方として、オーディオの完全にリニアな部分をDAWで担い、次はアーティストが完全かつ高性能のオーディオ構造をつくりだせるような、つまりアセットと動作を組み合わせられるる、別のオーサリング環境に移行します。

提供される機能を全て説明すると今回の記事の範囲を超えてしまうので、インタラクティブミュージックのツールセットに注目して、インタラクティブオーディオ構造をビルドするために必要なインタラクティブミュージックツールセットにフォーカスをあてます。

インタラクティブミュージックのツールセット

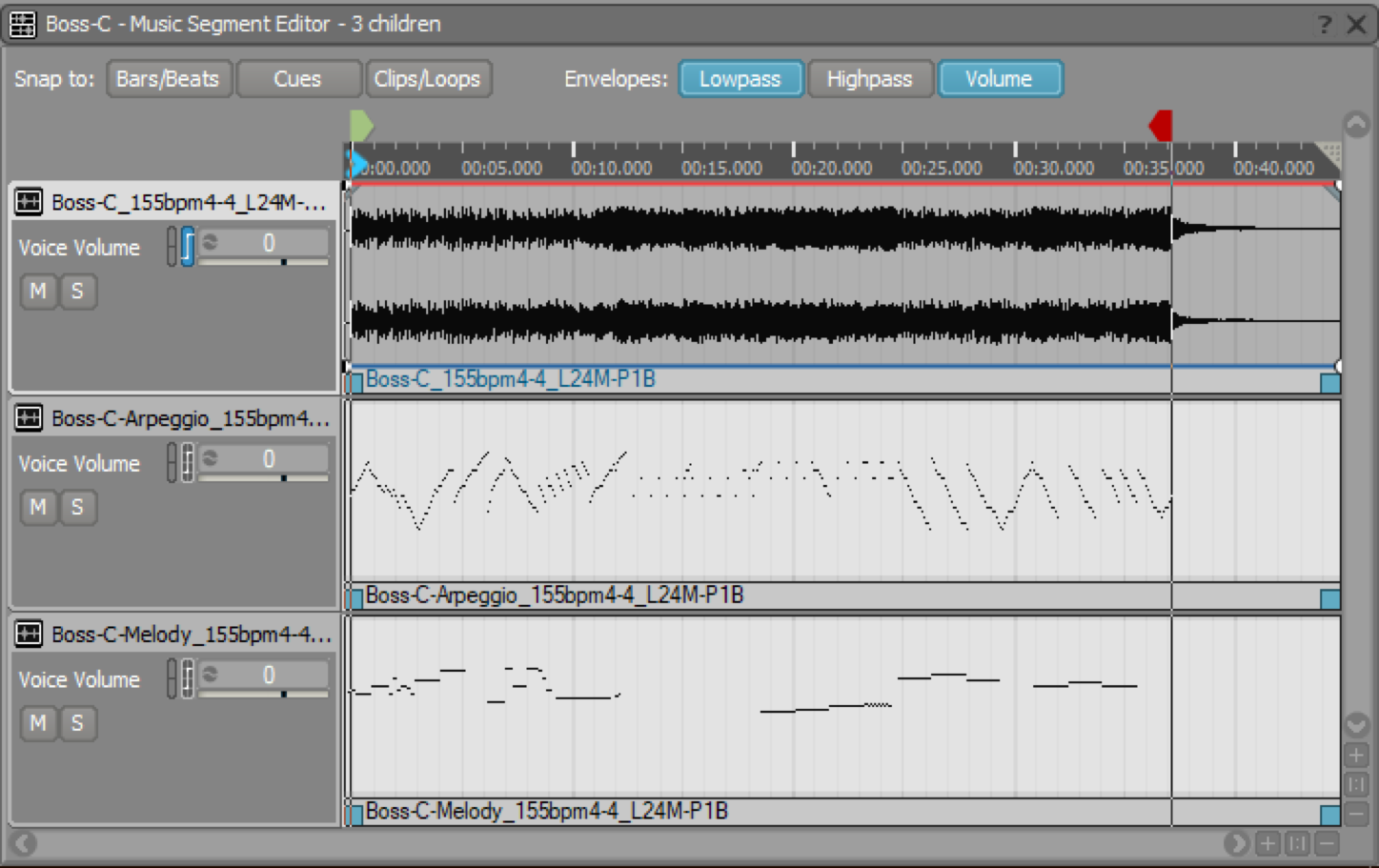

トラック内の各セグメントを個別にDAWからエクスポートして、WwiseのInteractive Music階層のトラックに、クリップとしてインポートします。

WwiseのMusic Segment Editor

WwiseのMusic Segment Editor

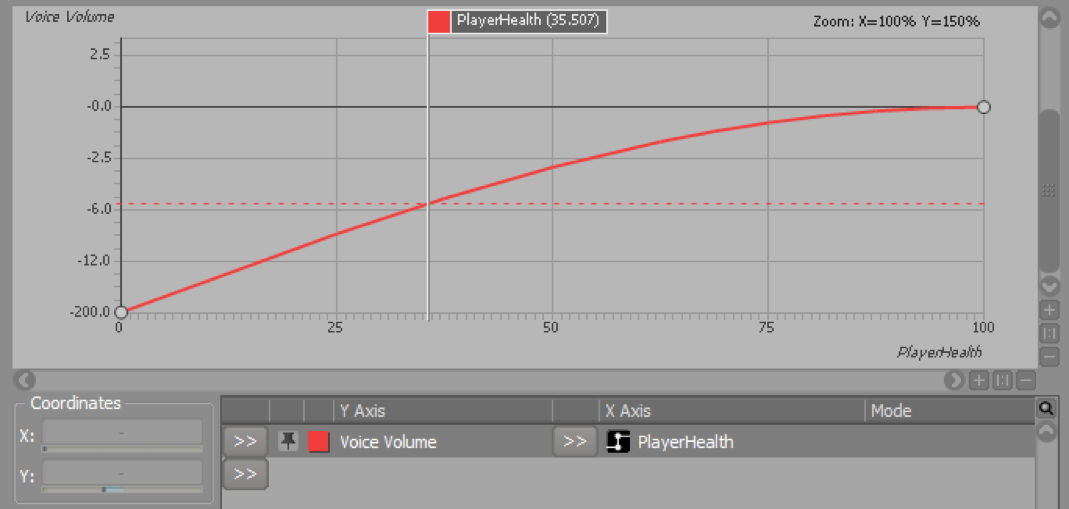

ゲームパラメータをミキシングレベルに紐づけたり、

WwiseのGame Parameter Graphビュー

WwiseのGame Parameter Graphビュー

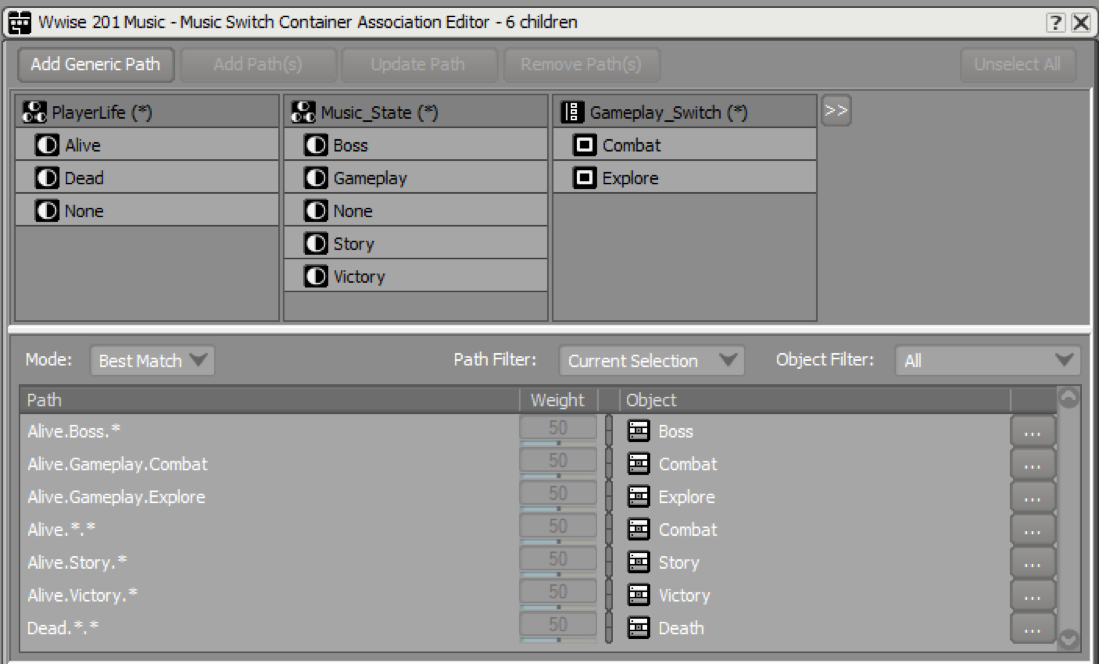

ミュージックスイッチコンテナの一部としてゲームステートをミュージックセグメントの選択に紐づけたり、

WwiseのMusic Switch Association Editor

スティンガーと呼ばれる、音楽の上に重ねる音楽的レイヤを、特定のゲームプレイエレメントでトリガーできます。細かくセグメントを分けると、よりインタラクティブに反応できる構造となり、ゲームシミュレーションの動きに対する反応の精度もあがります。

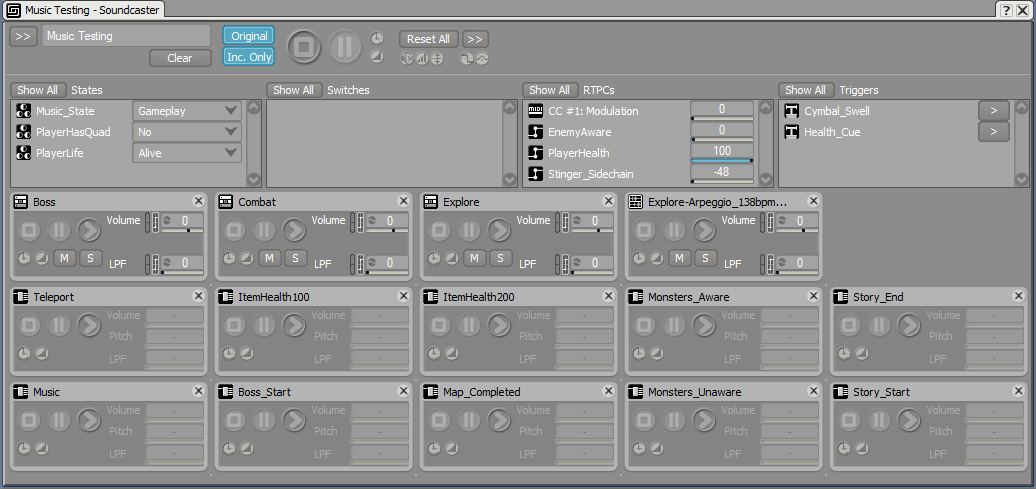

完璧を目指すには、イテレーションが重要です。DAWでコンポーザーが素早く音楽コンポジションを調整して、すぐに結果を聞けるのと同様に、インタラクティブミュージックのコンポーザーも目指す動きを達成できるまで、何度もゲームとの紐づけを調整する必要があります。Wwiseには、マニュアル操作でゲームからの刺激をシミュレーションする機能と、

WwiseのSoundcaster

実際に稼働中のゲームに接続する機能もあるので、音の構造がどのように反応するのかを確認しながら、随時設定を変更できます。

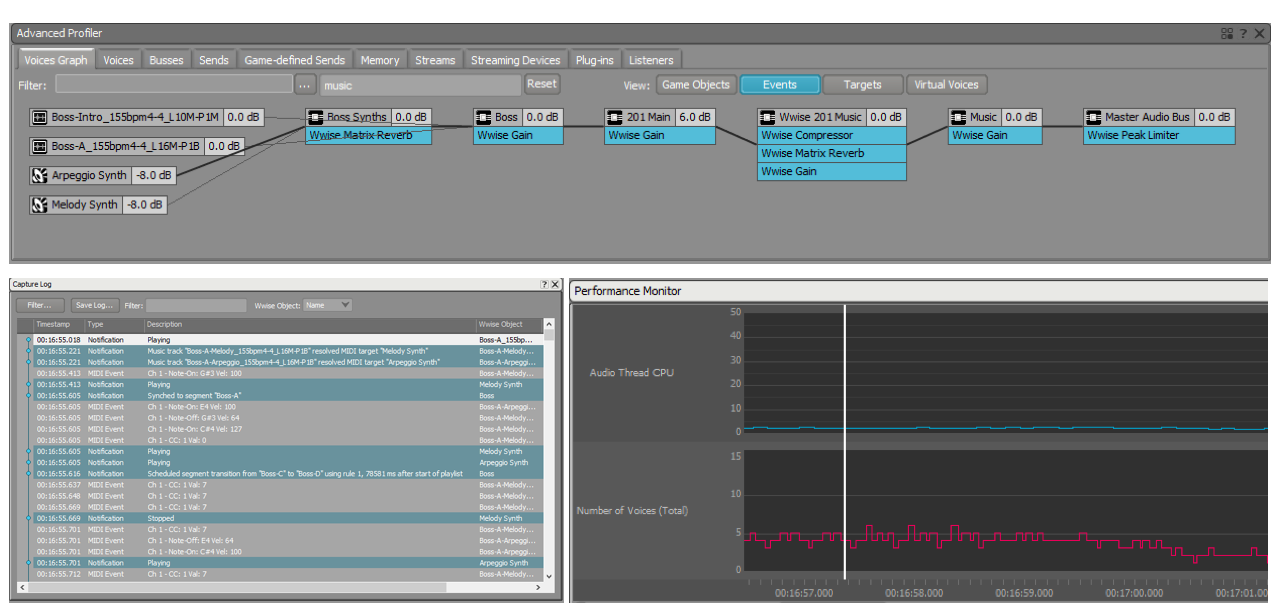

Wwiseのインタラクティブミュージックのプロファイラ

Wwiseのインタラクティブミュージックのプロファイラ

VRのストーリーテリングへの応用

これらはすべて、VR(仮想現実)のゲームに直接適用できることを誰もが確信していますが、もっとリニアで、お話を読むようなストーリーテリングのエクスペリエンスはどうでしょう?もちろん使えます!エクスペリエンスの中でも最もリニアな部類に入る360°動画を例に考えます。

通常の動画から360°に移行するときに、プレイヤーが自由に動きを決められるのが1点だけあり、それがビューポイント(視点)の回転です。視聴者が頭を回すと画面のビューが新しい視野に合わせて動き、少なくともオーディオが同じように反応するのは全く自然です。これが360°動画コンテンツの基準点となり、動画を補完する球体状のオーディオにアンビソニックの音場が採用されます。

さらに一歩先に進めてオーディオの一部が実はワールドの一部ではない(ノンダイジェティック)だと考えれば、それはスペーシャリゼーションを適用せずにステレオストリームとしてヘッドフォンで直接再生するべきです。さらに、リスナー用のコーンを実装すれば、ビュアーの正面に現在あるものがミックスの中でも目立つようにすることが可能です。例えば、FB360スペーシャルオーディオワークステーションのフォーカスエフェクトなどです。

回転とスペーシャリゼーションの間に、このように純粋なバインディング(紐づけ)設定を設けてこそ、(フォーカスの導入以外は)リアルで正確ですが、一方で、アーティスティックな方向性を工夫する余地はさほどありません!従来の動画を作成する場合のサウンド担当者は、雰囲気を正しく表現して視聴者から望ましい感情を引き出そうとして、リアリズムからできるだけ離れようとすることが多いです。ゲームと同じで、アーティストが定義できる再生機能を導入する必要があります。

それでは、360°動画のサウンドスケープ構築のアプローチとして、私たちは何を推奨しているのでしょうか?すでに説明したようなインタラクティブオーディオ構造と同じようなものをつくり、ビューポイントや動画のパラメータなどを使って、オーディオ再生側に情報を(ゲームエンジンのシミュレーションデータの代わりに)送ります。サウンドスケープの中でこのアプローチによる恩恵を最初に受けるのが、音楽です。例えば、テーマ曲の効果は、視界に出現する重要キャラクターとタイミングがあっているかどうかによって、大きく変わります。これは、音楽をインタラクティブに管理しない限り、達成できません。

もう1つのエレメントは、オーディオミックスそのものです。例えば、ビーチに立って波を眺めたあとに、海から顔を背けて反対側にあるシティーを見たとします。映画監督であれば、カメラのフォーカスによってミックスを大幅に変えるように依頼するだろうと思われる一方、空間的関係を再現しただけの場合は、エレメントのポジショニングのみ変わります。

結論として、例え自由度がほんのわずかでも、洗練されたインタラクティブオーディオの各種メソッドを真剣に検証する必要があります。ゲームのエクスペリエンスをゲームエンジンでレンダリングした場合は自然なことですが、これらの技術の少なくともいくつかはオンデマンドのチャンネルで配信される360°動画コンテンツ用に提供されると予想され、プレイヤーが期待するレベルのものを見せるには必要です。無声映画の時代に生演奏で上映中の映画に音楽を随時合わせていた頃に戻ったようで、興味深いことです。

この記事は、新著『New Realities in Audio』への寄稿として書かれました。

New Realities in Audio

A Practical Guide for VR, AR, MR & 360 Video

作者: Stephan Schütze, Anna Irwin-Schütze

コメント