仮想現実(VR)の体験を、仮想の世界から切り取って、現実の世界に仮想世界の要素を維持したまま入れることを想像してみてください。その部屋にいる人が普通のVR空間にいるような感覚で行動しているのに、誰もゴーグルやヘッドフォンを着用していないという「ミックスド・リアリティ」のような世界。

我々Riverside Studios/Lucha Libre Audioのチームはベルリンで、Factory BerlinのためにNEEEUが開発したXR Roomエクスペリエンスで、この実現に挑みました。NEEEUはここベルリンで最も著名なデザインスタジオの1つで、Factory Berlinはヨーロッパ最大の国際イノベーションコミュニティとして、クリエイティブな人が集まって自分たちのアイディアやコンセプトを立ち上げるのを助ける、コワーキングスペースです。アンディ・ウォーホルの、ニューヨークのシルバーファクトリーに似ています。

NEEEUは3Dエクスペリエンスを開発し、通常のVRゴーグル上で納品する代わりに、大部屋に8台のプロジェクターを設置し、来場者がリアルな世界にいながら、このエクスペリエンスとやり取りができるようにしたのです。まず私たちが最初に直面した課題は、このような形式で表現されるVRの要素に、どうやって音や音楽を正しく付与するか、でした。そこで、偽の壁を建てて、その裏に64台のスピーカーのアレイを設置し、すべてのオーディオをアンビソニックスで実装することにしました。まず偽の壁を施工し、次にヨーロッパ各地のプロジェクトで巨大なサウンドスケープを納品した実績のあるハンブルグ拠点のWeSound社が、スピーカーを設置しました。WeSoundが使用したのはチューリッヒ芸術大学のInstitute for Computer Music and Sound Technologyが出した、ICST Ambisonicsというツールです。

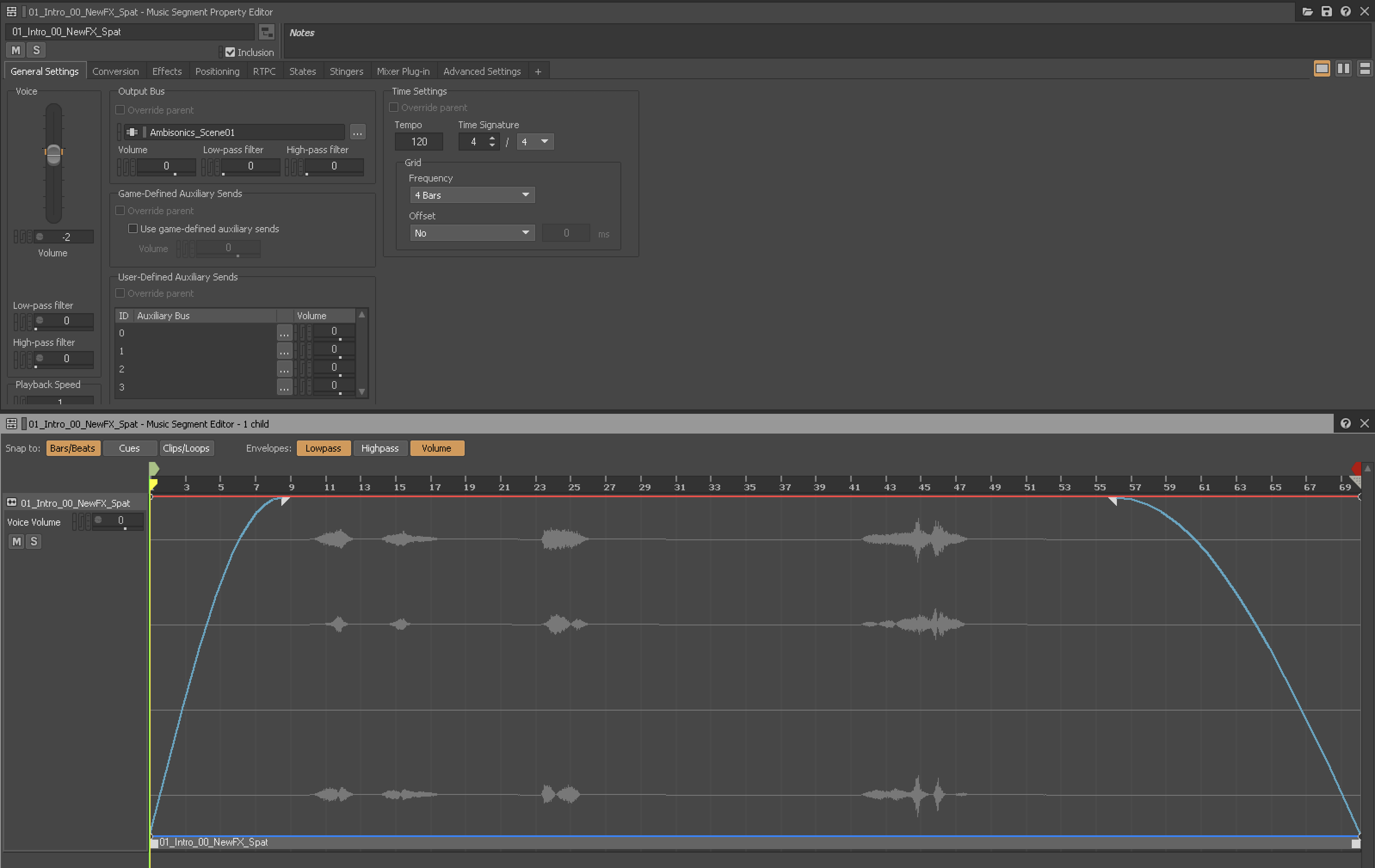

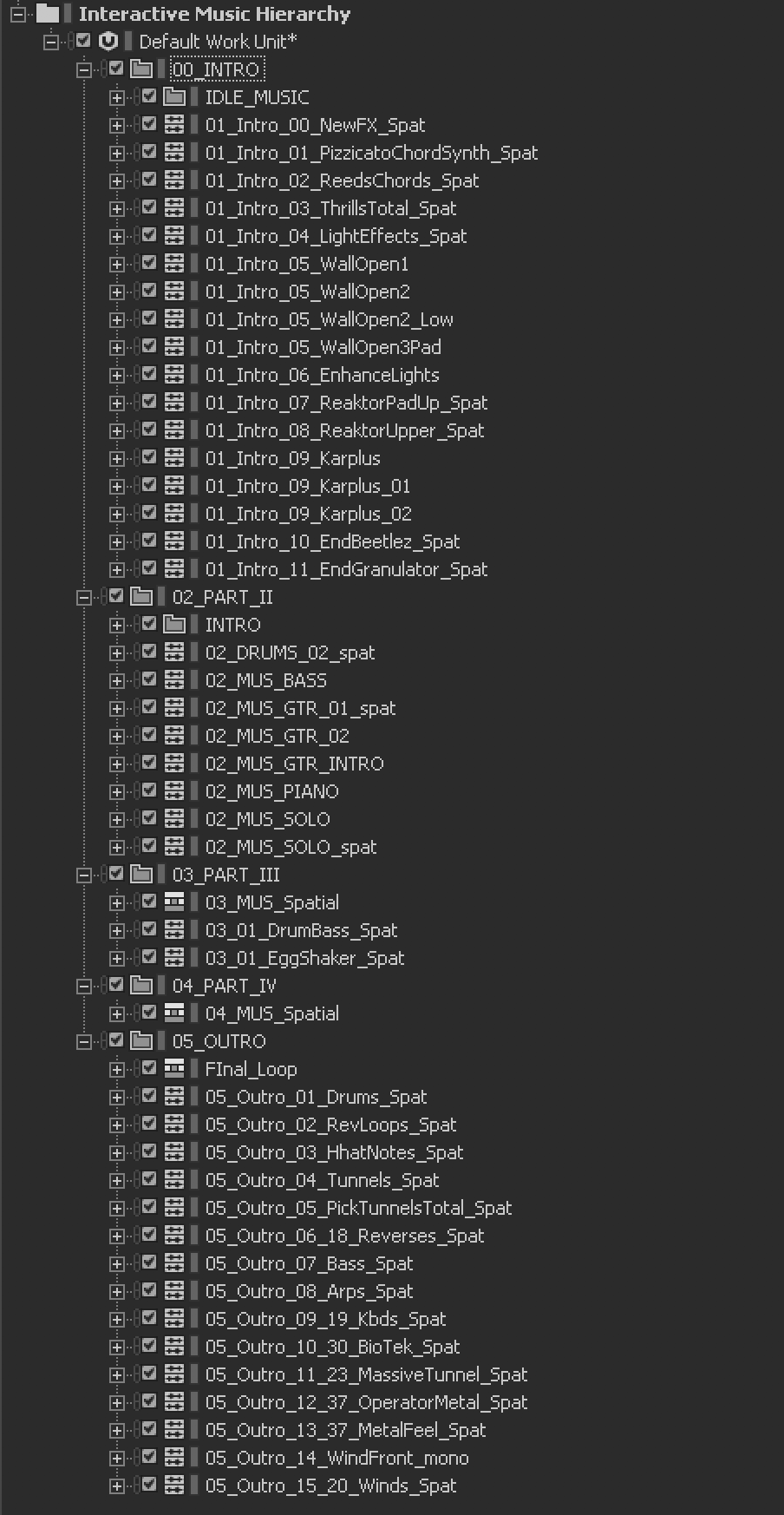

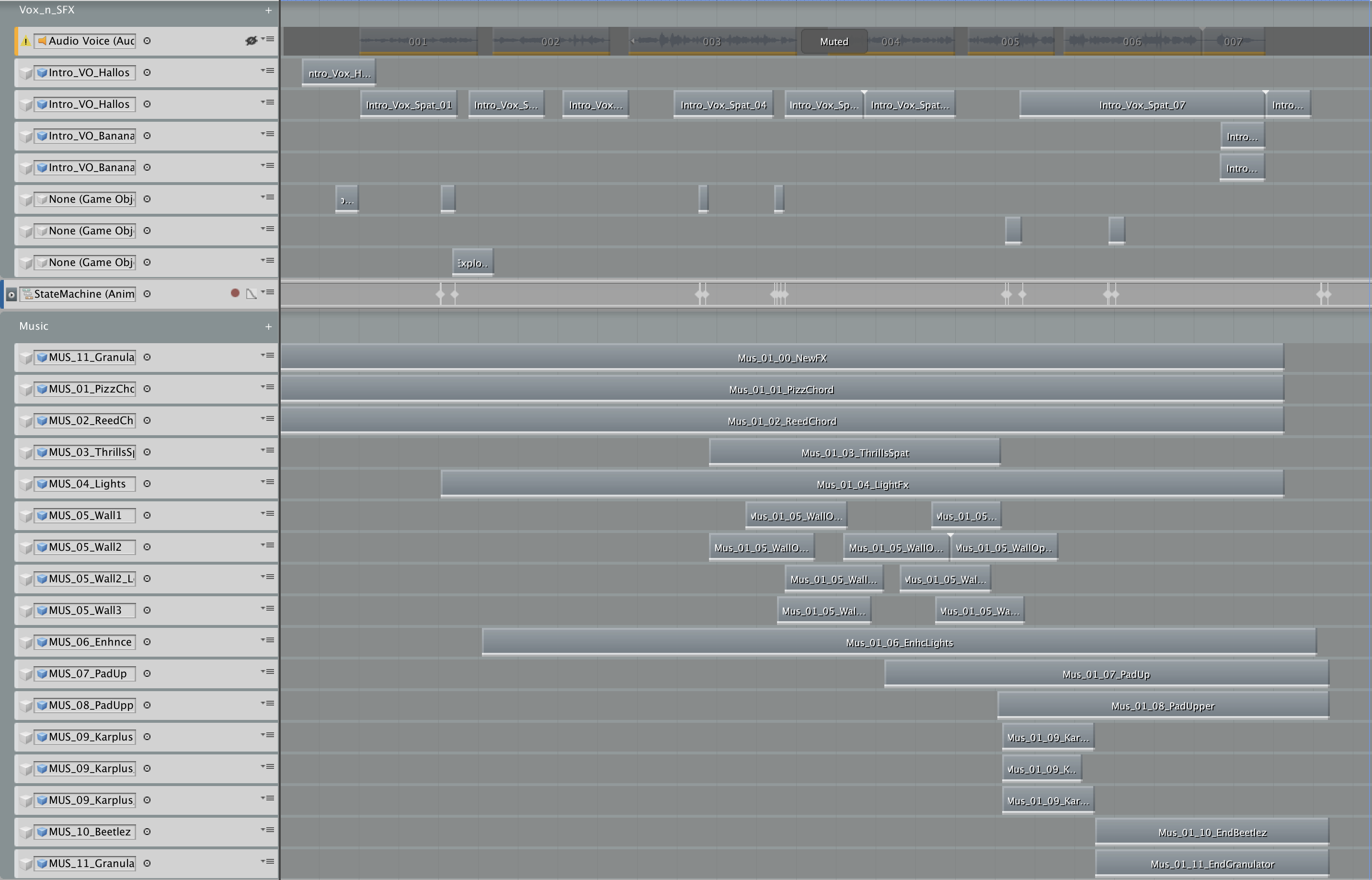

ハードウェアの設定がすべて完成すると、いよいよ音楽やサウンドエフェクトをプロジェクトに追加し始めました。プロジェクト自体はUnityで開発され、高度なプロジェクトだったため、私はオーディオにWwiseを採用することにしました。このエクスペリエンスの各レベルに合わせてまず、すべてのMusicやSound EffectをWwiseで整理しました。64台という全スピーカーを最も効果的な方法で使う必要があったので、私は各レベルの音楽をステム(stem)に分け、それらのステムをビジュアルのポジションに合わせてUnityとWwiseで空間的に配置し、さらにサウンドエフェクトや優れた女優で声優のエミリー・ベーア(Emily Behr)氏のボイスオーバーも、スペーシャリゼーション処理をして追加しました。

XR Roomはリアクティブなルーム、つまり「反応できる部屋」だったので、訪れた人はHTC Viveコントローラを使い壁の「反応」を体験することができ、そのためにも全サウンドエフェクトを正確に配置することが不可欠でした。私はすべてを分けて、複数のAttenuation(減衰)を作成しましたが、シーンによって、シーン自体の大きさや長さや目的が異なるので、適切なサウンドエフェクトを各シーンに設定する作業にWwiseが大変役に立ちました。

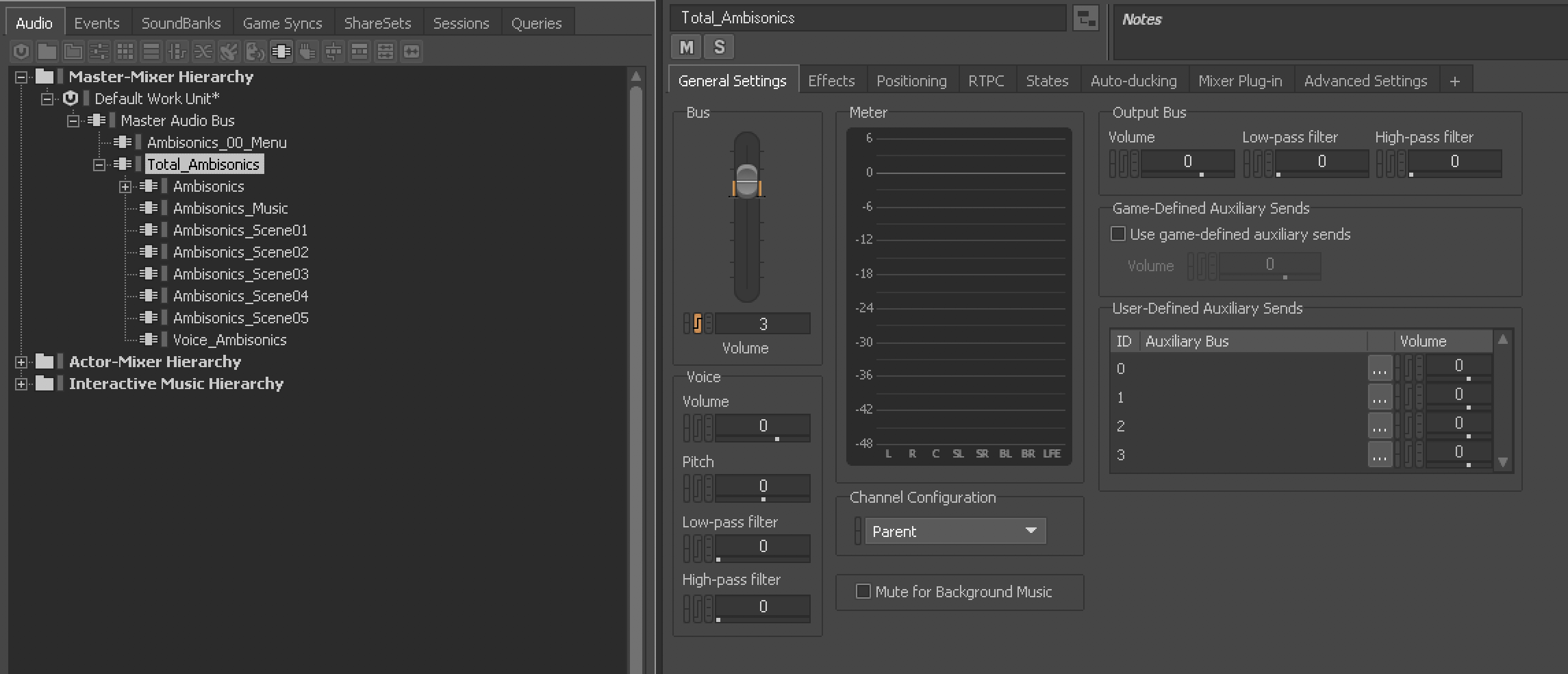

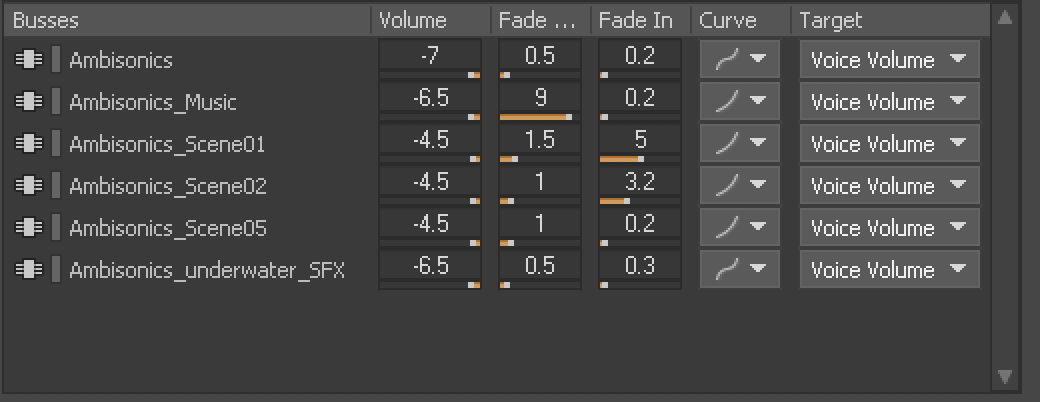

タイトなスケジュールだったので、すべてが滞りなく流れるように必死に対応している開発者に、あまり頼み事をするわけにもいきません。音楽やサウンドエフェクトはどれもシーンごとに異なり、リピートはなかったので、私はWwiseを使い、シーンを複数のAudio Busに分け、音が1つのシーンから別のシーンにブリード(bleed)するのを防ぎました。ただしボイスは、どのレベルにも共通する唯一の要素だったので、専用のAudio Busに入れ、オートダッキングも一部設定しました。

音楽に関しては、シーンごとにサウンドスケープを作成する必要があり、Unityのオブジェクトも使いました。いくつかの楽器といくつかのステムをAmbiX 1st Orderでミキシングしたので、部屋の準備をしてサウンドのミキシングをするときにも非常に役立ちました。基礎となる部分はすべてAmbiXでしたが、特定の楽器や音など厳密に配置する必要があるものについてはmonoで納品し、シーン別に、オブジェクトに付けていきました。

また、アニメーションに対して正確にオーディオを追加することも重要なタスクの1つで、これには、Unityのタイムラインのアニメーションプロセスを利用しました。それぞれの楽器をステムに分け、次にUnityを使い、プレゼンテーション中の発生する場所と時間に対し、正確に追加していっただけです。

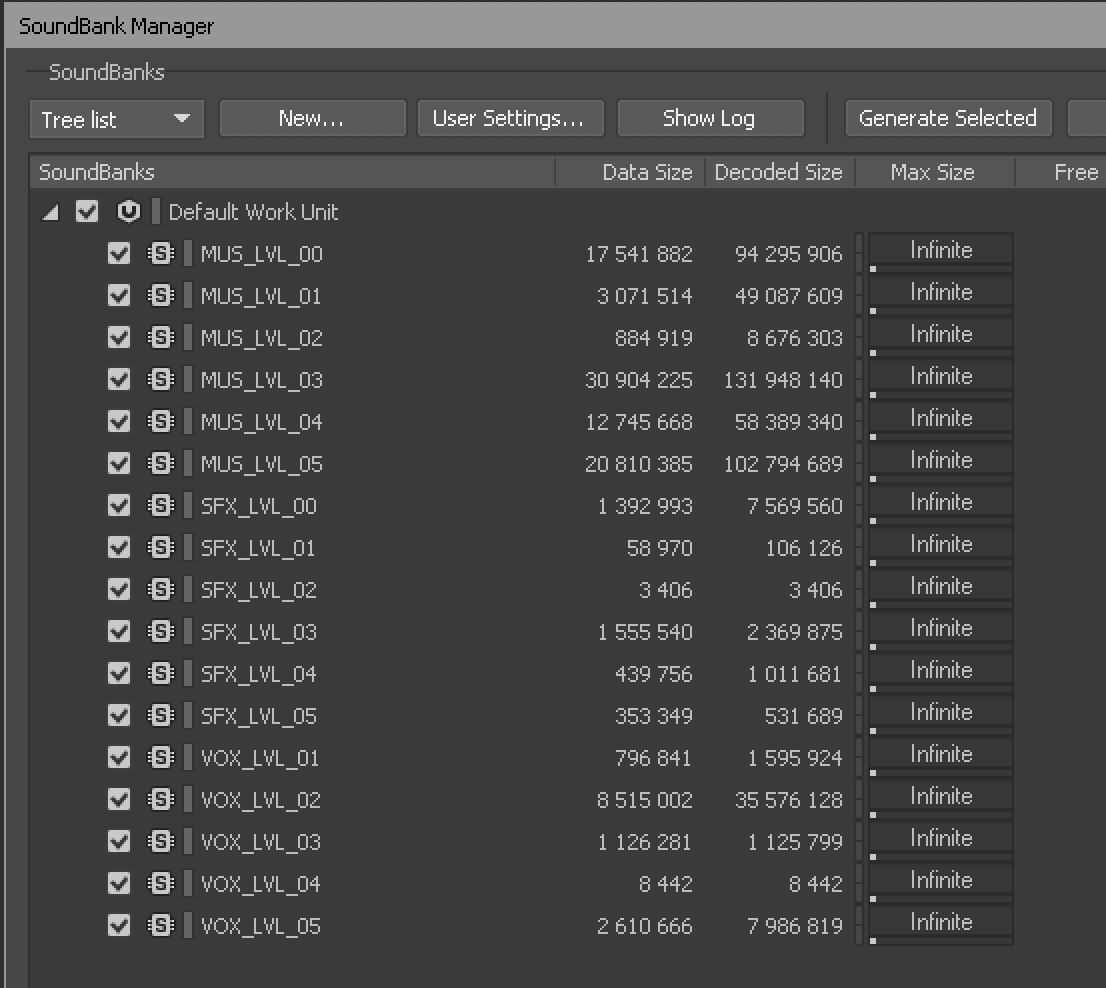

最終的にはMusic、SFX、VoiceでSoundBankを分け、さらにSoundBankをレベル別に分割しました。すべてをトラッキングするにはこの方法が一番簡単で、私の最終的な実装中に、Unity開発者が命名規則で四苦八苦するのを避けるのにも役立ちました。開発者たちはサウンド関連の作業を何もしませんでしたが(例外的にレベル4では、楽譜に基づいて特定のボイスオーバーが発生することについて一緒に検討しました)、彼らも読めば、どのサウンドがどこにくるのかを理解できました。

このエクスペリエンスの全体の実装はオープニングの数日前に行われ、部屋自体は準備できても、私は常に自分のスタジオで作業をしていて、スタート前に現場でミキシングできたのは1日だけでした。これに使うのに選んだプラグインは、Resonance Audio Rendererです。私はクリエイティブ作業中はヘッドフォンを使い、展示部屋でどのような音になるのかを全体的に把握しました。実装に際しては、マイナーチェンジを少し行っただけです。

それではご自分のヘッドフォンを付け、このエクスペリエンスから次の3つのシーンをお楽しみください。YouTubeリンクからは1st Orderしか聞けませんが、もしFactory Berlinまで来て、このプロジェクトを体験する機会があれば、どうぞ私のゲストとしていらしてください。

第1シーン

第2シーン

第5シーン

-

· クライアント - Factory Berlin - Paul Bankewitz

· 建築設計 - Anna Caspar

· 施工 - Ralf Norkeit

· 音響 - Rummels Acoustics

· 3Dビジュアル&コンセプト - NEEEU

· スピーカーコンセプション - WeSound

· ミュージックコンポーザー - Oliver Laib/Billy Mello/Paulinho Corcione

· サウンドエフェクト&サウンドデザイン - Billy Mello (Lucha Libre Audio)

· ボイスオーバー - Emily Behr

· プロジェクトマネージャー - Ima Johnen (Riverside Studios)

コメント