この連載ブログは、2020年10月に開催されたGameSoundConでのプレゼンテーションに関連しています。プレゼンテーションの目的は、クリエイターたちが、オブジェクトベースのオーディオレンダリング技法を使って次のプロジェクトに磨きをかけられるように、視点とツールを提供することでした。自然界で私たちが体感する音にできるだけ近い立体感を、これらの技法で再現できるのです。

このブログの内容は、次のように3つに分けました:

- 第1部である今回は、新しいプロジェクトに挑むオーディオのプロフェッショナルが、チャンネルベースのオーディオの代わりに、オブジェクトベースのオーディオを使用した場合のメリットを紹介し、この方式の方が複数のシステムや再生エンドポイント向けに、より良い結果をもたらすことを示します。

- 第2部では、進化を遂げたWwise 2021.1版が、オーディオオブジェクトを充分に活用した包括的なオーサリング環境と、あらゆるミキシング状況にも対応するように強化されたワークフローを提供する方法を説明します。

- 最後に第3部では、最近のプロジェクトでサウンドデザイナーやコンポーザーが採用した、オーディオオブジェクトの様々な手法、テクニック、裏技などを紹介します。

空間化された音の符号化 その歴史

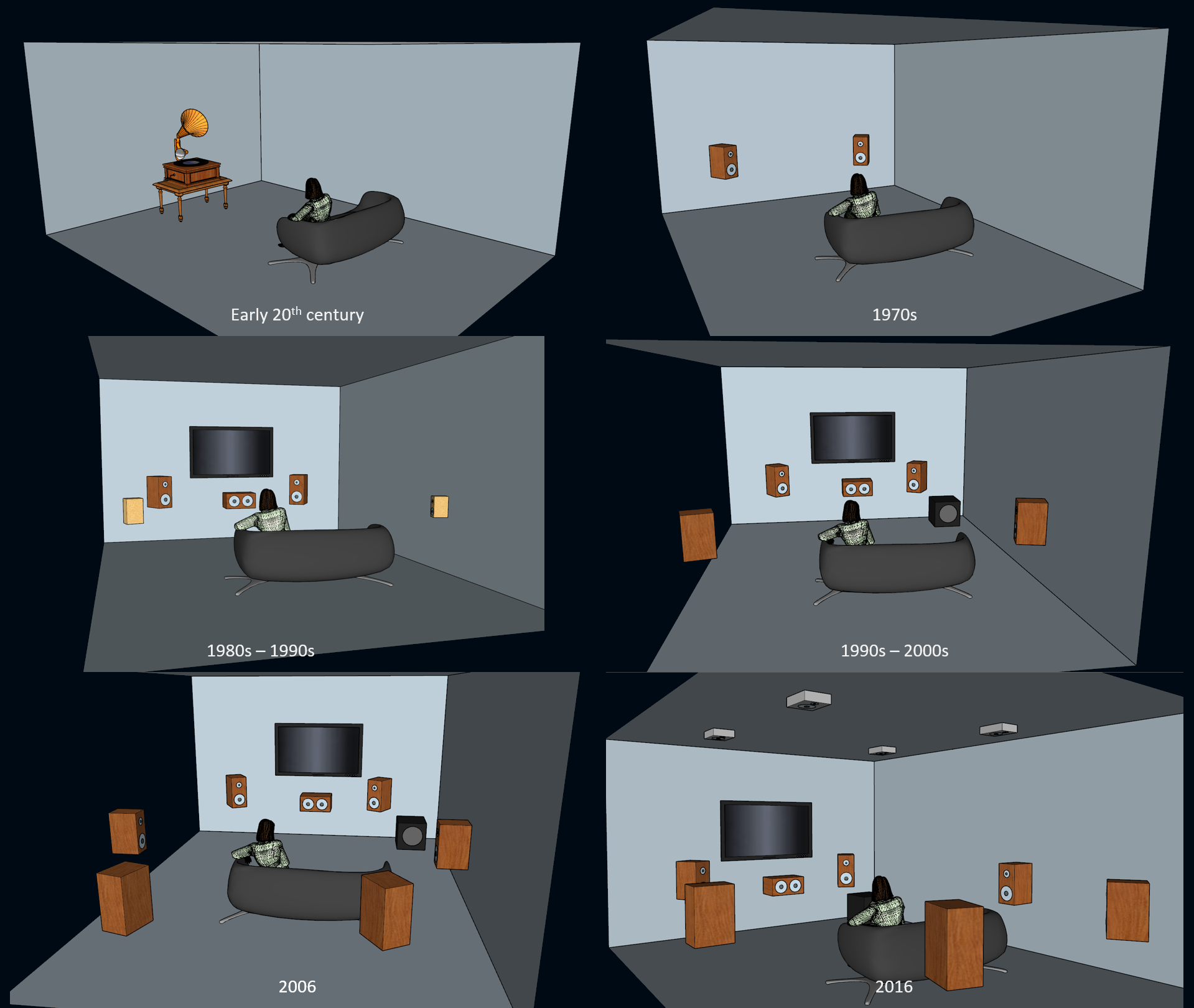

音声を符号化して再生するという試みは、100年以上も前から行われています。数十年間、このような符号化はモノラルで録音されたため、その性質上、音の空間化を表現することはできませんでした(ただし、モノラル録音は、空間化の形態の1つである「奥行き」を容易に捉えているという意見もあります)。その後、1970年代になってようやくステレオシステムが一般的に普及したおかげで、立体的な要素を持つ音楽の再生が広まりました。ステレオフォーマットが一般的に受け入れられると、サウンドエンジニアや音楽愛好家たちは音の空間化や方向性を出すためのミキシングを開始し、話題にするようになりました。

その後1980年代に入るとVCR(Videocassette Recorder)が広く普及し、VHS(Video Home System)でレンタルした映画を楽しめるようになると、業界内で「家庭でも映画館の雰囲気を」という考えに注目が集まりましたが、それには一般の人が新しいセットアップのサウンドシステムを購入することが前提でした!このように、業界全体がLCRS(Left-Center-Right-Surround)からダイナミックな全周波数帯域を可能にする適切な5.1スピーカーコンフィギュレーションへと発展し、続いて7.1チャンネル、そして今ではHeightチャンネルを追加した7.1.4チャンネルにまで進化しました。

消費者をとり囲む空間オーディオ再現の進化

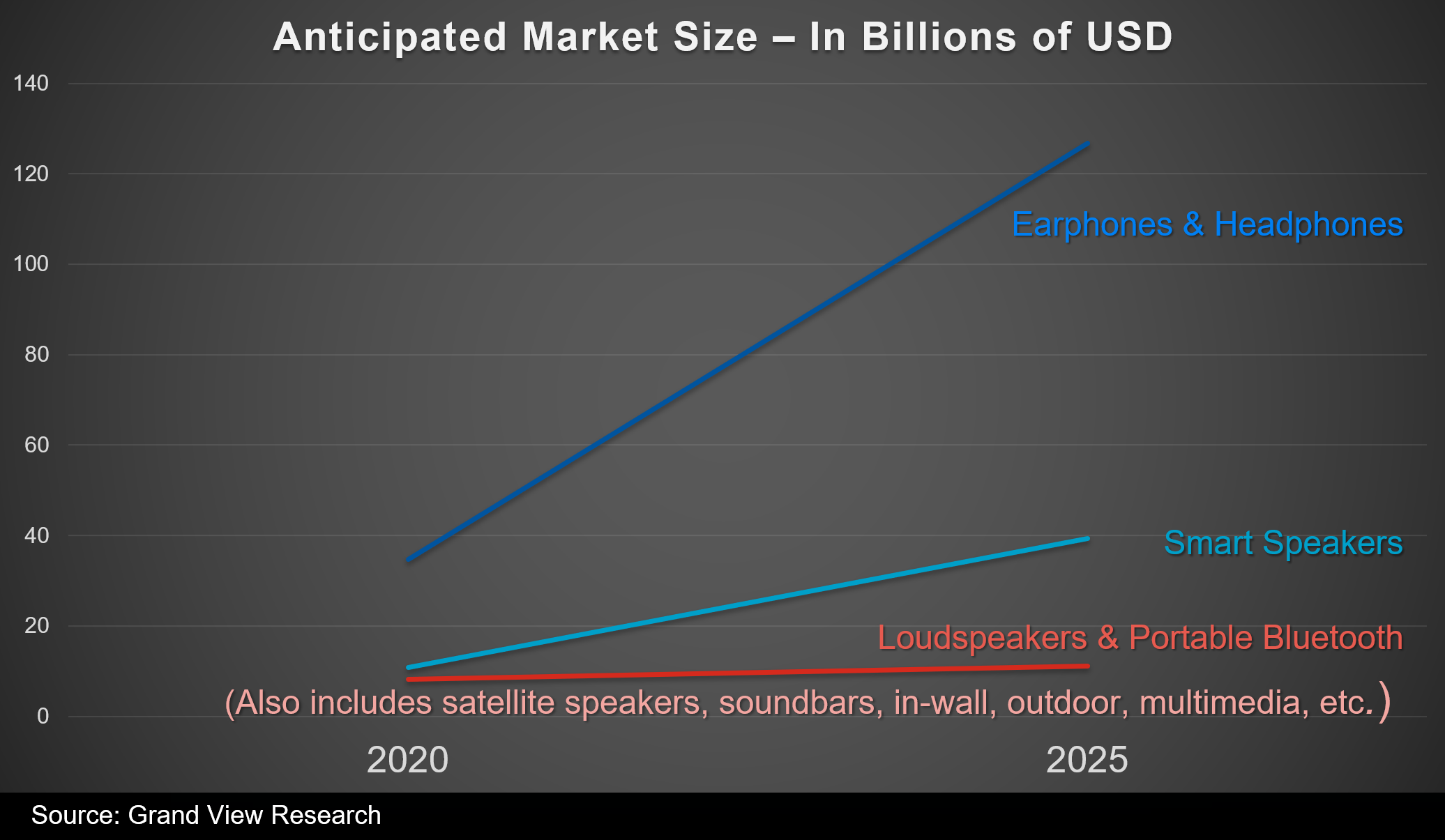

とはいえ、この10年で、一般的なライフスタイルがモビリティーにシフトしたのに伴い、リビングにスピーカーを増設するという考えが薄れ、ヘッドフォンの利用が増えています。これにはモバイルゲームやマルチプレイヤーゲームの普及が影響しているのは確かです。また、スピーカーとヘッドフォンの販売動向や市場規模の予測を比べると、今後も引き続きゲームオーディオをヘッドフォンで楽しむ兆候がみられます。

イヤホン&ヘッドフォンの売上予測と今後5年の成長率は、スピーカーより圧倒的に優位

空間にあるオーディオの認識

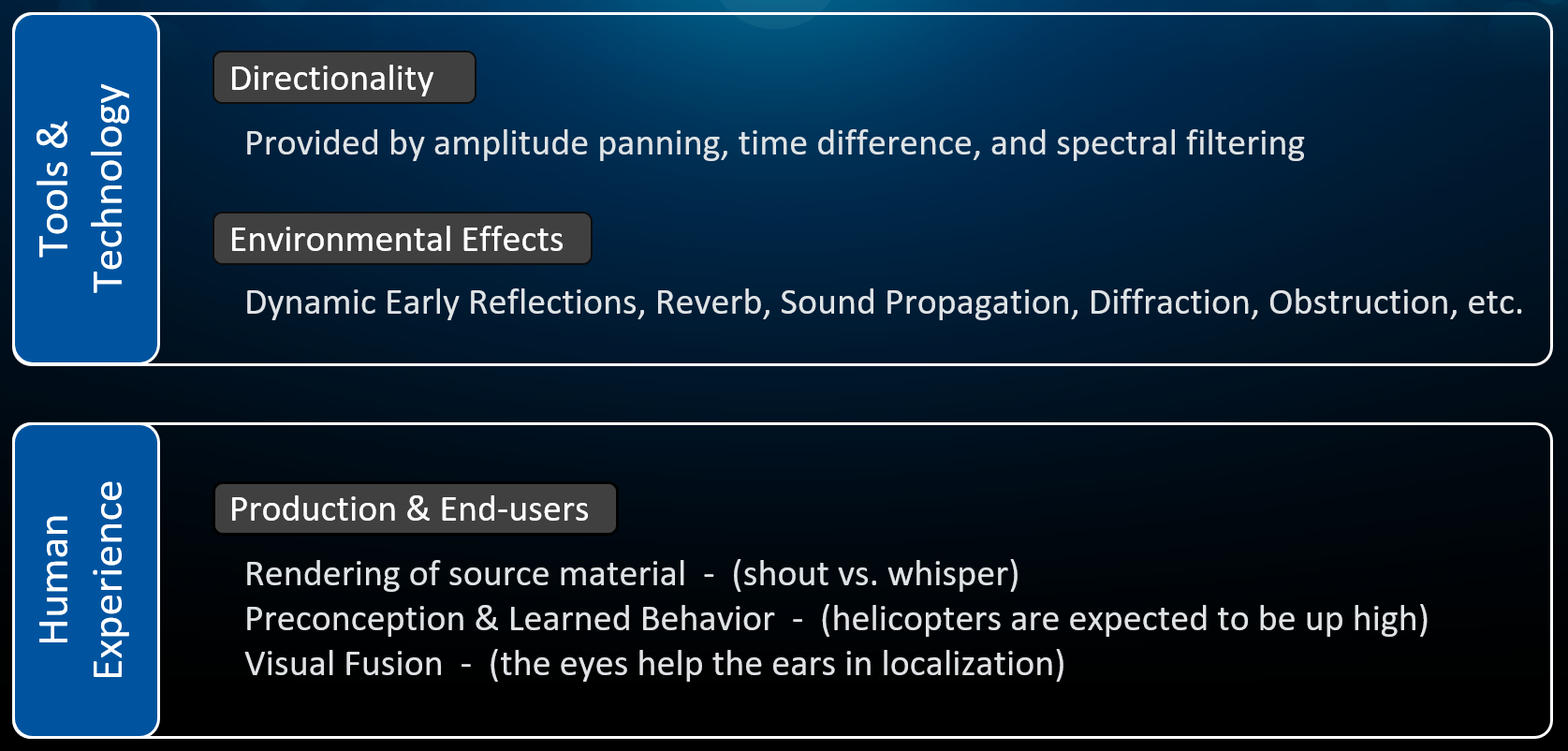

臨場感のある合成音声をスピーカーやヘッドフォンを通して実現するには、2つの要素が共存して補完し合う必要があります。

- ツールとテクノロジー: オーディオ再生技術が、音の物理現象をできるだけ忠実にシミュレーションする必要があります。

- 人間の経験: 人間としての私たちの期待値に見合う性能が必要です。

それでは、この2つの要素をもう少し詳しく見てみましょう。

私たちが自然で経験するのと同じように、空間にある合成音を認識するときに、「テクノロジー」と「人間としての経験」の2つの要素が影響します。

Directionality(方向性の再現)

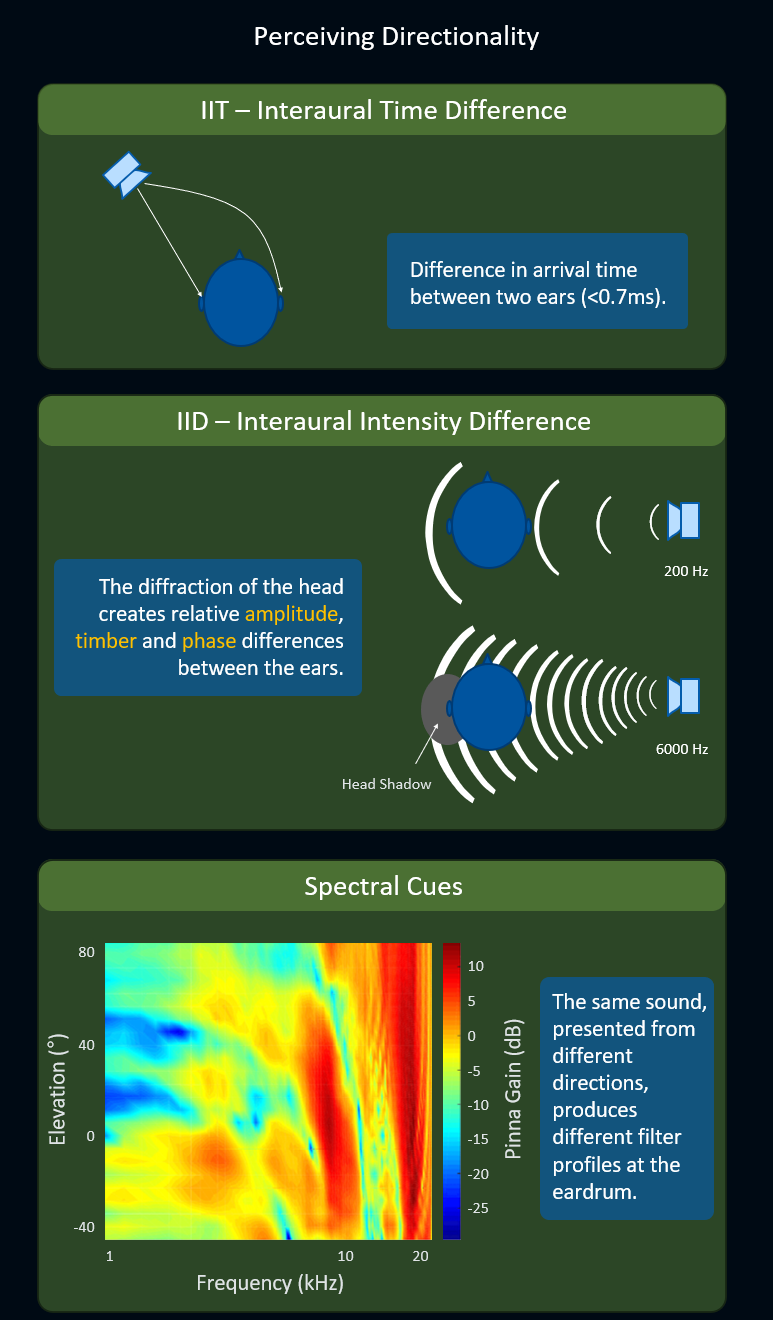

一般的にHRTF(Head Related Transfer Function、頭部伝達関数)が、ヘッドフォンで音の方向性を高精度に再現したいときの最良の技術です。音の方向性を正確に再現するために、HRTFアルゴリズムは以下のような知覚的なキュー(合図)を活用します。

- ITD(Interaural Time Difference、両耳間時間差): 1つの音が耳に到達するまでの時間の、両耳間の差を表します。1ミリ秒にも満たない時間差ですが、脳が方向性を認識するにはこれで充分です。

- IID(Interaural Intensity Difference、両耳間強度差): 両耳のどちらかにとっては頭部が音を遮る結果となり、相対的な振幅、音色、位相の差が両耳間で発生することを表します。信号の周波数に応じて、この効果はより強く出たり、弱く出たりします。

- スペクトルキュー: 同じ音が異なる方向からくるときの、鼓膜における周波数の凹凸の異なるパターンを表します。

ITD、IID、スペクトルキューのテクニックを使い、リスナー周りで空間化された音の精度を上げる。こちらの記事 がHRTFの測定方法を分かりやすく解説。

Environmental Effects(環境エフェクトの再現)

ほかにも技術的に再現できるのが、距離減衰、ダイナミック初期反射、後期残響、音の伝播、回折、オブストラクションなど環境からくるエフェクトです。これらの現象の要素を多く使えば使うほど、脳が受け取る情報が増え、音の空間的な位置を把握しやすくなります。なお、環境エフェクトが音の3D空間化にいかに寄与するかについては長々と書けますが、この記事では、チャンネルベースのオーディオよりもオーディオオブジェクトの方が有利な部分に焦点を当てたいと思います。

Human Experience(人間の経験値)

私たちが空間の中の音の位置を把握するときに影響するもう1つの要因が、テクノロジーではなく、人間としての経験からくる3つの特徴にあります。

まず「音源素材のレンダリング」とも言える点で、例えば、誰かがささやくのが聞こえるのは、おそらくその人が近くにいるからで、ほかの人が同じ言葉を大声で叫んだときよりも絶対的に近くいるはずです。

2つ目の点は「先入観と学習行動」からくるもので、私たちは人間として、ヘリコプターや飛行機など特定の音は当然、頭上から聞こえてくるものだと考えます。これは、人が成長しながら徐々に身につける感覚です。

最後の3つ目の点は「視覚との融合」とも言えるもので、3D空間で発せられる音の正確な位置をとらえようとするときに、目が耳を助けます。例えば、視界の外から音が聞こえた場合に、左側のどこかにあると推測できても、頭を動かして音の発生源を目で見た時に初めて、その物体が空間のどこにあるのかを厳密に把握できるのです。

人間が空間で音声を把握する際に経験値が関与することについては、ブライアン・シュミットのMIGS 2017 での素晴らしい講演「Technology's Impact on Creativity, Case Study: Beyond HRTF」で詳しく説明されています。

チャンネルベースのオーディオ

私たちが空間の中で音を認識する方法や、この認識を導く重要な合図を再現する技術が明らかになったところで、レコードやカセットテープ、デジタルなど様々な媒体だけでなく、Wwiseなどのランタイムアプリケーションにおいても、方向性や環境エフェクトを符号化するために様々なチャンネルベースのフォーマットを長年にわたり使用してきた流れを整理してみます。

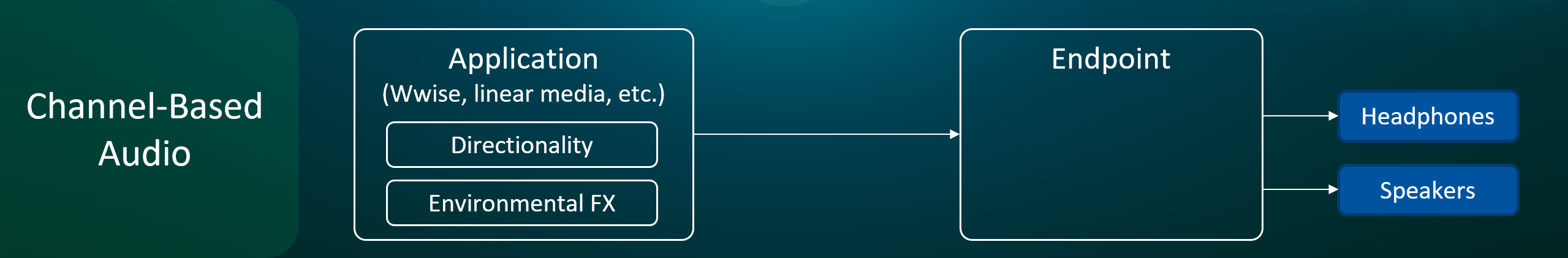

チャンネルベースのフォーマットでは、方向性や環境エフェクトをアプリケーションで符号化

チャンネルベースのフォーマットに頼って空間化を符号化することは、当時の技術や演算能力を考慮すれば、利便性の高いソリューションでした。ところが、より精度の高い空間化が必要となると、様々な欠点があらわになります。典型的な弱みとして、チャンネル同士のポジション間の不均衡な角度によって生じる画像の歪みや振幅の減少、高速で動くサウンドの位相の問題、平面や半球上でしか音を再現できないコンフィギュレーションなどがあります。また、スピーカーが不足していたり、位置が間違っていたり、位相のずれた配線があったりなど、消費者レベルの現実問題に配慮していません。

なお、理論的にはチャンネルベースのフォーマットであるアンビソニックスには、上記の欠点が該当しないことをここで指摘したいと思います。アンビソニックスは、半球状に表現されたオーディオシーンの符号化にチャンネルを使いますが、チャンネル数が多いほど、オーディオシーンの精度が高まります。こちらの記事がアンビソニックスフォーマットの概要や、中間的な空間的表現としての使い方を分かりやすく紹介しています。

「エンドポイント」とは?

エンドポイントは、ヘッドフォンやスピーカーに送り出す音声の最終的な処理やミキシングを行うシステムデバイス(例 プラットフォームのOSレベルでオーディオを担当する部分)を指します。

ゲームを初期化するときに、エンドポイントのオーディオコンフィギュレーション(2.0、5.1、Windows Sonic for Headphones、PS5 3D Audioなど)をWwiseに通知し、Wwiseは、エンドポイントに必要なフォーマットにオーディオをレンダリングします。

オーディオオブジェクトの登場

長年にわたり、リニアオーディオやノンリニアオーディオをミキシングするサウンドエンジニアの鉄則は、制御された環境で作業をすること、そしてその時点で可能な限り多くのオーディオチャンネル数(5.1、7.1など)の高品質スピーカーを使用することでした。この方法だとチャンネル数を減らしても、複数の消費者レベルのリスニング環境において、一貫性のあるミックスと明瞭なダイアログを確保できます。考え方としては実用的ですが、先に述べたようにチャンネルベースのフォーマットを使った空間の符号化に固有の制限があり、空間的な位置の精度に欠けます。

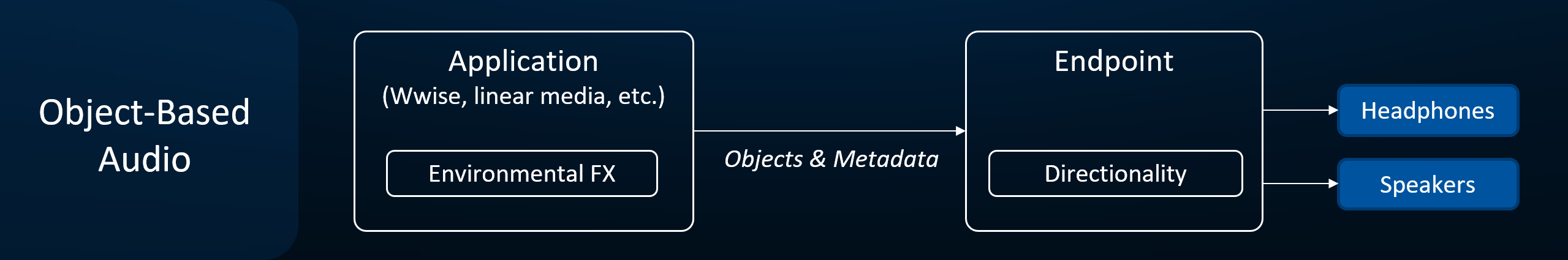

より良い音の空間化をエンドユーザーに届けるには、方向性の符号化をエンドポイントに託した方が得策です。エンドポイントの方が、エンドユーザーがどのようにコンテンツを聞いているのかを、正確に把握できる立場にあり、ユーザーが設定したコンフィギュレーションや、オーディオチェーンのその他のデバイス(レシーバー、TV、サウンドバーなど)とのハンドシェイクを通じて分かっています。そこで、エンドポイントが最終的なミックスをヘッドフォンまたはスピーカーに届けるときに、最も適したレンダリング方法を採用できます。

オブジェクトベース形式では、方向性の符号化をエンドポイントに委託。

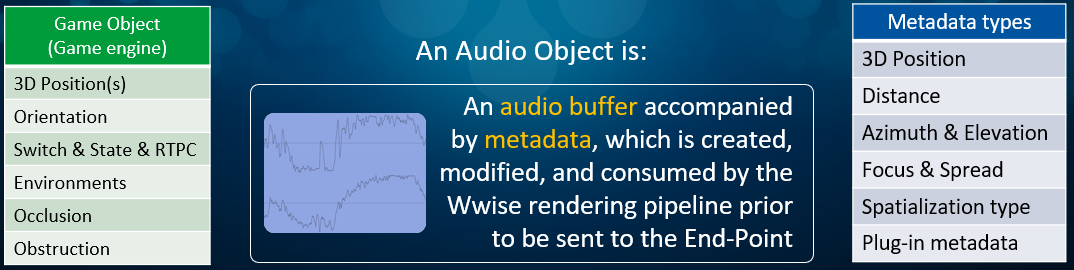

最も適した方向性を表現するには、アプリケーションがエンドポイントに豊富な情報を提供する必要がありますが、それは、一連のオーディオオブジェクトと、関連するメタデータという形で渡されます。具体的にオーディオオブジェクトが示すのは、オーディオバッファと、それに伴うメタデータの組み合わせであり、これはエンドポイントに送られる前に、Wwiseのレンダリングパイプラインによって作成・変更されます。オブジェクトに添付されるメタデータの種類(Metadata types)はWwiseが生成し、オーディオ情報やプラグイン情報に関係します(下図の青いボックス)。なお、これをゲームエンジンのゲームオブジェクト(Game Object)が持つ情報の種類(緑のボックス)と混乱しないように注意してください。

オーディオオブジェクトと共に提供されるメタデータの種類(青いボックス)と、ゲームオブジェクトが提供する情報(緑のボックス)。

結論

この記事で、ユーザーごとに異なるであろうエンドユーザーの実際のデバイス上で空間化を実行するときに、オブジェクトベースオーディオの方が品質も精度も高いという点を明らかにしました。この新しいアプローチは、これまでになく自然な音の空間化をもたらしてくれると同時に、オーサリング時に、ほかの検討内容も可能にしてくれます。これらについては、3部からなるこの連載の第2弾で、ご紹介します。

コメント