Prologue

Introduction

Aperçu du système de musique

Contenu

Synchronisation des PNJ avec la musique

《一剪梅》Lecture aléatoire des poèmes chantés

《望海潮》Compagnon fredonnant une mélodie scénique pendant les pauses ou en synchronisation avec la musique

Synchronisation des poèmes chantés 3D avec la bande musicale 2D

Synchronisation de la bande musicale et des soutras 3D des PNJ

Évolution de la musique scénique en temps réel

Conception des transitions entre les différentes régions de musique scénique en évitant les changements fréquents et gênants

Musique scénique et gestion des silences

Détails techniques

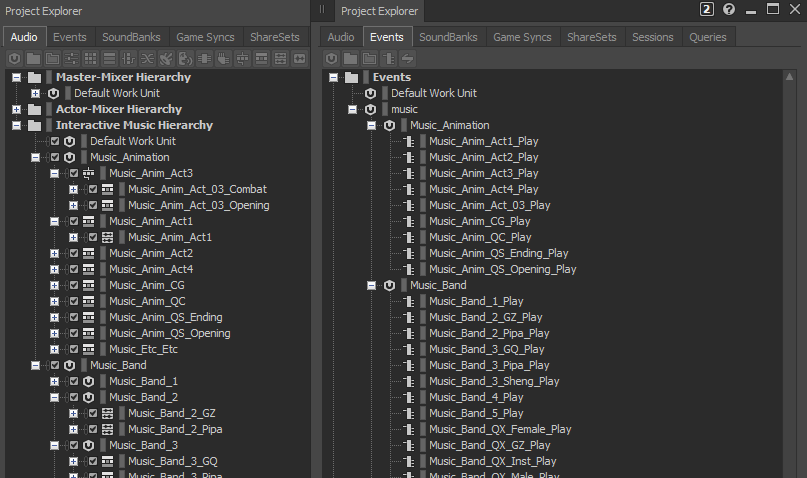

Organisation du projet Wwise

Groupes de musiciens

Musique de combat

Connecter les Conductors au monde

Épilogue

Prologue

« Comment puis-je renforcer l'immersion et le réalisme dans les jeux vidéo, au-delà du simple usage d'une bande musicale en fond sonore ? » En tant que superviseur musical et compositeur principal sur ce projet, c'est avec cette question en tête que j'ai orienté mes recherches dès le début du projet.

Introduction

Condor Heroes (射雕) est un jeu MMO en monde ouvert dans un style chinois, se déroulant à l'époque de la dynastie Song (960-1279), et dont l'histoire est inspirée du roman d'arts martiaux de Jin Yong (Louis Cha) « La Légende du héros chasseur d'aigles ». Selon l'histoire de la Chine, la dynastie Song fut une période prospère, marquée par un essor économique et culturel ainsi qu'un développement notable de la diversité musicale, dont les formes les plus populaires étaient les spectacles de groupes folkloriques traditionnels, organisés dans des lieux d'art populaire appelés Goulan Washe (勾栏瓦舍).

Par ailleurs, selon les recherches, les mètres poétiques chinois (词牌 : les vers respectent une structure et une prosodie fixes régissant rythme et phonologie) se prêtent davantage à la mise en musique que la poésie chinoise ancienne. À l'époque, ils étaient couramment utilisés comme vecteurs de promotion culturelle, les paroles évoquant souvent la situation politique, l'esprit du temps et les sentiments de la société.

Groupe de musiciens folkloriques tiré du jeu, jouant des poèmes chantés chinois

Et si je faisais « revivre » ces groupes folkloriques traditionnels en les intégrant comme musique 3D, en leur dédiant des scènes spécifiques dans le jeu et en leur composant de nouvelles œuvres basées sur des mètres poétiques (词牌) correspondant à l'époque et aux récits du jeu ? Cela permettrait de recréer le quotidien des civils d'autrefois, offrant ainsi aux joueurs et aux personnages du jeu une immersion plus profonde, comme s'ils revivaient véritablement le passé.

Voici l'arrangement final des instruments chinois utilisés (de gauche à droite, dans l'image ci-dessus) : 筚篥 Hichiriki (Bili), 箫 Xiao, 小镲 Petites cymbales, 古琴 Guqin, 琵琶 Pipa, 缶 Fou, 大鼓 Grand tambour, 碗琴 Wanqin, 拨浪鼓 / 小笛 Hochet-tambour / petite flûte (joués par les jumelles), 碰铃 / 古筝 Clochettes / Guzheng (joués par les jumeaux), 尺八 Shakuhachi, 方响 Fangxiang, 笙 Sheng, 檀板 Tanban, parfois accompagnés de 箜篌 Konghou et 三弦 Sanxian.

Tous ces instruments sont joués en 3D avec des courbes d'atténuation naturelles simulées par Wwise ; ainsi, pour les joueurs qui se retrouveraient égarés, cette musique pourrait servir de guide dans un système de « navigation sonore » ou simplement comme un easter egg pour ceux qui la découvriraient par hasard.

Une fois la conceptualisation de ce groupe de musique folklorique terminée, une question essentielle s'est posée concernant la manière dont ces mètres poétiques chantés allaient être intégrés dans le jeu et la logique de lecture à adopter. Vous vous posez peut-être certaines questions. Par exemple :

- Ces poèmes chantés en 3D risquent-ils d'entrer en conflit avec la logique de lecture de la bande musicale en 2D ?

- Que se passe-t-il avec la bande musicale lorsque les joueurs s'approchent de ces groupes de musiciens ?

- Etc.

Dès les premières étapes de développement du jeu, j'ai travaillé sur la conception d'un système de musique global et j'ai choisi de m'éloigner des compositions classiques, des règles de lecture habituelles et des formes d'expression conventionnelles de la musique dans les jeux vidéo chinois traditionnels.

Cet article débutera avec les poèmes chantés en 3D mentionnés précédemment. Il se focalisera principalement sur les fonctionnalités suivantes de notre système de musique interactive, et détaillera le travail technique de notre programmeur audio.

- Synchronisation des poèmes chantés 3D et des fredonnements aléatoires 3D des PNJ.

- Synchronisation des poèmes chantés 3D avec la bande musicale 2D.

- Synchronisation de la bande musicale avec les chants de soutras 3D des PNJ.

- Évolution dynamique de la musique scénique en temps réel.

- Conception des transitions entre les différentes régions de musique scénique, évitant des changements trop fréquents et gênants.

Aperçu du système de musique

Après une première exploration, il est devenu évident que l'approche typique de Wwise, consistant à utiliser un unique Event de musique contrôlé par des States globaux ou des Switches, serait trop rigide pour nos besoins qui incluaient les éléments suivants :

- Il ne devrait pas y avoir de frontière nette entre la musique diégétique et la musique non diégétique. La première peut devenir la seconde et inversement. De plus, certains éléments d'un thème musical peuvent être diégétiques tandis que d'autres ne le sont pas ; ces éléments eux-mêmes peuvent apparaître et disparaître de façon dynamique en fonction de la conception du niveau, du code du jeu ou même d'une séquence cinématique.

- Le jeu propose un monde vaste et détaillé, rempli de personnages, de lieux et de rencontres. Le système de musique doit pouvoir donner la priorité à l'un ou l'autre selon la situation, programmer des moments de silence et gérer ce qui se passe lors des pauses.

- Le jeu étant basé sur un livre, la narration y occupe une place centrale. Il comporte de nombreuses séquences linéaires et cinématiques qui doivent être synchronisées avec la musique, parfois sur un rythme précis.

Il est évident que cela nécessite la prise en charge d'au moins plusieurs émetteurs 3D de musique, de callbacks, d'un système de priorisation et, en plus de tout cela, d'un grand nombre d'outils d'édition. Tout cela a été implémenté dans ce que nous avons appelé un « Conductor System » (système de chefs d'orchestre), composé de trois éléments principaux :

- Un « World Conductor » (chef d'orchestre du monde). Il s'agit d'une entité globale qui met en file d'attente, établit des priorités et programme la lecture des thèmes musicaux en fonction d'ensembles de règles définies dans des tables de données. Par exemple, les musiques scéniques ont généralement une priorité plus faible que les autres musiques et sont suspendues pendant les combats. Le World Conductor peut également transmettre des callbacks musicaux en dehors du système de musique afin de synchroniser des éléments de gameplay (par exemple lors de cinématiques).

- Des « Music Conductors » (chefs d'orchestre de musique) qui gèrent le flux de contrôle du thème musical et coordonnent une ou plusieurs sources musicales jouant simultanément. Ils peuvent également maintenir un état en interne si nécessaire. Par exemple, nous pouvons enregistrer la dernière position de lecture d'un thème musical afin de la reprendre plus tard (dans le cas où un thème ayant une priorité plus élevée aurait été déclenché entre-temps).

- Les « Music Sources » (sources musicales) sont des entités qui exécutent les commandes d'un Music Conductor et les transposent en appels API de Wwise. Chaque source peut être placée à un endroit arbitraire dans le monde du jeu. La première Music Source d'un Conductor est toujours considérée comme une « piste guide » - elle est utilisée pour collecter les callbacks, et toutes les autres sources sont synchronisées avec elle si nécessaire.

Il s'agit d'une architecture simple en strates, où les entités de niveau inférieur ne connaissent pas celles de niveau supérieur. De plus, les Music Conductors et les Music Sources devaient avoir leurs interfaces Blueprint respectives. Cela a généré quelques problèmes de configuration au départ, mais nous a ensuite permis d'ignorer complètement la logique de lecture de la musique, tout en restant intégrés au mécanisme de priorisation et de programmation du World Conductor. Par exemple, à un moment donné, nous avons voulu ajouter un instrument virtuel avec lequel les joueurs pourraient interagir et jouer une mélodie harmonisée avec un thème musical en cours de lecture. Tout ce que nous avons eu à faire a été de créer une Music Source spécifique ne jouant pas de musique à proprement parler, mais capable de reconnaître l'accord du thème musical en cours de lecture auquel elle appartenait, et qui contenait une heuristique simple permettant de déclencher des notes aléatoires mais en harmonie.

Le comportement du système de musique est configuré via les assets et tables de données d'Unreal. Comme le World Conductor sépare les détails de l'implémentation du code du jeu, l'intégration avec les cinématiques et les systèmes de dialogue, ainsi que l'implémentation de l'interface utilisateur de debug et l'ajout d'acteurs de délimitation de niveaux ont été un jeu d'enfant. La mécanique de States du World Conductor gère dynamiquement les transitions, quel que soit l'endroit d'où provient la requête de contrôle musical. L'un des systèmes intéressants que nous avons développés est ce que nous avons appelé le « Conductor Sequencer » (Séquenceur de chef d'orchestre). Il permet de séquencer les commandes envoyées au World Conductor à la manière d'un tracker, et nous l'avons largement utilisé dans des situations scénarisées où la musique devait suivre un flux de contrôles strict.

Contenu

Synchronisation des PNJ avec la musique

《一剪梅》Lecture aléatoire des poèmes chantés

Ce texte poétique utilise des descriptions scéniques pour évoquer des émotions. Il dépeint des scènes imprégnées d'une profonde nostalgie, à la fois vibrantes et rustiques. Voici quelques éléments clés concernant la conception sonore :

- Facile à chanter et entraînant (pour les civils).

- Les enfants PNJ peuvent chanter en chœur.

- Éviter la complexité des textures instrumentales chinoises, privilégier la simplicité.

Le fredonnement des joueurs et des PNJ est déclenché de manière aléatoire et synchronisé avec le poème chanté. Nous avons demandé à nos acteurs vocaux d'interpréter ces chants.

Dans la capture vidéo ci-dessous, vous pouvez entendre que nous avons positionné les instruments et les voix à différents endroits (visibles dans la capture d'écran) afin de simuler l'idée que « Toutes les familles habitant dans cette zone de jardin se réunissent souvent pour jouer des instruments et chanter ensemble » ; même les enfants (PNJ) fredonnent en jouant avec leurs cerfs-volants. De plus, afin de refléter le caractère culturel de cette musique transmise de génération en génération, cela a permis d'imprégner cette zone d'un charme rustique.

En raison de la proximité des différents modèles de personnages, les joueurs peuvent entendre des strates musicales synchronisées provenant de différentes directions, quels que soient leurs déplacements.

《望海潮》Compagnon fredonnant une mélodie scénique pendant les pauses ou en synchronisation avec la musique.

Dans la plupart des cas, le PNJ qui suit le joueur n'interagit que pendant les moments de combat. Cependant, dans ma philosophie de conception, le PNJ qui accompagne le joueur reste un enfant tout au long du jeu, et il fredonne occasionnellement des airs et se montre parfois espiègle ; j'ai donc décidé de lui insuffler un peu de « spiritualité » (juste pour lui donner une petite touche de vie).

Dans la capture de jeu ci-dessous, vous pouvez entendre le frère fredonner de manière aléatoire des bribes de poèmes chantés, tout en restant parfaitement en rythme.

Synchronisation des poèmes chantés 3D avec la bande musicale 2D

Dans une ville, un groupe peut jouer une chanson (par exemple 《无题》), synchronisée avec la bande musicale de la région. Cependant, cela soulève un problème potentiel : ne risque-t-elle pas d'entrer en conflit avec la bande musicale ?

Pour cette situation, j'ai suivi les principes de conception suivants :

- Limiter la durée de lecture des groupes de musiciens jouant des poèmes chantés.

- Faire en sorte que la bande musicale soit jouée en parfaite synchronisation avec les poèmes chantés.

- Composer la bande musicale avec un tempo et une instrumentation inspirés de la musique du poème chanté, afin qu'elles s'entrelacent harmonieusement.

- Ajuster dynamiquement le volume de la bande musicale en fonction de la proximité.

En résumé, le résultat final est que chaque fois que le joueur s'approche de l'objet 3D, le volume de la bande musicale diminue progressivement, dirigeant ainsi l'attention vers l'objet 3D. De plus, comme les vitesses, les tonalités et les progressions harmoniques des deux morceaux de musique sont exactement les mêmes, le joueur n'a pas l'impression d'un « changement brutal de musique » mais, au contraire, d'une transition fluide entre les deux morceaux qui continuent d'exister de manière indépendante une fois qu'il s'éloigne. Cette transition est subtile et difficile à remarquer sans une écoute attentive, ce qui brouille également les frontières entre musique diégétique et non diégétique.

Des règles de synchronisation similaires ont été appliquées à de nombreux autres endroits du jeu.

Synchronisation de la bande musicale et des soutras 3D des PNJ

Le temple de Lingquan est l'un des temples bouddhistes historiques les plus emblématiques, occupant également une place importante dans le jeu. En raison de son caractère sacré, je ne voulais pas me contenter d'une bande musicale thématique pour instaurer une sérénité solennelle, comme c'est souvent le cas, mais j'espérais plutôt pouvoir y intégrer de nouveaux éléments. En matière de conception sonore, outre les poissons en bois et les cloches frappés par les moines dans le temple, y avait-il d'autres éléments particuliers à exploiter ?

C'est ainsi qu'est née l'idée d'intégrer le chant quotidien des moines récitant les écritures bouddhistes.

J'ai demandé à un ingénieur du son de se rendre dans un temple bouddhiste en Chine afin d'enregistrer et de collecter des échantillons de ces prières chantées. Une fois les enregistrements reçus, j'ai procédé aux étapes suivantes :

- Synchroniser la tonalité du chant avec la bande musicale.

- Aligner le tempo du chant sur celui de la bande musicale.

- Déclencher aléatoirement les séquences de chant sur le premier temps des mesures de la bande musicale.

Évolution de la musique scénique en temps réel

Certains joueurs joueront inévitablement du matin jusqu'à midi ou de l'après-midi jusqu'au soir, traversant ainsi plusieurs périodes de la journée en une seule session. Étant donné que l'heure du jeu est synchronisée avec l'heure locale du joueur, l'approche classique pour ce type de jeux consiste à attribuer un morceau de musique distinct à chaque période de la journée. Cependant, nous voulions éviter des changements de musique « trop perceptibles ». J'ai donc choisi de faire évoluer et de modifier dynamiquement l'ensemble des thèmes des musiques scéniques en apportant des variations progressives tout au long de la journée au sein des mêmes pistes.

- Définir le matin, l'après-midi et le soir comme trois périodes distinctes de transition musicale.

- S'assurer que les variations musicales proviennent toujours des mêmes pistes.

- Préserver la dynamique musicale en équilibrant à la fois « continuité » et « variation ».

- La musique doit être perçue comme un morceau complet lorsqu'elle est jouée sur une période donnée.

Ainsi, au lieu d'entendre une coupure brutale entre les morceaux, les joueurs ressentiront plutôt que « la musique de cette scène semble s'être enrichie dans l'après-midi » ou que « la musique de cette scène s'est adoucie en soirée ».

Conception des transitions entre les différentes régions de musique scénique en évitant les changements fréquents et gênants

Les descriptions ci-dessus mettent en avant les changements interactifs de musique qui se produisent lorsque le joueur est actif dans une même scène ou dans des conditions fixes. En plus de cela, nous avons également conçu certaines logiques musicales pour les moments où le joueur marche ou se téléporte d'un endroit à un autre, que ce soit en raison de la progression de l'intrigue ou d'une exploration libre.

Pour simplifier, je ne veux pas que les joueurs soient confrontés à un changement immédiat de musique chaque fois qu'ils entrent dans une nouvelle zone. Une telle répétition serait ennuyeuse et fatigante, et étant donné qu'il est possible d'entrer dans une zone et d'en sortir immédiatement par erreur, il est préférable d'introduire un temps de reconnaissance tampon et un « intervalle de silence ». Par exemple :

Pour les scènes régulières :

- Activer l'action musicale en cours lorsque le système détecte que le joueur est resté dans une nouvelle zone pendant un certain temps.

- Activer la nouvelle musique après un certain nombre de secondes d'intervalle de silence.

Pour certaines scènes spéciales :

- Diminuer progressivement certains instruments de la musique en cours et continuer de la jouer sans autres changements.

- Déclencher un court accent musical (stinger) spécifique lorsque le joueur entre dans la nouvelle zone.

Dans les jeux à monde ouvert comme Condor Heroes, les joueurs n'ont pas toujours envie d'entendre de la musique en permanence. L'ajout de 30% à 40% de moments de silence dans la bande musicale peut aider à réduire la fatigue auditive.

Musique scénique et gestion des silences

Les délimitations de niveaux peuvent définir des volumes musicaux qui indiqueront au World Conductor quelle musique doit être jouée dans chaque zone. Par convention, nous avons choisi de ne pas jouer la musique en boucle, permettant ainsi aux joueurs de profiter d'un moment de calme avant que la musique ne reprenne plus tard. Pendant ces pauses, le système de musique informe le jeu que les personnages peuvent jouer des événements vocaux spéciaux, comme fredonner ou siffler des mélodies et des motifs de la musique précédemment jouée.

Le World Conductor connaît également l'heure actuelle du jeu et peut programmer des variantes du thème correspondant au matin, à la journée ou à la nuit. De plus, un « moment calme » configurable peut être programmé pendant lequel aucune musique scénique ne sera déclenchée.

Des zones d'exclusion peuvent être définies pour faire disparaître progressivement la musique d'une zone lorsque le joueur s'approche de certains endroits, soit pour en souligner l'importance, soit pour laisser de l'espace aux événements qui se produisent ou qui sont sur le point de se produire.

La musique d'une zone peut être interrompue par des combats ou d'autres rencontres, car elle a généralement la priorité la plus basse. Dans ce cas, le World Conductor mettra en pause le thème en cours de lecture et le reprendra après qu'un thème de priorité plus élevée ait été explicitement arrêté. Par ailleurs, les événements mis en pause sont toujours considérés comme des voix actives dans Wwise car ils influencent l'auto-ducking.

Le World Conductor peut également réaliser d'autres transitions plus complexes, similaires à celles disponibles dans Wwise, telles qu'une synchronisation de base sur la mesure musicale et la lecture de stingers pour masquer les transitions. Ces transitions sont configurées dans des tables de données.

Détails techniques

Organisation du projet Wwise

Chaque thème musical composé pour le jeu possède sa propre hiérarchie, indépendante des autres. Les Work Units sont organisées en fonction de l'usage de chaque musique, telle que la musique de combat, scénique ou de séquence linéaire, entre autres. Chaque type de musique est assigné à son propre bus afin de faciliter le mixage et de permettre à l'auto-ducking de fonctionner de manière sélective lorsque cela est nécessaire.

Le fait que chaque thème musical soit isolé des autres a augmenté la complexité de l'implémentation du côté du moteur de jeu, qui devait désormais gérer les transitions, les stingers, les fondus enchaînés, ainsi que les silences et la synchronisation. Ces deux derniers points étaient particulièrement importants pour nous, car ils impliquaient des exigences spécifiques difficiles à gérer avec une musique contrôlée par un seul PlayingID, ce que nous aborderons plus en détail plus tard.

Nous avons essentiellement retiré une grande partie de la complexité du projet Wwise et l'avons réintroduite dans le code. L'implémentation de la musique varie, parfois considérablement, selon son type. Par exemple, certains thèmes suivent la structure typique d'un Switch Container, tandis que d'autres dépendent du code pour pouvoir être lus en boucle. En termes de système de musique, différentes classes de « Conductors », que je vais tenter de décrire ci-dessous, ont été implémentées.

Groupes de musiciens

Cette musique diégétique est représentée dans le jeu par un groupe de musiciens virtuels qui interprètent des chansons à des moments précis. Le joueur peut entrer en mode d'écoute et la caméra commence à se déplacer autour des personnages. Voici les exigences impliquées :

- Chaque instrument ou voix peut être positionné individuellement dans une scène.

- Les thèmes musicaux ne sont pas lus en boucle.

- Bien qu'il s'agisse d'un jeu à un seul joueur, les joueurs doivent entendre les groupes de musiciens se produire à des moments précis, de sorte que tout le monde entende à peu près la même chose, même si des joueurs rejoignent le jeu en plein milieu de la représentation.

Je vois deux façons d'implémenter une musique diégétique parfaitement synchronisée entre plusieurs endroits du monde : en gérant un groupe d'envois vers des bus auxiliaires 3D, ou en jouant chaque instrument en tant qu'Event séparé. Nous avons choisi la seconde solution. Je ne me souviens plus pourquoi. Nous avons observé que lorsqu'un groupe d'Events de la même longueur est posté avant l'appel à AK::SoundEngine::RenderAudio, il sera joué de manière synchronisée de manière permanente. Avec la contrainte que ces Events doivent avoir des paramètres identiques de streaming, de virtualisation et de table de recherche, ce que nous avons géré dans le projet avec l'aide de WAAPI.

De plus, Wwise présente certaines restrictions sur l'action SeekOnEvent que nous avons dû utiliser pour synchroniser la position de lecture de la musique. La plus importante est que les Events lus en boucle ne peuvent pas faire l'objet d'un Seek, ce qui signifie que tous les instruments du groupe sont des one-shots de longueurs égales qui seront mis en boucle par le « Conductor » si nécessaire.

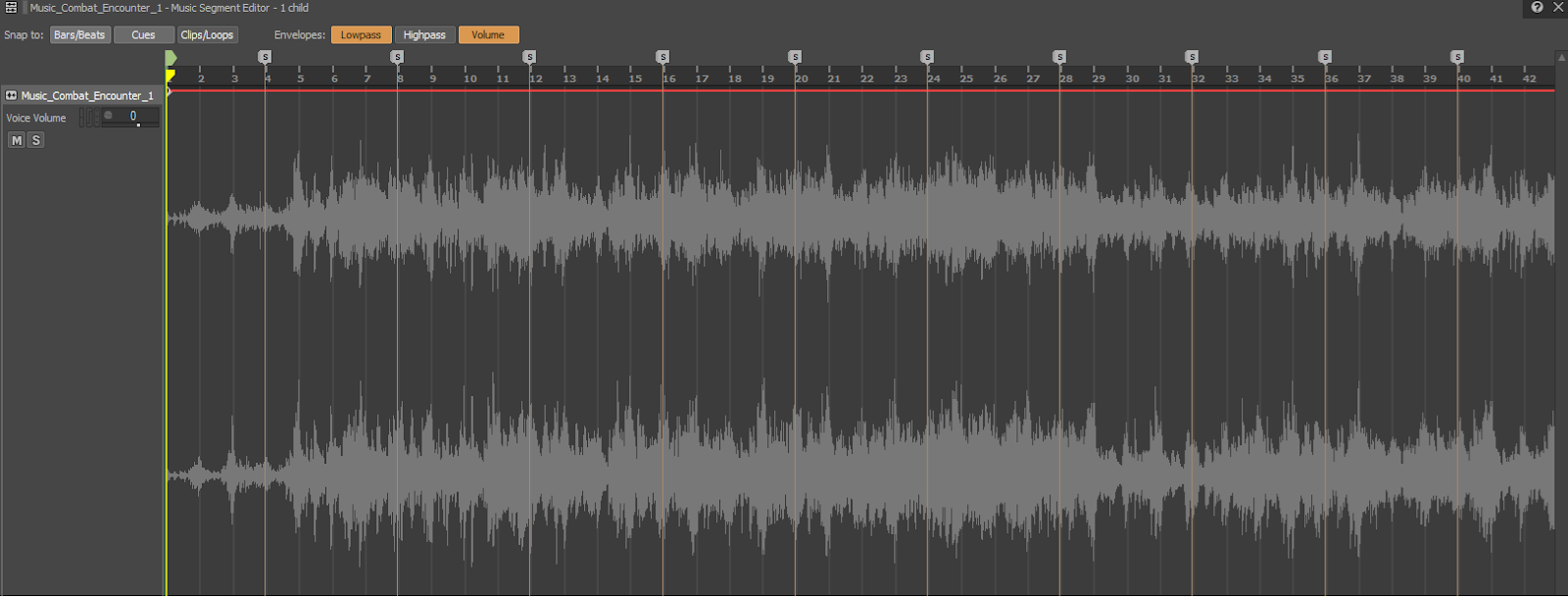

Musique de combat

Le jeu comporte deux types de musique de combat : les combats de boss et les mini-rencontres.

Je commencerai par le premier, car son Conductor suit un modèle d'implémentation typique de Wwise avec des Switch Containers et des transitions. Le combat de boss progresse toujours à travers des parties spécifiées dans une direction ; par exemple, intro → stage 1 → stage 2 → victoire ou échec. Nous avons implémenté un Switch « Music_Part » générique pour cela et avons établi une convention sur la signification de chaque partie numérotée.

Contrairement aux combats de boss, les mini-rencontres n'ont pas d'étapes ; leur musique est préparée comme une boucle infinie. Du point de vue de la composition, la musique est divisée en parties avec des caractères distincts et des courtes transitions entre elles. La musique commence par un fondu d'entrée et s'arrête par un fondu de sortie, le Conductor suit la position de lecture pour reprendre la musique plus tard à l'endroit où elle s'est arrêtée... ce qui serait le cas si la vie était aussi simple. Cependant, dans notre cas, cette musique reprend au marqueur qui suit la position où la musique s'est arrêtée précédemment. Il se trouve que ces marqueurs sont placés là où commencent les transitions. Le fait de commencer la musique sur ces transitions par un fondu renforce le caractère anecdotique et récurrent de chaque rencontre.

Comme cette musique nécessite une fonction Seek, la lecture en boucle est gérée par le Conductor.

En ce qui concerne les fondus d'entrée, Wwise ne fournit pas d'API pour les contrôler à partir du code. Ceci peut être contourné en suivant la séquence suivante : Poster un Event → Mettre en pause l'Event immédiatement → Attendre une frame jusqu'à ce que RenderAudio soit appelé → Reprendre la lecture avec la durée de transition spécifiée. Si vous n'incluez pas une frame de pause, Wwise va essentiellement condenser la séquence de commandes et va penser que l'Event devrait jouer initialement mais ne reprendra pas sa lecture. Je ne me souviens pas pourquoi, mais il y avait une raison pour laquelle nous avons fini par reprogrammer cette méthode de contournement pour utiliser des RTPCs avec des temps d'interpolation pour les fondus.

Connecter les Conductors au monde

Jusqu'à présent, nous avons couvert le fonctionnement interne des différents types de thèmes musicaux. Il nous reste à donner quelques exemples de la façon dont notre système permet une interaction complexe entre la musique et d'autres systèmes de jeu :

- Dans l'un des niveaux, un temple comporte un autel qui déclenche des sons légers en réponse à des callbacks de Wwise.

- En parcourant le monde extérieur, le joueur peut trouver un petit village où un personnage chante une chanson en parfaite synchronisation avec la bande musicale en cours de lecture.

- Un musicien jouant du tambour attire l'attention du joueur sur un endroit spécifique. En l'atteignant, une cinématique commence et met en scène un tournoi de combats. Cette boucle de tambour diégétique se transforme en musique de cinématique non diégétique qui se termine par un coup de gong. Le gong signifiant la fin du combat, il était important pour nous d'avoir une synchronisation parfaite entre son retentissement et les images. Nous avons implémenté cette synchronisation en envoyant un callback depuis le World Conductor vers un Level Sequence qui sauterait à la prochaine coupure cinématique dès sa réception. Le callback a été créé à partir d'une musique Wwise identifiée avec un nom spécial.

Dans tous les exemples, la fonctionnalité a été implémentée avec l'API Conductor ; le code du jeu n'avait pas besoin de connaître quoi que ce soit de Wwise.

Épilogue

Cet article donne un aperçu relativement systémique de notre implémentation de musique interactive à base de « Conductor », en soulignant son rôle central dans l'amélioration de l'immersion du joueur, de l'interaction émotionnelle et de l'expérience de jeu en général. Nous avons travaillé très fort pour faire en sorte que n'importe quel type de bande musicale soit non seulement « émotionnel » mais aussi « rationnel » dans des contextes donnés, et nous espérons que cela a été aussi intéressant pour vous de le lire que cela l'a été pour nous de le développer.

Commentaires